Un groupe de chercheurs de Google a publié une étude révélant comment l’IA est en train de détruire internet en propageant de fausses informations, ce qui est presque ironique étant donné l’implication de l’entreprise dans l’essor de la technologie. L’accessibilité et le niveau littéraire ou visuel des contenus générés par l’IA ont ouvert la voie à de nouvelles formes d’abus ou facilité des pratiques déjà répandues, brouillant encore plus la frontière entre le vrai et le faux.

Depuis son déploiement en 2022, l’IA générative a offert un lot d’opportunités pour accélérer le développement de nombreux domaines. Les outils d’IA disposent désormais de capacités élevées allant de l’analyse audiovisuelle complexe (par le biais de la compréhension du langage naturel) au raisonnement mathématique, en passant par la génération d’images réalistes. Cette polyvalence a permis à la technologie d’être intégrée dans des secteurs critiques tels que la santé, les services publics et la recherche scientifique.

Cependant, à mesure que la technologie se développe, les risques d’utilisation abusive deviennent toujours plus préoccupants. Parmi ces utilisations figure la propagation de la désinformation, qui inonde désormais internet. Une récente analyse de Google a d’ailleurs démontré que l’IA est actuellement la principale source de désinformation en ligne basée sur les images. Le phénomène est aggravé par l’accessibilité accrue de l’outil, permettant à n’importe qui de générer n’importe quel contenu avec une expertise technique minimale.

Cependant, bien que les précédentes études fournissent de précieuses informations sur les menaces liées à l’utilisation abusive l’IA, elles n’indiquent pas précisément les différentes stratégies qui pourraient être utilisées à cette fin. En d’autres termes, nous ne savons pas quelles tactiques sont utilisées par les utilisateurs malveillants pour propager de fausses informations. Or, à mesure que la technologie devient plus performante, il est essentiel de comprendre de quelle manière les mauvaises utilisations se manifestent.

La nouvelle étude, réalisée par une équipe de Google, met en lumière les différentes stratégies utilisées pour propager de fausses informations générées par IA sur internet. « Grâce à cette analyse, nous mettons en lumière les principaux et nouveaux modèles d’utilisation abusive, y compris les motivations potentielles, les stratégies et la manière dont les attaquants exploitent et abusent des capacités du système à travers les modalités (par exemple images, textes, audio, vidéo) », expliquent les chercheurs dans leur document, prépublié sur la plateforme arXiv.

Des utilisations abusives qui ne nécessitent pas d’expertise technique avancée

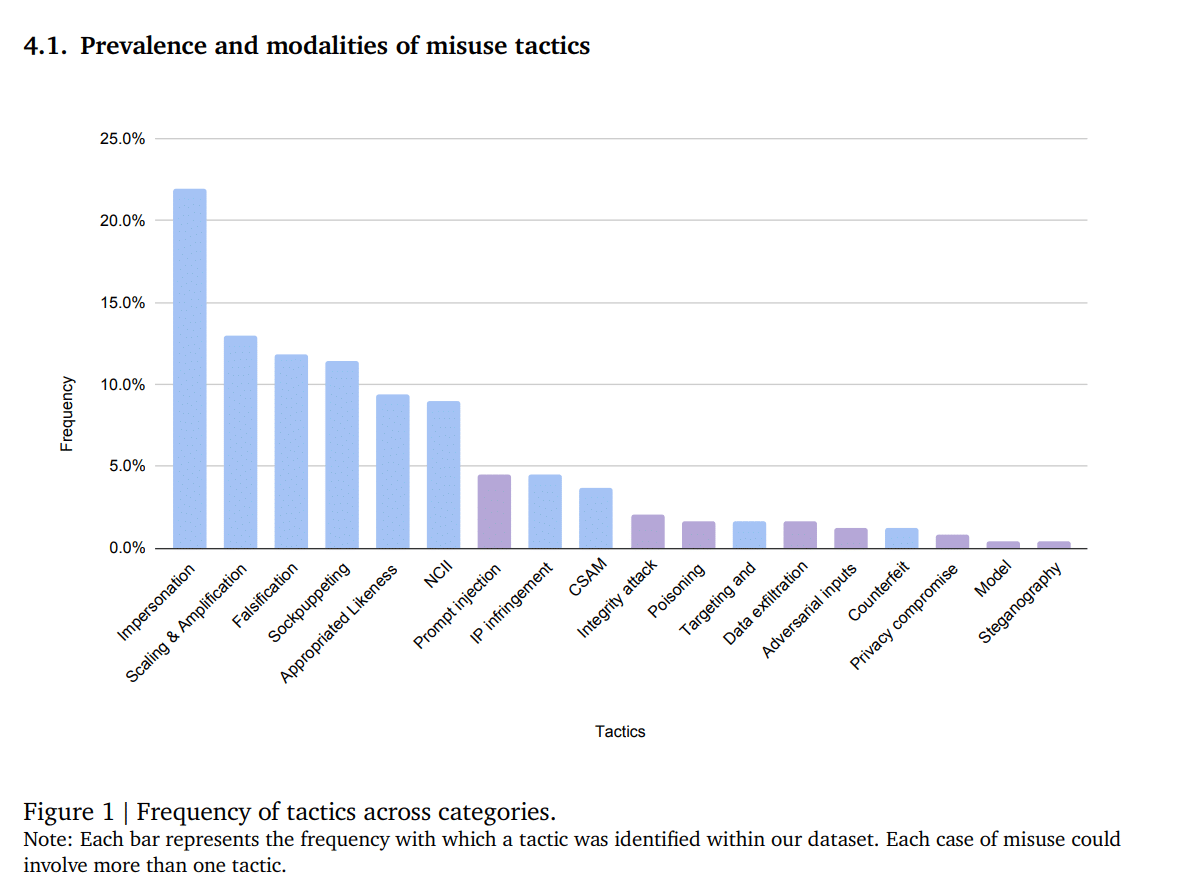

Les chercheurs ont analysé 200 rapports médiatiques de cas d’utilisation abusive de l’IA entre janvier 2023 et mars 2024. Sur la base de cette analyse, les tendances clés sous-tendant ces utilisations ont été identifiées, notamment la manière ainsi que la motivation avec laquelle les utilisateurs se servent de l’outil dans un environnement non contrôlé (c’est-à-dire dans la vie réelle). L’analyse comprenait à la fois les contenus d’images, textuels, audio et vidéo.

Les chercheurs ont constaté que les cas d’abus les plus fréquents sont les fausses images de personnes et la falsification de preuves. La plupart de ces faux contenus seraient propagés dans l’intention manifeste d’influencer l’opinion publique, de faciliter les activités frauduleuses (ou les escroqueries) ainsi que pour générer du profit. D’autre part, la majorité des cas (9 cas sur 10) ne nécessitent pas d’expertise technique avancée, mais s’appuient davantage sur les capacités (facilement exploitable) des outils.

Il est intéressant de noter que les abus ne sont pas explicitement malveillants, mais sont tout de même potentiellement nuisibles. « La sophistication, la disponibilité et l’accessibilité accrues des outils d’IA générative semblent introduire de nouvelles formes d’abus de niveau inférieur qui ne sont ni ouvertement malveillantes ni qui violent explicitement les conditions d’utilisation de ces outils, mais qui ont encore des ramifications éthiques préoccupantes », indiquent les experts.

Ce constat suggère que bien que la plupart des outils d’IA disposent de conditions de sécurité conformes à l’éthique, les utilisateurs trouvent le moyen de les contourner par le biais d’invites judicieusement formulées. Selon l’équipe, il s’agit d’une nouvelle forme de communication émergente visant à brouiller les frontières entre les informations authentiques et les fausses informations. Ces dernières concernent surtout la sensibilisation politique et l’autopromotion. Cela risque d’accroître la méfiance du public envers l’information numérique tout en surchargeant les utilisateurs de tâches de vérification.

D’un autre côté, les utilisateurs peuvent également contourner ces mesures de sécurité d’une autre manière. S’il n’est par exemple pas possible de saisir une invite contenant explicitement le nom d’une célébrité, l’utilisateur peut télécharger sa photo depuis son moteur de recherche puis la modifier à sa guise en l’insérant comme référence dans un outil d’IA.

Toutefois, l’utilisation de données provenant uniquement des médias limite la portée de l’étude, ont précisé les chercheurs. En effet, ces organismes ne se concentrent généralement que sur les informations spécifiques susceptibles d’intéresser leur public cible, ce qui peut introduire des biais dans l’analyse. En outre, le document ne mentionne étrangement aucun des cas d’utilisation abusive des outils d’IA développés par Google…

Néanmoins, les résultats offrent un aperçu de l’ampleur de l’impact de la technologie sur la qualité de l’information numérique. Selon les chercheurs, cela souligne la nécessité d’une approche multipartite pour atténuer les risques d’utilisation malveillante de la technologie.