L’ordinateur quantique H2-1 de 56 qubits de Quantinuum vient de pulvériser un record en surpassant de 100 fois les performances de Sycamore, l’ordinateur quantique de Google. En évaluant ses performances par le biais de l’approche de benchmark d’entropie croisée linéaire (XEB), les chercheurs ont obtenu un score de 0,35, indiquant que le processeur a produit des résultats exempts d’erreurs dans 35 % des cas.

Les ordinateurs quantiques deviennent plus puissants à mesure que le nombre de qubits (ou bits quantiques) qu’ils traitent augmente. On estime qu’à terme, ces ordinateurs pourront effectuer en quelques secondes des calculs complexes qu’un supercalculateur classique mettrait des milliers d’années à résoudre. Le seuil auquel un ordinateur quantique a véritablement surpassé les ordinateurs classiques en matière de calculs est appelé « suprématie quantique ».

Cependant, afin d’atteindre la suprématie quantique, les ordinateurs quantiques doivent pouvoir traiter au moins un million de qubits. La raison est que ces derniers sont intrinsèquement sujets aux erreurs et que le nombre de qubits traités doit pouvoir pallier cela. En d’autres termes, la puissance de ces ordinateurs réside dans leur capacité à traiter le plus grand volume de qubits possible avec le moins d’erreurs possible. Or, le plus grand ordinateur quantique disponible actuellement ne peut exécuter qu’environ 1000 qubits et ce, encore avec un très grand nombre d’erreurs.

Afin de résoudre ces problèmes, les chercheurs se concentrent désormais davantage sur la production de qubits fiables, mais en petit nombre, plutôt que de grands volumes fortement sujets aux erreurs. Dans cette optique, le modèle H2 de Quantinuum est le premier ordinateur quantique au monde à pouvoir créer des « qubits logiques » (ou à correction d’erreurs) relativement fiables.

Lors d’une précédente démonstration en collaboration avec Microsoft, le modèle, configuré avec 32 qubits physiques (à ions piégés), a produit des qubits logiques avec un taux d’erreur 800 fois inférieur à celui des qubits physiques. Cela signifie que les qubits logiques ont un taux d’erreur de seulement 1 sur 100 000, contre 1 sur 100 pour les qubits physiques.

Quantinuum a récemment amélioré son modèle H2 pour passer de 32 à 56 qubits à ions piégés. Le nouveau modèle H2-1 démontre une amélioration significative en rendant impossible la simulation classique et en surpassant Symacore en matière de performances de calcul et de tolérance aux erreurs.

Des résultats exempts d’erreurs dans 35 % des cas

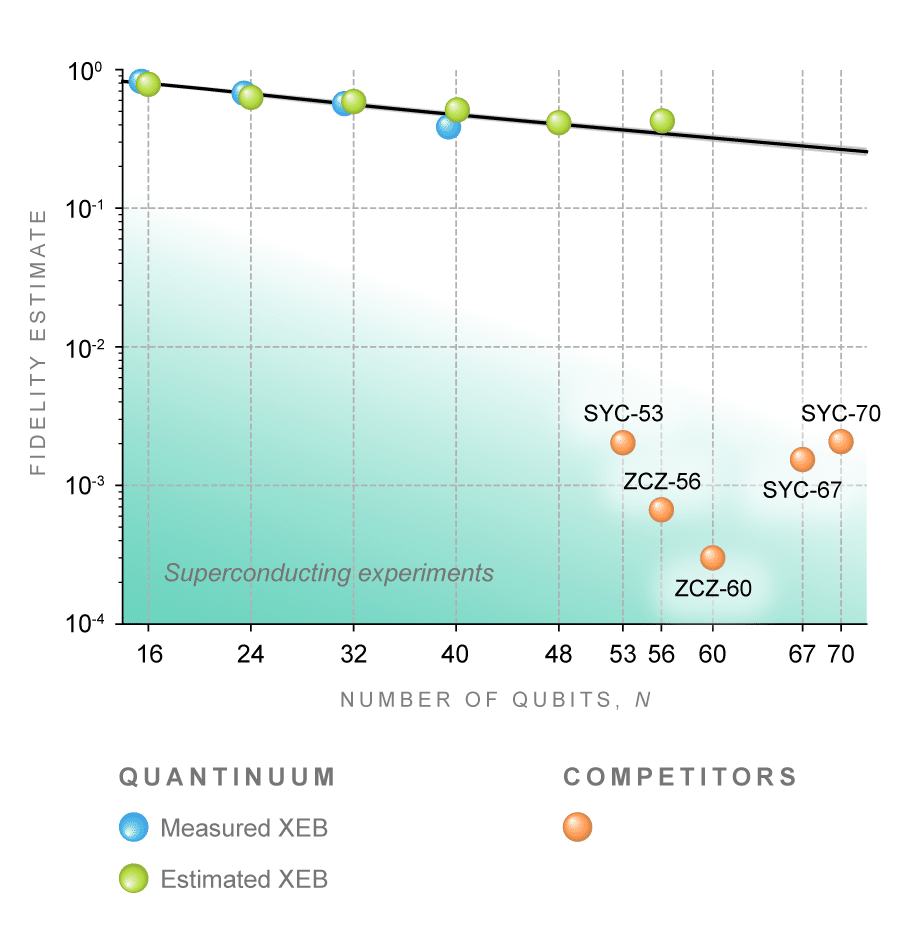

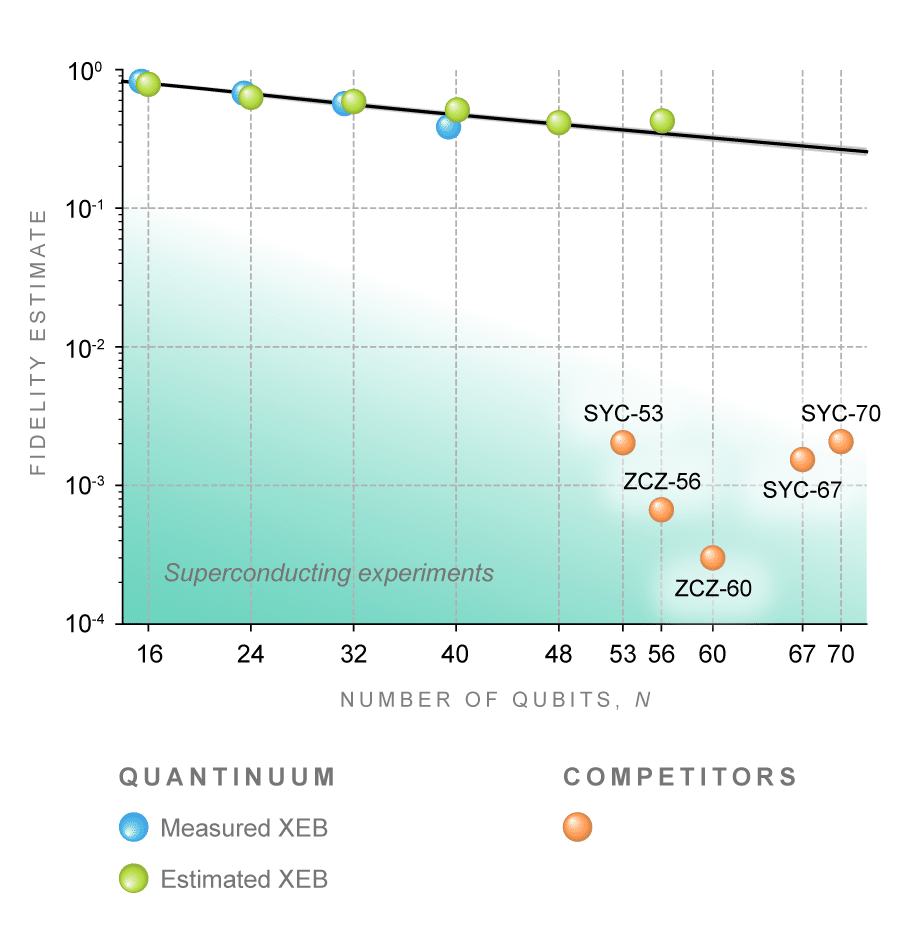

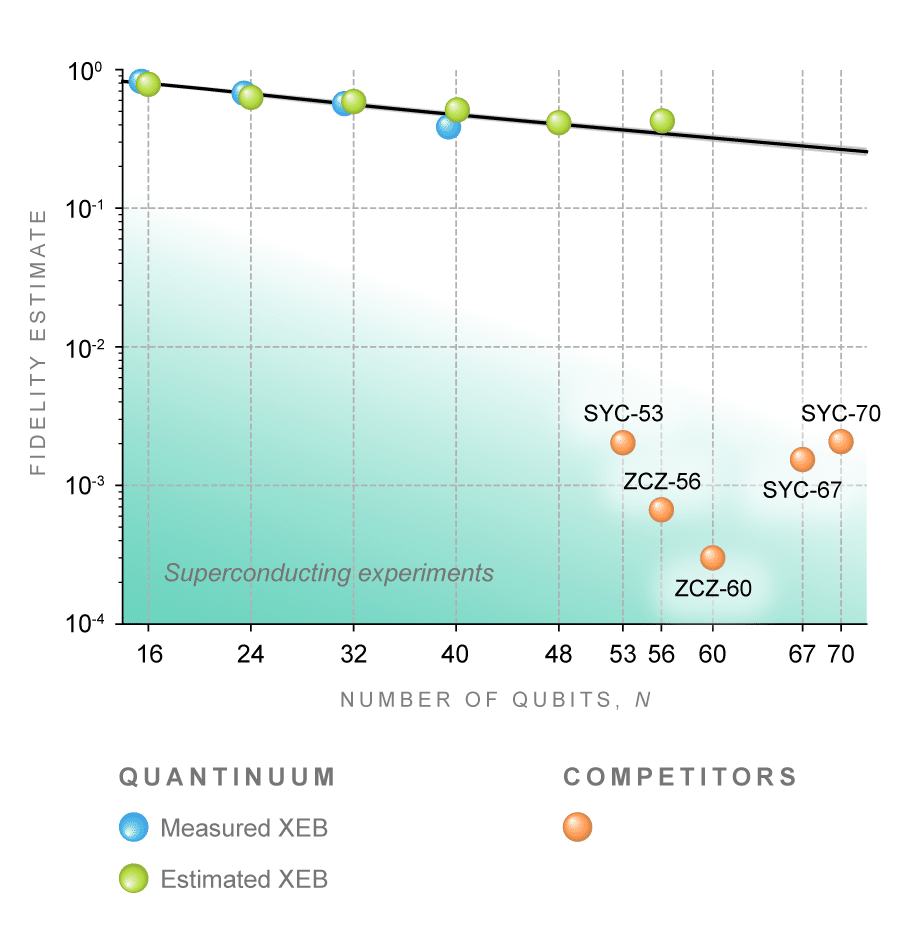

Afin d’évaluer les performances du système H2-1, les ingénieurs de Quantinuum ont exécuté un algorithme courant appelé Random Circuit Sampling (RCS). La qualité des résultats a été évaluée par le biais de l’approche XEB, rendue célèbre par Google lors de son utilisation pour mesurer les performances de Sycamore. Un score XEB proche de 0 indique des résultats « bruyants » présentant un taux élevé d’erreurs, tandis qu’un score proche de 1 indique un taux d’erreur faible.

Les chercheurs ont obtenu un score XEB impressionnant de 0,35, indiquant que le modèle produit des résultats exempts d’erreur dans 35% des cas. Selon l’étude, détaillée sur le serveur de prépublication arXiv, cette performance serait suffisamment élevée pour être impossible à simuler avec les supercalculateurs classiques les plus puissants au monde. Plus précisément, une simulation mathématiquement exacte des calculs de H2-1 est impossible, car elle occuperait toute la mémoire des supercalculateurs les plus puissants.

En comparaison, le score XEB de Sycamore (à 53 qubits supraconducteurs) mesuré en 2019 était de 0,002. La démonstration de Google indiquait que le modèle pouvait exécuter en 200 secondes un calcul complexe qui aurait pris 10 000 ans aux supercalculateurs classiques. Cela suggère une amélioration d’un facteur 100 pour le modèle H2-1.

Par ailleurs, l’architecture de H2-1 offre une connectivité plus flexible permettant de mettre en œuvre des circuits quantiques avec des géométries beaucoup plus complexes que les géométries bidimensionnelles prises en charge par les ordinateurs quantiques à base de supraconducteurs. Selon les chercheurs, « la difficulté considérable de la simulation classique de H2-1 n’est probablement limitée que par le nombre de qubits, démontrant la promesse et l’évolutivité de son architecture à mesure que des progrès continus sont réalisés vers la construction de machines plus grandes ».

30 000 fois moins d’énergie que les supercalculateurs classiques

En outre, une comparaison directe peut être effectuée entre le temps qu’il a fallu au modèle H2-1 pour exécuter l’algorithme RCS et celui qu’il faudrait pour un supercalculateur classique pour exécuter le même algorithme. Cependant, ce dernier peut accélérer le temps d’exécution en étant étendu ou en répartissant la charge de travail avec d’autres supercalculateurs travaillant en parallèle.

Les chercheurs ont alors estimé que la comparaison est plus fiable si l’on considère la quantité d’énergie nécessaire pour effectuer une simulation RCS sur H2-1 ou sur du matériel informatique classique. Les résultats ont montré que H2-1 peut exécuter un algorithme RCS avec 30 000 fois moins d’énergie que les supercalculateurs standards.

« Nous nous concentrons entièrement sur la voie vers des ordinateurs quantiques universels tolérants aux pannes », explique dans un communiqué Ilyas Khan, directeur produits chez Quantinuum. « Ces résultats montrent que même si les avantages des ordinateurs quantiques tolérants aux pannes n’ont pas changé de nature, ils pourraient être réalisables plus tôt que prévu et, surtout, qu’au fil du temps, nos clients bénéficieront d’avantages tangibles dans leurs opérations quotidiennes, car les ordinateurs quantiques commenceront à fonctionner d’une manière qui n’est pas simulable de manière classique », conclut-il.