Des chercheurs ont développé une série d’IA multimodales open source formées avec peu de données, mais qui seraient aussi efficaces que les meilleurs modèles actuels, tels que ceux d’OpenAI. Leur performance résiderait notamment dans la qualité et l’organisation des données, contrairement aux grands modèles formés à partir d’énormes quantités d’informations récupérées sans distinction sur internet. Cela permettrait de réduire les coûts d’entraînement tout en améliorer l’évolutivité, avec en plus le côté open source.

Les IA multimodales se distinguent de celles unimodales par leur capacité à traiter et à interpréter simultanément plusieurs types de données, telles que le texte, les images et l’audio. Les modèles les plus performants du marché, tels que ceux d’OpenAI et de Google, sont dits « propriétaires ». Cela signifie que l’accès à leur code source est limité à l’entreprise, pour des raisons soit de secret commercial, soit de propriété intellectuelle. Le développement est ainsi contrôlé par un seul acteur, principalement dans un but lucratif.

Cette restriction offre cependant plusieurs avantages, dont un support technique professionnel, des mises à jour régulières ainsi que de meilleures performances obtenues à l’aide de ressources financières supérieures. Cependant, cela implique une forte dépendance au fournisseur et un manque de transparence et de liberté de personnalisation du côté des utilisateurs. D’autre part, alors que les entreprises propriétaires de ces modèles ont bénéficié de plusieurs milliards de dollars de financement au cours des dernières années, les investisseurs ont depuis peu exprimé leur scepticisme quant à la rentabilité de ces investissements massifs.

L’Institut Allen pour l’intelligence artificielle (Ai2), un institut de recherche à but non lucratif, suggère que les modèles open source pourraient être plus rentables, notamment en étant nettement moins coûteux à développer. L’équipe d’Ai2 a ainsi, dans cette vision, développé des modèles baptisés « Molmo » privilégiant la qualité des données plutôt que la quantité. « Il est logique qu’en général, la formation sur des données de meilleure qualité puisse réduire les coûts de calcul », explique au MIT Technology Review Percy Liang, directeur du Stanford Center for Research on Foundation Models, qui n’a pas participé au développement. Cette sélection rigoureuse des données aurait également permis d’obtenir une performance équivalente, voire supérieure, à celle des grands modèles propriétaires.

La qualité des données privilégiée à la quantité

L’open source se traduit par un principe de collaboration ouverte. Les codes sources des modèles d’IA de ce type sont donc accessibles sans restriction, permettant à tous de l’inspecter, de le modifier et de le partager librement. Cela favorise à la fois la transparence, l’innovation par une communauté de développeurs de tous horizons et l’indépendance vis-à-vis d’un fournisseur unique. Cependant, ces modèles sont généralement pointés du doigt pour leurs performances souvent inférieures à celles des modèles propriétaires. Ai2 a donc suggéré que la qualité des données à partir desquelles ils sont formés pourrait changer la donne.

Le plus grand modèle Molmo est formé à partir d’un ensemble bien organisé et présélectionné de seulement 600 000 images et inclut 72 milliards de paramètres (7 milliards pour le plus petit modèle). En revanche, les grands modèles propriétaires sont formés à partir de milliards d’images et de textes non triés et récupérés sur internet et incluent plusieurs milliers de milliards de paramètres. Selon Aniruddha Kembhavi, directeur de recherche d’Ai2, cela introduit beaucoup de bruit dans les données d’entraînement et des hallucinations dans les réponses.

Pour former les modèles Molmo, des annotateurs humains ont décrit chaque image de l’ensemble de données d’entraînement avec un niveau de détail dont la longueur peut s’étaler sur plusieurs pages de texte. Plus précisément, les annotateurs ont décrit les images à haute voix plutôt que de saisir des textes descriptifs. Ces descriptions ont ensuite été converties en code, permettant ainsi de réduire le temps de formation tout en réduisant la puissance de calcul requise et ainsi les ressources nécessaires.

Une première version standard de Molmo est disponible ici, et son code sera bientôt disponible pour les développeurs sur le site web de Hugging Face. « Nous publierons prochainement tous nos modèles de pondération, nos données de sous-titrage et de réglage fin, ainsi que notre code source », explique l’équipe dans un article de blog dédié au modèle. Toutefois, certains éléments du modèle le plus puissant sont encore protégés.

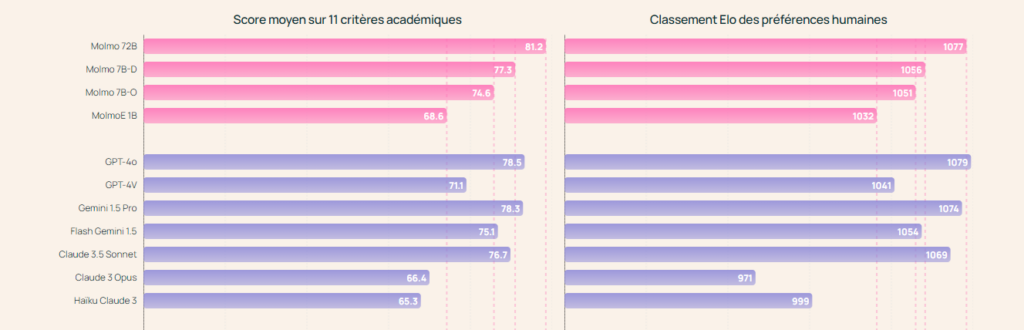

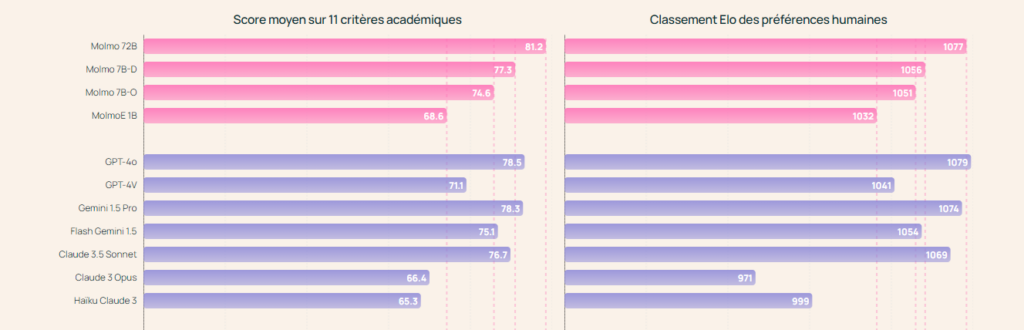

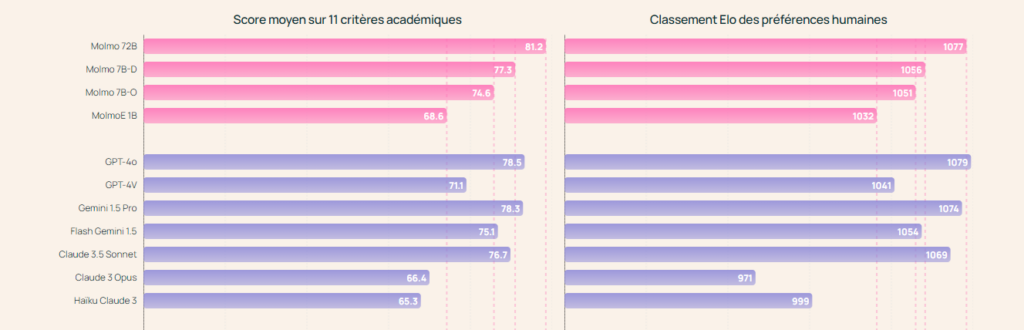

Un modèle surpassant GPT-4o et Gemini 1.5

L’équipe d’Ai2 affirme que le plus grand modèle Molmo (celui comptant 72 milliards de paramètres) surpasse le modèle GPT-4o (d’OpenAI), Claude 3.5 (d’Anthropic) et Gemini 1.5 (de Google) pour le traitement et l’interprétation d’images, de graphiques et de documents. Le plus petit modèle (celui avec 7 milliards de paramètres) quant à lui, s’en approche.

Lors d’une démonstration, les chercheurs ont par exemple demandé aux modèles d’identifier différents éléments (des chaises longues) d’une image prise au hasard depuis la fenêtre d’un bureau. Les éléments ont été identifiés et comptés avec précision. Cependant, ils n’ont pas encore pu identifier des détails plus subtils, tels que des aires de stationnement spécifiques.

Néanmoins, l’entreprise affirme que Molmo est capable de pointer des objets précis sur des images en identifiant les pixels correspondant à la requête de l’utilisateur. Bien que d’autres modèles d’IA avancés puissent également décrire des images, les caractéristiques de Molmo lui permettraient d’interagir avec des interfaces sophistiquées, par exemple pour réserver un vol.

Par ailleurs, les performances de Molmo résideront également sur ce que les développeurs pourront effectuer en matière d’amélioration à partir de cette base solide. « Nous sommes ravis de pouvoir aider les autres et de voir ce que ces derniers construiraient avec cela », indique Farhadi. Toutefois, le côté open source implique également des enjeux en matière de sécurité et de responsabilités, nécessitant ainsi une gouvernance rigoureuse – un aspect sur lequel l’équipe n’a pas encore fourni de détails.