Les chercheurs de Google ont développé Willow, un nouveau processeur quantique permettant de réduire considérablement les erreurs à mesure que le nombre de qubits augmente. Le dispositif permet notamment de répartir un qubit « logique » d’informations à travers plusieurs qubits « physiques » redondants, ce qui lui permet de maintenir un état quantique sur une durée surpassant celle de chaque qubit physique individuel et de réduire les erreurs à un niveau dit « en dessous du seuil ».

Contrairement à leurs homologues classiques, les ordinateurs quantiques sont extrêmement sensibles aux bruits de leur environnement, qui provoquent des erreurs dans les qubits — transportant les informations. Ces derniers sont vulnérables à deux principaux types d’erreurs : l’inversion de bits et le déphasage. Se produisant également pour les bits classiques, le premier se manifeste lorsqu’un qubit passe subitement de 0 à 1 ou inversement. Le second en revanche perturbe l’état quantique des qubits, les faisant ainsi passer à un état classique et provoquant une perte d’informations.

Pour les ordinateurs classiques, la correction d’erreurs est généralement basée sur la redondance d’informations. Par exemple, si Alice veut envoyer le message « 1 » à Bob, elle peut le copier et l’envoyer en trois exemplaires, c’est-à-dire « 111 ». De cette manière, même si une inversion de bit se produit et transmet par exemple une version du message « 101 », Bob pourra toujours supposer qu’Alice a voulu envoyer « 1 », celui-ci étant l’information redondante.

Cependant, les lois de la mécanique quantique empêchent la copie d’informations. Afin de surmonter ce problème, les chercheurs ont développé dans les années 1990 un système de corrections d’erreurs spécialement conçu pour les ordinateurs quantiques et consistant à répartir les informations sous forme de qubits dits « logiques ». « Nous devons répartir l’information de manière à ce qu’il y ait de la redondance, mais pas de copies », explique Daniel Gottesman, théoricien de l’information quantique à l’Université du Maryland, au Scientific American. Un qubit logique est un qubit codé à partir d’un ensemble de qubits physiques, de sorte que l’information peut être préservée même si l’un de ces derniers subit une erreur.

Les chercheurs explorent ce système de correction d’erreurs depuis plusieurs décennies, mais les qubits ne présentaient jusqu’à présent pas la qualité suffisante pour un rendement satisfaisant. Les équipes de Google ont par exemple appliqué le système à la puce Sycamore, mais l’ajout de qubits physiques à chaque qubit logique produisait des rendements décroissants. En d’autres termes, le taux d’erreurs augmentait à mesure que les qubits logiques devenaient plus grands.

Avec le processeur Willow (une version améliorée de Sycamore), les chercheurs de Google sont pour la première fois parvenus à passer en dessous d’un seuil clé où le nombre d’erreurs diminue à mesure que le nombre de qubits augmente. « Il faut démontrer que l’on est en dessous du seuil pour montrer de réels progrès en matière de correction d’erreurs, et cela constitue un défi de taille depuis que la correction d’erreurs quantiques a été introduite par Peter Shor en 1995 », explique dans un article de blog de l’entreprise Hartmut Neven, fondateur et responsable de Google Quantum AI.

Des taux d’erreurs diminuant à mesure que les qubits augmentent

D’après l’étude prépubliée dans la revue Nature, la nouvelle puce Willow possède 105 qubits physiques (contre 72 pour Sycamore), dont la qualité a été améliorée de sorte à conserver leur état quantique cinq fois plus longtemps que précédemment. Afin d’évaluer le taux de correction d’erreurs, les chercheurs ont codé des qubits logiques en augmentant progressivement leur taille. Les premiers étaient composés d’une grille 3×3 qubits physiques, les seconds d’une grille 5×5 et les derniers d’une grille 7×7.

Ils ont ainsi constaté que le taux d’erreurs diminuait considérablement à mesure que la taille des qubits logiques augmentait. « Les qubits de très bonne qualité sont ce qui permet la correction des erreurs quantiques », explique Julian Kelly, directeur de matériel quantique chez Google et co-auteur de la nouvelle étude. Les qubits logiques ont survécu aux erreurs deux fois plus longtemps que n’importe lequel des qubits physiques individuels qui les composaient. Il y aurait eu une seule chance d’erreur sur 1 000 par cycle de calcul.

Des pairs ayant lu l’étude indiquent toutefois que le taux d’erreurs est de 1 sur 100 au lieu de 1 sur 1 000 (avancé par les chercheurs). En réponse à cette remarque, un porte-parole de Google a déclaré que « le nombre exact n’est pas aussi important que l’augmentation des performances avec l’augmentation de la taille. C’est l’élément clé qui rend ce système évolutif ». Et bien que cela soit encore très loin de rivaliser avec les ordinateurs classiques, dont le taux d’erreurs est de 1 sur 1 000 000 000 000 000 000, cela représente néanmoins une avancée notable dans le domaine de l’informatique quantique.

5 minutes pour un calcul au lieu de 1025 années

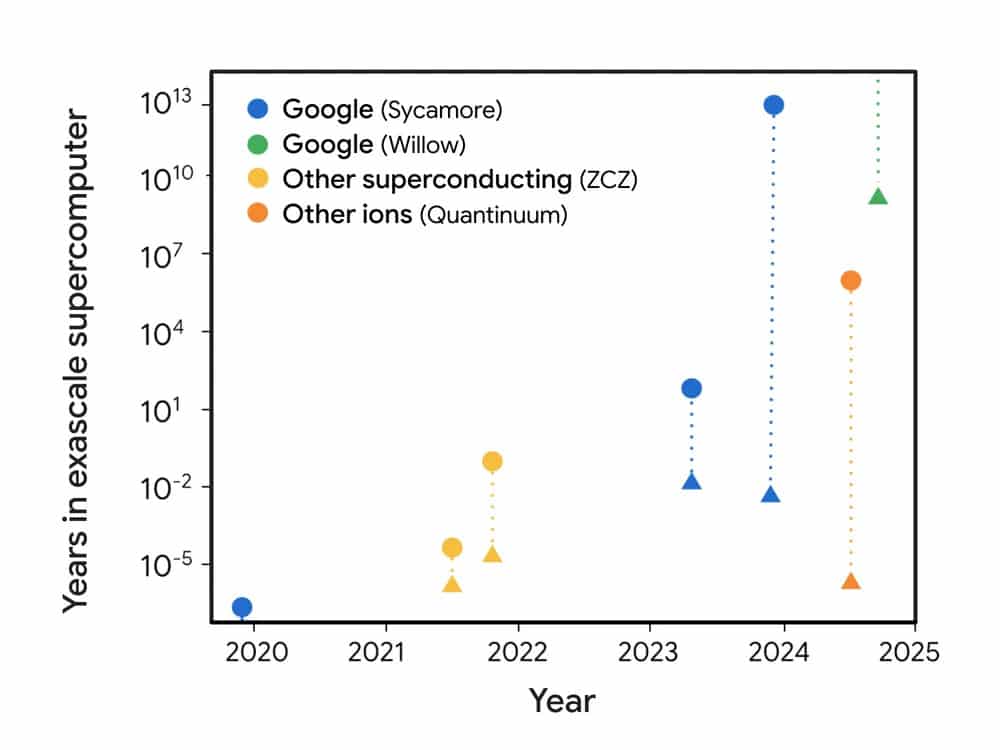

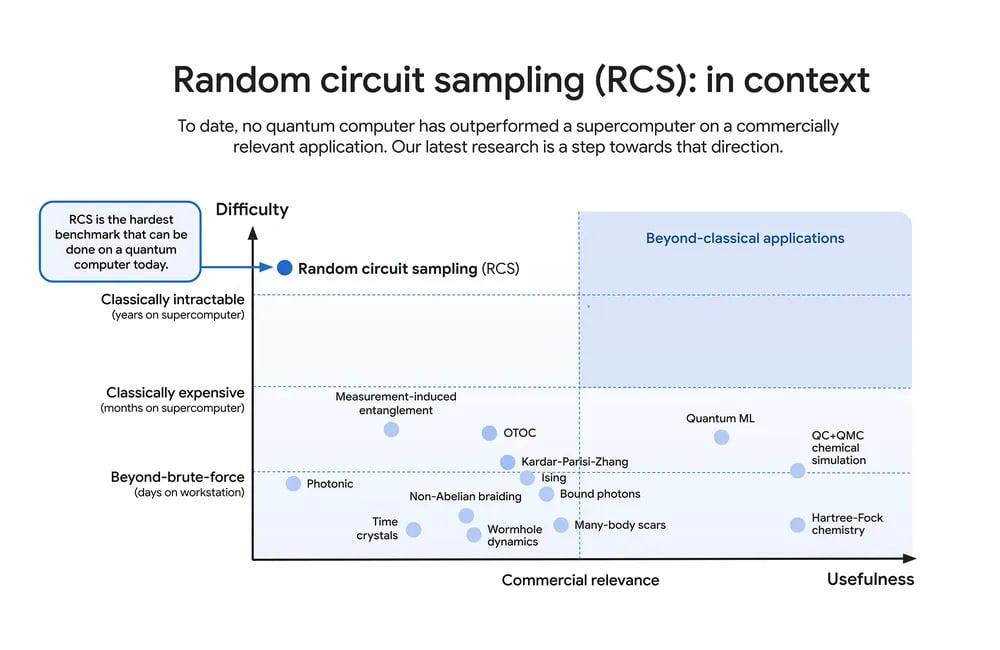

Afin d’évaluer les performances de Willow en matière calcul, l’équipe a utilisé un protocole appelé « random circuit sampling » (RCS), le test le plus élaboré utilisé actuellement pour les ordinateurs quantiques. « Vous pouvez le considérer comme un point d’entrée pour l’informatique quantique : il vérifie si un ordinateur quantique fait quelque chose qui ne pourrait pas être fait sur un ordinateur classique », explique Neven. « Toute équipe qui construit un ordinateur quantique doit d’abord vérifier s’il peut battre les ordinateurs classiques sur le test RCS ; sinon, il y a de fortes raisons d’être sceptique quant à sa capacité à s’attaquer à des tâches quantiques plus complexes », ajoute-t-il.

Résultat : Willow aurait effectué en moins de cinq minutes un calcul qui prendrait 1025 (ou 10 quadrillions) d’années aux plus puissants supercalculateurs actuels. Le prochain défi sera de démontrer une performance de calcul pertinente pour une application concrète, ce qui ne sera possible qu’à long terme malgré les progrès actuels. Pour cela, il faudrait notamment des centaines de qubits logiques et des taux d’erreurs inférieurs à un sur un million.

Vidéo de présentation du nouveau processeur :