Le principe de la loi de Moore a guidé des décennies de progrès informatiques. Cette loi, qui prédisait une croissance exponentielle des performances des puces en doublant le nombre de transistors tous les deux ans et en réduisant les coûts, montre pourtant des signes de ralentissement ces dernières années. Ironiquement, son effondrement survient alors que les coûts de construction des usines de production des semi-conducteurs augmentent, notamment car les puces nécessitent des transistors toujours plus petits. Cependant, Jensen Huang, PDG de Nvidia, a récemment affirmé que les puces IA de l’entreprise progressent à un rythme bien supérieur à celui prévu par la loi de Moore. Une déclaration qui pourrait signaler un grand changement dans les domaines de l’IA et de l’informatique.

En 1965, Gordon Moore, cofondateur d’Intel, a formulé l’hypothèse selon laquelle le nombre de transistors sur une puce informatique doublerait tous les deux ans. Cette avancée se traduirait par des ordinateurs à la fois plus rapides et plus accessibles. Pendant plusieurs décennies, cette prédiction s’est avérée juste, alimentant une croissance fulgurante dans le secteur technologique.

Toutefois, le rythme s’est ralenti ces dernières années, alimentant l’idée que la conception des puces pourrait avoir atteint ses limites avec les technologies classiques. En parallèle, l’industrie des semi-conducteurs est confrontée à des obstacles majeurs, tels que le coût vertigineux de construction des usines spécialisées, qui atteint désormais près de 30 milliards de dollars par site.

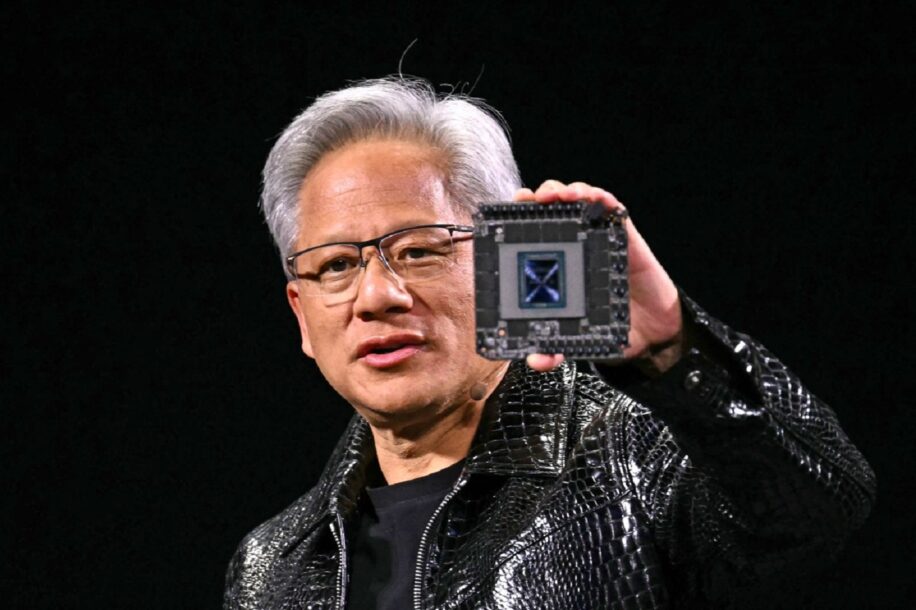

Le discours prononcé par Jensen Huang lors du CES 2025, au début de l’année, contraste avec ce constat. Le PDG de Nvidia a tenu des propos audacieux sur l’avenir de l’IA, affirmant que son entreprise repousse les frontières avec des innovations technologiques majeures. « Nos systèmes progressent bien plus vite que la loi de Moore », a-t-il déclaré dans une interview accordée à TechCrunch, en évoquant la dernière innovation de l’entreprise : la superpuce GB200 NVL72. Selon Huang, cette puce offre une vitesse d’inférence 30 à 40 fois supérieure à celle de son prédécesseur, le H100.

Le PDG attribue ce progrès rapide à une approche intégrée et systémique. Au lieu de se concentrer uniquement sur l’augmentation de la densité des transistors, Nvidia investit dans l’optimisation globale, englobant architecture, bibliothèques logicielles et algorithmes. « Nous pouvons construire l’architecture, la puce, le système, les bibliothèques et les algorithmes en même temps », explique Huang, avant de conclure : « En innovant sur l’ensemble de la pile, nous dépassons la loi de Moore ».

De nouvelles lois pour l’essor de l’intelligence artificielle ?

Dans ses propos, Huang introduit également des « lois » d’échelle visant à redéfinir les principes de croissance de l’IA, en allant au-delà des approches classiques. Ces nouvelles règles s’articulent autour de trois phases fondamentales : la pré-formation, la post-formation et l’inférence.

La première phase, dite de pré-formation, consiste à entraîner les modèles d’IA avec de vastes ensembles de données, afin de les doter de connaissances initiales. La phase de post-formation, quant à elle, vise à affiner les modèles pour les rendre plus efficients et performants. Enfin, l’inférence permet d’optimiser l’obtention de réponses adaptées en temps réel.

« La solution immédiate pour améliorer le calcul en temps réel, tant en termes de performances que de coûts, réside dans l’augmentation de notre capacité de calcul », a souligné Huang. Selon lui, les avancées des puces Nvidia ne se limitent pas à l’optimisation de la puissance et de la rapidité. Elles devraient également fortement réduire les coûts d’inférence, rendant ainsi les technologies d’IA avancées encore plus accessibles.

Nvidia affirme avoir multiplié par 1 000 les performances de ses puces d’IA au cours de la dernière décennie. Une évolution qui surpasse de loin les progrès informatiques traditionnels et positionne ses technologies au cœur des systèmes d’IA développés par des géants comme Google et Anthropic.