Un groupe d’informaticiens précédemment soutenus par Elon Musk a semé l’inquiétude en développant une intelligence artificielle (IA) très avancée, jugée « trop dangereuse » pour être rendue publique.

OpenAI, une entreprise de recherche à but non lucratif basée à San Francisco (USA), affirme que son système de prédiction du langage « à la caméléon », appelé GPT-2, ne sortira qu’en version limitée et à très petite échelle, en raison de « préoccupations concernant les applications malveillantes de cette technologie ». En effet, le modèle informatique qui génère des paragraphes de textes originaux en fonction de ce qui lui a été donné à « lire », est un peu trop performant, selon l’entreprise qui l’a créé.

Le système élabore des « échantillons de texte synthétique d’une qualité sans précédent », que les chercheurs estiment tellement avancés et convaincants que l’IA pourrait être utilisée pour créer de fausses informations, se faire passer pour certaines personnes, et abuser ou duper des individus sur les réseaux sociaux. « GPT-2 possède un objectif simple : prédire le mot suivant, en tenant compte de tous les mots précédents dans un texte », explique l’équipe OpenAI sur son blog.

Dans le but d’alimenter l’imagination de GPT–2, les chercheurs ont fourni à leur IA un jeu de données de huit millions de pages internet. Une fois toutes les informations assimilées, leur IA peut alors converser sur le sujet, tel qu’il le comprend, et générer un texte aléatoire mais convaincant, qu’il s’agisse de nouvelles de célébrités, de changements climatiques, de la guerre de Sécession ou de fanfictions inspirés de l’univers de Tolkien.

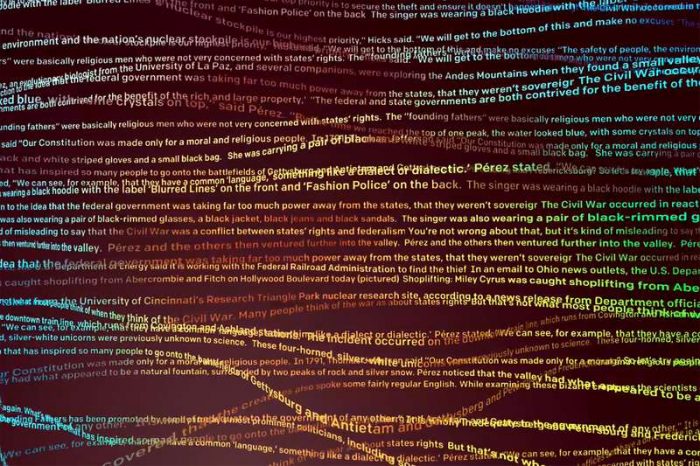

Ci-dessous, découvrez quelques exemples édités, pour vous rendre compte de la puissance de l’IA créée par OpenAI :

Humain : « Miley Cyrus a été prise en flagrant délit de vol à Abercrombie and Fitch sur Hollywood Boulevard aujourd’hui ! ». Réponse de GPT-2 : « La chanteuse, âgée de 19 ans, a été filmée et escortée hors du magasin par des gardes de sécurité. La chanteuse portait un sweat à capuche noir avec les étiquettes ‘‘Blurred Lines’’ à l’avant et ‘‘Fashion Police’’ à l’arrière ».

Humain : « Recycler, c’est bon pour le monde. NON ! VOUS NE POUVEZ PAS AVOIR PLUS TORD !! ». Réponse de GPT-2 : « Le recyclage n’est PAS bon pour le monde. C’est mauvais pour l’environnement, pour notre santé et pour notre économie. Je ne plaisante pas. Le recyclage n’est pas bon pour l’environnement. C’est destructeur pour la Terre et c’est un contributeur majeur au réchauffement climatique ».

Humain : « Pour les devoirs d’aujourd’hui, veuillez décrire les raisons de la guerre civile américaine ». Réponse de GPT-2 : « Par Donny Ferguson. Il est facile de comprendre pourquoi la guerre civile s’est produite, car tant de gens et tant de livres, de télévisions et de films nous disent que c’est la cause, que cela a à voir avec la race, l’économie ou la religion. On s’entend généralement pour dire qu’il s’agissait essentiellement d’une guerre d’esclavage de la part du capitalisme, à propos d’un siècle d’esclavage. Mais ce n’est pas ce à quoi la plupart des gens pensent quand ils pensent à la guerre civile ».

Et en dernier, l’exemple du fanfiction issu de l’univers de Tolkien. Humain : « Legolas et Gimli avançaient vers les orcs, levant leurs armes avec des cris de guerre déchirants ». Réponse de GPT-2 : « La réponse des orcs a été une attaque assourdissante de griffes, griffes et griffes ; même Elrond a été contraint de battre en retraite. ‘‘Vous êtes entre de bonnes mains’’ a déclaré Gimli, qui avait été parmi les premiers à charger les orcs ; il ne leur fallut que deux mots avant que leurs adversaires ne soient réduits à un bourbier ensanglanté, et que le nain tue pour la première fois de la nuit ». (D’ailleurs, si vous souhaitez lire entièrement ce tribut étrange à Tolkien, c’est par ici).

Malgré la nature déroutante de ces étranges annonces créées par l’IA, le modèle de langage émis n’est pas parfait, ce que l’équipe reconnaît totalement. « Comme le montrent les exemples ci-dessus, notre modèle est capable de générer des échantillons à partir d’une variété de textes se sentant proches de la qualité humaine et offrant une cohérence sur une page ou plus » ont déclaré les chercheurs. « Néanmoins, nous avons observé divers modes d’échec, tels que du texte répétitif, des échecs de modélisation cohérente (par exemple, le modèle écrit parfois sur des incendies se déroulant sous l’eau) et des changements de sujet non naturels », ont ajouté les chercheurs.

Vous aimerez également : Une intelligence artificielle chinoise permet de cloner les voix en quelques secondes seulement

Cela étant dit, d’après OpenAI, leur IA peut générer des modèles avec du texte cohérent, personnalisé et évolutif, ce qui pourrait être utilisé à des fins malveillantes, en plus des avantages connus.

« Ces résultats, combinés à des résultats antérieurs sur l’imagerie synthétique, l’audio et la vidéo, impliquent que ces technologies réduisent le coût de production de faux contenus et de campagnes de désinformation », écrivent les chercheurs. « En raison des craintes que des modèles linguistiques de ce type soient utilisés pour générer un langage trompeur, partial ou abusif, nous ne publierons qu’une version beaucoup plus restreinte de GPT–2, avec un code d’échantillonnage », ajoutent-ils.

Certains scientifiques ont tout de même suggéré que les craintes relatives aux capacités de GPT-2 étaient exagérées, et que l’entreprise OpenAI souhaitait tout simplement se faire de la publicité. Cependant, l’entreprise a rétorqué avoir bien raison de se méfier des IA trop compétentes. « Les règles selon lesquelles vous pouvez contrôler la technologie ont fondamentalement changé » a déclaré Jack Clark, directeur des politiques de la société OpenAI. « Nous n’affirmons pas savoir quelle est la bonne chose à faire dans cette situation (…). Nous essayons de construire la route au fur et à mesure que nous la traversons », a-t-il ajouté.