Cet ultime combat s’est déroulé dans le cadre de la finale du défi AlphaDogfight de l’armée américaine, un événement organisé par la Defense Advanced Research Project Agency (DARPA), lors duquel s’affrontent des grandes entreprises du secteur militaire. Cette année, c’est Heron Systems qui s’est distinguée des autres sociétés concurrentes : son avion de combat piloté par une IA a terrassé un pilote de l’US Air Force en cinq rounds.

Cette victoire marque un tournant dans l’histoire des systèmes d’apprentissage automatique : leurs capacités, même dans un contexte aussi critique et dangereux qu’un champ de bataille, semblent avoir dépassé toutes les espérances.

Une compétition pour systèmes de pilotage autonomes

Les AlphaDogfight trials ont été initiés par le département américain de la Défense dans le but d’étendre sa base de développeurs spécialisés en IA et surtout, pour automatiser davantage le combat aérien et renforcer la confiance des pilotes humains envers ces logiciels. Voici une petite présentation de l’événement en vidéo :

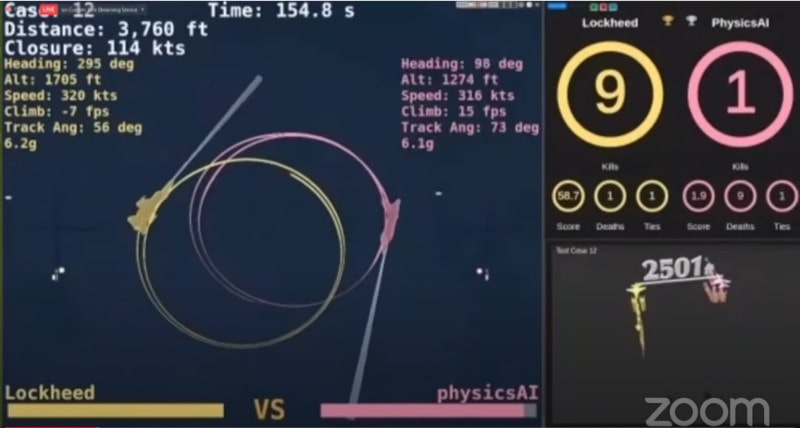

Huit équipes (Aurora Flight Sciences, EpiSys Science, Georgia Tech Research Institute, Heron Systems, Lockheed Martin, Perspecta Labs, PhysicsAI et SoarTech) se sont affrontées entre novembre et janvier. Puis, la pandémie de COVID-19 a malheureusement quelque peu perturbé la suite des événements : le dernier test a eu lieu uniquement en ligne. Ce jeudi 20 août, les spectateurs ont ainsi pu assister à distance à la grande finale de ces combats aériens simulés entre divers algorithmes intelligents aux commandes d’avions F-16.

Heron Systems est sortie victorieuse face à sept autres équipes. L’algorithme développé par cette entreprise a non seulement surpassé les logiciels concurrents, mais il s’est aussi illustré lors d’un combat contre un humain. Ce dernier, équipé d’un casque de réalité virtuelle, a mené le combat depuis un simulateur de vol ; l’IA a été sans pitié et a remporté le combat haut la main, cinq rounds à zéro.

Si l’algorithme conçu par Heron System a montré de telles capacités, c’est grâce à l’apprentissage par renforcement profond via lequel il a été formé. Il s’agit d’une méthode qui consiste à répéter les essais encore et encore, de multiplier les expériences au sein d’un environnement virtuel, jusqu’à ce que le logiciel soit capable de déterminer le comportement optimal à adopter pour atteindre son objectif. Ce renforcement profond est basé sur un réseau neuronal artificiel. L’agent intelligent de Lockheed Martin, qui occupe la deuxième place du podium, a lui aussi été entraîné via la même technique.

Pour les concepteurs du programme, la tâche n’était pourtant pas si simple. Comme l’explique Lee Ritholtz, directeur et architecte en chef de l’IA chez Lockheed Martin, un être humain est doté d’instincts basiques, de survie notamment, dont les intelligences artificielles sont exemptes. Ainsi, il a fallu tout apprendre de zéro, des instructions aussi évidentes que de ne pas s’écraser au sol par exemple.

Les experts soulignent en effet qu’enseigner un comportement de combat aérien est complètement différent de la « simple » tâche de voler, pour laquelle il suffit de maintenir une direction, une altitude et une certaine vitesse. La phase d’apprentissage a donc été particulièrement laborieuse et de très nombreux essais infructueux ont été nécessaires. À l’instar de plusieurs concurrents, Lockheed a bénéficié des conseils et de l’expérience d’un vrai pilote de chasse pour la conception de son algorithme, qui nécessitait des connaissances précises.

Multiplier les essais pour améliorer la prise de décision

Du côté de Lockheed Martin, il a fallu jusqu’à 25 serveurs exécutant des simulations de combats 24 heures sur 24 pour aboutir à une IA vraiment compétente ; au final, leur logiciel peut s’exécuter sur un simple SoC. L’IA de l’équipe gagnante a, quant à elle, subi plus de 4 milliards de simulations, ce qui équivaut à environ 12 ans d’expérience, selon Ben Bell, ingénieur principal en apprentissage automatique chez Heron Systems.

Pour faire d’un tel logiciel un pilote hors pair, il fallait lui enseigner les tâches « basiques » de vol, puis complexifier peu à peu les scénarios. L’objectif étant de faire comprendre à l’algorithme que chaque erreur a un coût, mais que ces coûts ne se valent pas. C’est là que la technique de renforcement entre en jeu : essai après essai, le coût de chaque manipulation est pondéré de manière à ce que le logiciel finisse par apprendre de ses erreurs et prendre les meilleures décisions.

En matière d’armement, les pilotes virtuels devaient se contenter du canon situé dans le nez de l’appareil. L’énorme atout de ces logiciels vis-à-vis de leurs homologues humains est qu’ils sont dotés d’une précision de tir surhumaine, même dans les situations les plus critiques. En outre, ils ne subissent pas les effets des accélérations ou décélérations soudaines. Dans le cadre de la finale, le pilote humain ne subissait pas non plus les forces gravitationnelles dans son simulateur ; mais il n’a pas été la hauteur de l’IA en termes de réactivité et de précision…

À noter que ce n’est pas la première fois qu’une IA surpasse un pilote humain dans le cadre d’un concours. En 2016, un programme baptisé ALPHA a fait l’objet d’un article dans le Journal of Defense Management pour sa capacité à battre un instructeur de vol de combat expérimenté.

Sur le même sujet : Comment la technologie et l’intelligence artificielle remodèlent-elles l’industrie de la traduction, et que peut-on espérer pour l’avenir ?

Développer un système de pilotage autonome performant ouvre évidemment plusieurs opportunités dans le secteur militaire. Pour commencer, cela permettrait de limiter les pertes humaines en cas de conflit. Ensuite, ces systèmes intelligents pourraient servir de coéquipiers aux vrais pilotes, ce qui, au passage, permettrait à l’IA d’apprendre encore plus vite et de devenir toujours plus performante. Ils pourraient également contrôler des escadrilles de drones de reconnaissance par exemple.

La DARPA souligne que l’objectif n’est pas de remplacer complètement les pilotes, mais de les assister en automatisant un maximum de tâches. Prochaine étape ? Réaliser en conditions réelles un combat entre un pilote de chasse et un système autonome. L’Air Force Research Laboratory (AFRL) est déjà sur le coup et prévoit un test grandeur nature au mois de juillet 2021.