Au cours des dernières années, la robotique a connu un essor considérable, notamment grâce aux prouesses technologiques réalisées par la société Boston Dynamics. Cependant, lorsqu’un robot humanoïde doit apprendre par lui-même à marcher, le défi qui se pose aux ingénieurs franchit une étape supérieure. Récemment, une équipe de chercheurs a mis au point un robot bipède qui, sur la base d’une technique d’apprentissage automatique particulière, a pu acquérir les rudiments de la marche de manière autonome.

Une paire de jambes robotiques appelée Cassie a appris à marcher en utilisant l’apprentissage par renforcement, la technique d’entraînement qui enseigne le comportement complexe aux IA par essais et erreurs. Le robot a appris une gamme de mouvements à partir de zéro, y compris marcher accroupi et tout en portant une charge inattendue.

Les attentes quant à ce que les robots peuvent faire sont élevées, notamment en raison des vidéos virales publiées par Boston Dynamics, qui montrent notamment son robot humanoïde Atlas debout sur une jambe, sautant par-dessus des caisses, faisant des sauts périlleux et dansant. Ces vidéos ont accumulé des millions de vues et ont même été parodiées. Le contrôle qu’Atlas a sur ses mouvements est impressionnant, mais les séquences chorégraphiées impliquent probablement beaucoup de réglages manuels. Boston Dynamics n’a pas publié de détails, il est donc difficile de statuer sur la complexité du processus.

« Ces vidéos peuvent amener certaines personnes à croire qu’il s’agit d’un problème résolu et facile. Mais nous avons encore un long chemin à parcourir pour que les robots humanoïdes fonctionnent et vivent de manière fiable dans des environnements humains. Cassie ne peut pas encore danser, mais apprendre au robot humanoïde à marcher tout seul le rapproche, de plusieurs étapes, de pouvoir gérer un large éventail de terrains et se redresser/récupérer lorsqu’il trébuche ou s’endommage », déclare Zhongyu Li, de l’Université de Californie.

Les limitations du monde virtuel

L’apprentissage par renforcement a été utilisé pour entraîner de nombreux robots à marcher dans des simulations, mais il est difficile de transférer cette capacité dans le monde réel. « La plupart des vidéos que vous voyez d’agents virtuels ne sont pas du tout réalistes », déclare Chelsea Finn, chercheuse en IA et robotique à l’Université de Stanford.

De petites différences entre les lois physiques simulées à l’intérieur d’un environnement virtuel et les lois physiques réelles à l’extérieur, telles que la friction entre les pieds d’un robot et le sol, peuvent entraîner d’importants échecs lorsqu’un robot tente d’appliquer ce qu’il a appris. Un robot lourd à deux jambes peut perdre l’équilibre et tomber si ses mouvements sont rien qu’à peine décalés par rapport à la simulation virtuelle.

Une double simulation pour apprendre à marcher

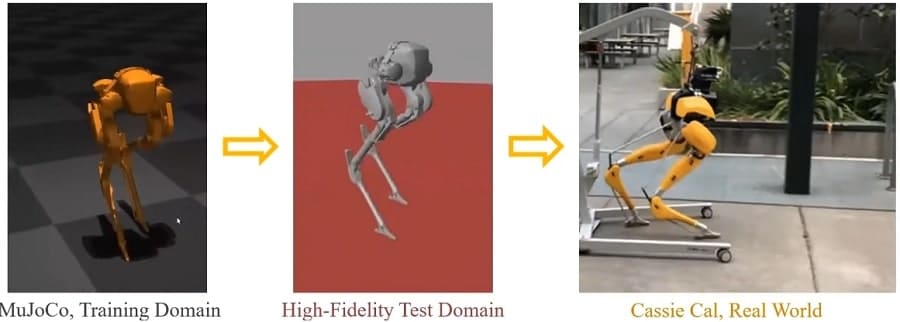

Mais entraîner un robot par essais et erreurs dans le monde réel serait dangereux. Pour contourner ces problèmes, l’équipe de Berkeley a utilisé deux niveaux d’environnement virtuel. Dans la première, une version simulée de Cassie a appris à marcher en s’appuyant sur une grande base de données existante de mouvements de robots.

Cette simulation a ensuite été transférée dans un deuxième environnement virtuel appelé SimMechanics, qui reflète la physique du monde réel avec un haut degré de précision, mais à un coût en vitesse de fonctionnement. Une fois que Cassie semblait bien marcher virtuellement, le modèle de marche appris a été chargé dans le robot réel.

La vraie Cassie a pu marcher en utilisant le modèle appris en simulation sans aucun réglage supplémentaire. Elle pourrait marcher sur un terrain accidenté et glissant, transporter des charges inattendues et se redresser. Lors des tests, Cassie a également endommagé deux moteurs dans sa jambe droite mais a pu ajuster ses mouvements pour compenser. Edward Johns, qui dirige le Robot Learning Lab à l’Imperial College de Londres, considère ceci comme « l’un des exemples de robotique les plus réussis ».

Vidéo présentant Cassie et les travaux des chercheurs :