Au cours des dernières années, l’intelligence artificielle (IA) a connu un essor considérable. Les chercheurs ont développé de nouveaux algorithmes d’apprentissage automatique, tout en perfectionnant des techniques comme celle des réseaux de neurones artificiels. Mais pour beaucoup d’experts, le but ultime à atteindre est une IA qui se créerait elle-même, sans aucune intervention humaine dans son processus d’évolution. Et même si nous en sommes aujourd’hui encore loin, les bases technologiques d’un tel objectif commencent déjà à être posées.

Un chercheur en intelligence artificielle chez Uber, Rui Wang, aime laisser le Paired Open-Ended Trailblazer (POET), un logiciel qu’il a aidé à développer, fonctionner sur son ordinateur portable pendant la nuit. POET est une sorte de dojo d’entraînement pour les robots virtuels. Jusqu’à présent, ils n’apprennent pas grand-chose. Ces agents intelligents ne jouent pas au Go, ne détectent pas les signes de cancer ou ne plient pas les protéines ; ils essaient de naviguer dans un paysage de dessin animé grossier composé de clôtures et de ravins sans tomber.

Mais ce n’est pas ce que les bots apprennent qui est passionnant, c’est la façon dont ils apprennent. POET génère les parcours d’obstacles, évalue les capacités des bots et attribue leur prochain défi, le tout sans intervention humaine. Pas à pas, les bots s’améliorent par essais et erreurs. Cela peut sembler basique pour le moment, mais pour Wang et une poignée d’autres chercheurs, POET fait allusion à une nouvelle façon révolutionnaire de créer des machines super-intelligentes : en faisant en sorte que l’IA se développe elle-même.

Utiliser l’IA pour « créer l’IA » pourrait être une étape importante sur la voie qui mènera un jour à l’intelligence artificielle générale (AGI) des machines pouvant surpasser les humains en tous points. À plus court terme, la technique pourrait également nous aider à découvrir différents types d’intelligence : des intelligences non humaines qui peuvent trouver des solutions de manière inattendue et peut-être compléter notre propre intelligence plutôt que la remplacer.

Apporter de nouvelles solutions

L’une des choses fascinantes à propos de l’IA, et de l’apprentissage automatique en particulier, est sa capacité à trouver des solutions que les humains n’ont pas trouvées, sa capacité à nous surprendre. Un exemple souvent cité est AlphaGo (et son successeur AlphaZero), qui bat les meilleurs joueurs de l’ancien et séduisant jeu de Go en utilisant des stratégies apparemment inconnues. Après des centaines d’années d’études par des maîtres humains, l’IA a trouvé des solutions auxquelles personne n’avait jamais pensé.

Vidéo Live du premier match de Go entre le champion mondial Lee Sedol et l’AlphaGo de Deep Mind :

Jeff Clune travaille avec une équipe d’OpenAI qui a développé des agents qui ont appris à jouer à cache-cache dans un environnement virtuel en 2018. Ces IA ont commencé avec des objectifs simples et des outils simples pour les atteindre : une paire de robots devait trouver l’autre. Pourtant, lorsque ces robots ont été lâchés pour apprendre seuls, ils ont rapidement trouvé des moyens de tirer parti de leur environnement d’une manière que les chercheurs n’avaient pas prévue.

Ils ont exploité des problèmes dans la physique simulée de leur monde virtuel pour sauter par-dessus et même traverser les murs. Ces types de comportements émergents inattendus offrent des indices selon lesquels l’IA pourrait arriver à des solutions techniques auxquelles les humains ne penseraient pas par eux-mêmes, en inventant de nouveaux types d’algorithmes ou de réseaux de neurones plus efficaces — ou même en abandonnant entièrement les réseaux de neurones, une pierre angulaire de l’IA moderne.

Répliquer le processus d’évolution

Si l’intelligence telle que nous la connaissons résulte de la mutation successive de gènes sur d’innombrables générations, pourquoi ne pas chercher à reproduire le processus de production de l’intelligence — qui est sans doute plus simple — plutôt que l’intelligence elle-même ? C’est cette ouverture, entrevue dans la séquence apparemment sans but de défis générés par POET, que Clune et d’autres pensent qu’elle pourrait conduire à de nouveaux types d’IA.

Pendant des décennies, les chercheurs en IA ont essayé de créer des algorithmes pour imiter l’intelligence humaine, mais la véritable avancée pourrait venir de la création d’algorithmes qui tentent d’imiter la résolution de problèmes donnée par le phénomène d’évolution — et d’attendre pour voir ce qui en émerge.

La vérité est que pour l’instant, l’AGI reste un fantasme. Mais c’est en grande partie parce que personne ne sait comment la réaliser. Les progrès de l’IA sont fragmentaires et réalisés par des humains, les progrès impliquant généralement des ajustements aux techniques ou aux algorithmes existants, entraînant des sauts progressifs en termes de performances ou de précision.

Même si l’AGI n’est jamais atteinte, l’approche d’auto-apprentissage peut encore changer les types d’IA créés. Le monde a besoin de plus qu’un très bon joueur de Go, dit Clune. Pour lui, créer une machine super-intelligente signifie construire un système qui invente ses propres défis, les résout, puis en invente de nouveaux. POET est un petit aperçu de cela en action. Clune imagine une machine qui apprendrait à un bot à marcher, puis à jouer à la marelle, puis peut-être à jouer au Go.

Comment créer un cerveau artificiel ?

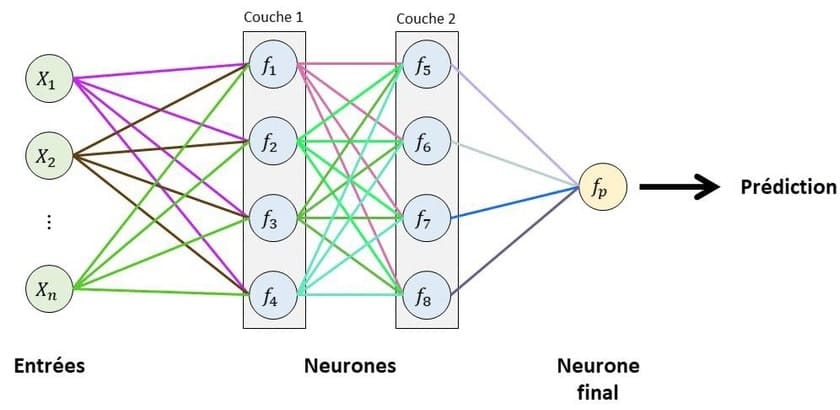

Il existe de nombreuses façons de câbler un cerveau artificiel. Les réseaux de neurones sont constitués de plusieurs couches de neurones artificiels codés dans un logiciel. Chaque neurone peut être connecté à d’autres dans les couches du dessus. La façon dont un réseau neuronal est câblé fait une grande différence, et les nouvelles architectures mènent souvent à de nouvelles percées.

Les réseaux de neurones codés par les scientifiques humains sont souvent le résultat d’essais et d’erreurs. Il existe peu de théorie sur ce qui fonctionne et ce qui ne fonctionne pas, et aucune garantie que les meilleurs designs ont été trouvés. C’est pourquoi l’automatisation de la recherche de meilleures conceptions de réseaux neuronaux est l’un des sujets les plus brûlants de l’IA depuis au moins les années 1980.

Le moyen le plus courant d’automatiser le processus est de laisser une IA générer de nombreuses conceptions de réseau possibles, et de laisser le réseau essayer automatiquement chacune d’elles et choisir les meilleures. Ceci est communément appelé neuro-évolution, ou recherche d’architecture neurale (NAS).

L’année dernière, Esteban Real et son équipe travaillant chez Google ont franchi l’étape supérieure. Leur nouveau système, appelé AutoML Zero, tente de créer une IA à partir de zéro en utilisant uniquement les concepts mathématiques les plus élémentaires qui régissent l’apprentissage automatique. Étonnamment, non seulement AutoML Zero a construit spontanément un réseau de neurones, mais il a également proposé la descente de gradient, la technique mathématique la plus courante utilisée par les concepteurs humains pour former un réseau.

La recherche d’un nouveau type de « professeur »

Les cerveaux des machines n’apprennent pas comme les nôtres. Nos cerveaux sont fantastiques pour s’adapter à de nouveaux environnements et à de nouvelles tâches. Les IA d’aujourd’hui peuvent résoudre des problèmes dans certaines conditions, mais échouent lorsque ces conditions changent, ne serait-ce que légèrement. Cette rigidité entrave la quête de créer une IA plus généralisable qui peut être utile dans un large éventail de scénarios, ce qui serait un grand pas en avant pour les rendre vraiment intelligentes.

Pour Jane Wang, chercheuse chez DeepMind à Londres, le meilleur moyen de rendre l’IA plus flexible est de lui faire apprendre ce trait elle-même. En d’autres termes, elle souhaite construire une IA qui non seulement apprend des tâches spécifiques, mais apprend à apprendre ces tâches de manière à s’adapter à de nouvelles situations.

La première approche, inventée séparément par Wang et ses collègues de DeepMind et par une équipe d’OpenAI à la même époque, utilise des réseaux de neurones récurrents. Ce type de réseau peut être formé de telle sorte que les activations de leurs neurones codent pour tout type d’algorithme. DeepMind et OpenAI en ont profité pour former un réseau neuronal récurrent afin de générer des algorithmes d’apprentissage par renforcement, qui indiquent à une IA comment se comporter pour atteindre des objectifs donnés.

La deuxième approche vient de Chelsea Finn de l’Université de Californie à Berkeley et de ses collègues. Appelé méta-apprentissage indépendant du modèle, ou MAML, il entraîne un modèle à l’aide de deux processus d’apprentissage automatique, l’un imbriqué dans l’autre. Voici comment cela fonctionne : le processus interne de MAML est formé sur des données puis testé ; comme d’habitude. Mais ensuite, le modèle externe prend les performances du modèle interne (par exemple, sa capacité à identifier les images) et les utilise pour apprendre à ajuster l’algorithme d’apprentissage de ce modèle afin d’améliorer les performances.

Pour réussir, il ne faut pas chercher à réussir

Les données générées par l’IA ne sont encore qu’une partie du puzzle. La vision à long terme est de prendre toutes ces techniques et de les confier à un entraîneur d’IA qui contrôle la façon dont les cerveaux artificiels sont câblés, comment ils sont entraînés et sur quoi ils sont entraînés. Même Clune ne sait pas à quoi ressemblerait un tel système futur. Il pourrait s’agir d’une sorte de bac à sable simulé hyper-réaliste, où les IA peuvent s’entraîner sur tout un tas de choses.

POET était motivé par un paradoxe, indique Wang. Si vous essayez de résoudre un problème, vous échouerez ; si vous n’essayez pas de le résoudre, vous avez plus de chances de réussir. C’est l’une des idées que Clune tire de son analogie avec l’évolution — les résultats étonnants qui émergent d’un processus apparemment aléatoire ne peuvent souvent pas être recréés en prenant des mesures délibérées vers la même fin.

POET démarre avec un agent à deux jambes dans un environnement simple, tel qu’un chemin plat sans obstacles. Au début, l’agent ne sait pas quoi faire de ses jambes et ne peut pas marcher. Mais par essais et erreurs, l’algorithme d’apprentissage par renforcement qui le contrôle apprend à se déplacer sur un terrain plat. POET génère alors un nouvel environnement aléatoire qui est différent, mais pas nécessairement plus difficile.

L’agent essaie d’y marcher. S’il y a des obstacles dans ce nouvel environnement, l’agent apprend à les surmonter. Chaque fois qu’un agent réussit ou se bloque, il est déplacé vers un nouvel environnement. Au fil du temps, les agents apprennent une gamme d’actions de marche et de saut qui leur permettent de naviguer sur des parcours d’obstacles de plus en plus difficiles.

POET entraîne ses robots bien différemment des humains : il prend des chemins erratiques et peu intuitifs vers le succès. À chaque étape, les bots essaient de trouver une solution à tout défi auquel ils sont confrontés. En faisant face à une sélection aléatoire d’obstacles placés sur leur chemin, ils s’améliorent globalement. Mais il n’y a pas de point final à ce processus, pas de test ultime à réussir ou de score élevé à battre.