Au cours des dernières années, l’informatique quantique a connu un essor considérable et constitue un domaine très actif de recherche. Bien que les prototypes disponibles actuellement ne soient pas encore réellement pratiques, certaines institutions ont déjà commencé à démontrer le potentiel calculatoire des ordinateurs quantiques. Cependant, les chercheurs sont toujours confrontés à un écueil de taille : la stabilisation des qubits face au bruit de fond. Et pour certains experts, ce problème pourrait être impossible à résoudre.

Cela fait 40 ans que le physicien Richard Feynman a montré que les systèmes quantiques devraient être capables d’effectuer une toute nouvelle forme de calcul qui surpasse même les ordinateurs conventionnels les plus puissants. « Feynman a fait valoir que l’informatique quantique devrait offrir une accélération exponentielle pour de nombreux calculs classiques », explique Cristian Calude de l’Université d’Auckland en Nouvelle-Zélande. Et avec une multitude de récentes avancées, les ordinateurs quantiques semblent maintenant être sur le point d’être accessibles.

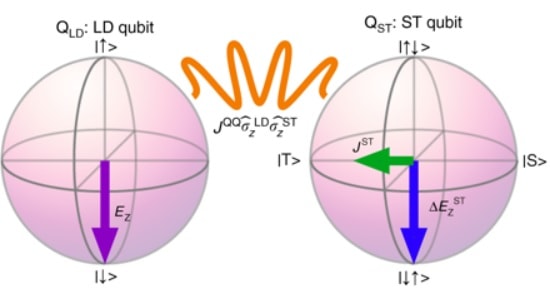

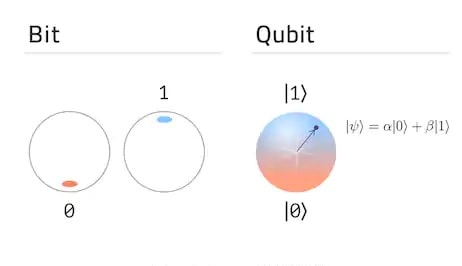

Parce qu’ils ont des propriétés qui n’existent tout simplement pas dans le monde classique, les systèmes quantiques tels que les atomes, les photons, les électrons, etc., ont accès à un ensemble différent de routines pour le traitement de l’information utilisé pour créer des bits quantiques, ou qubits — un ensemble potentiellement beaucoup plus puissant.

La puissance de calcul offerte par les qubits

Une partie de cela est due à la superposition quantique, ce qui signifie qu’un qubit peut être utilisé pour représenter une combinaison complexe des états binaires 0 et 1 utilisés en informatique classique. Les algorithmes quantiques utilisent un processus appelé « interférence » pour fausser ces propriétés indéfinies et biaiser les interactions de plusieurs qubits de manière à augmenter la probabilité qu’ils parviennent à un état final contenant une solution au problème qu’ils tentent de résoudre.

C’est là que l’intrication entre en jeu. Les connexions entre les qubits qu’elle génère permettent en quelque sorte un schéma d’interférence où les chemins menant à chaque mauvaise réponse se détruisent et s’annulent, tandis que les chemins menant à la bonne réponse sont renforcés. En 2019, l’équipe d’informatique quantique de Google a annoncé qu’elle avait atteint la « suprématie quantique » ; c’est-à-dire lorsqu’un processeur quantique réalise des tâches qu’un ordinateur classique ne peut pas faire.

Son processeur Sycamore de 54 qubits n’a pris que 3 minutes et 20 secondes pour résoudre un problème qui mettrait 10 000 ans à être résolu sur l’ordinateur classique le plus puissant au monde, ont déclaré les chercheurs. Ce qui ne veut pas dire que l’ordinateur quantique de Google, ou tout autre qui a atteint la suprématie quantique depuis, est sur le point de faire quoi que ce soit d’utile. Le problème résolu par Google était hautement ésotérique. En mai, Isaac Chuang du Massachusetts Institute of Technology (MIT), l’une des principales autorités mondiales en matière d’informatique quantique, a décrit l’état actuel de la technologie comme un simple système générant de la publicité.

Stabiliser les qubits : un défi extrêmement complexe

Cela nous amène au long voyage qui nous attend vers une machine pratique et utile. La vérité qui dérange est que, en informatique quantique, la taille compte. Les qubits contenant des données doivent conserver leurs états quantiques délicats pendant une longue période et ne pas succomber aux influences environnementales telles que la chaleur et les vibrations qui peuvent les faire décohérer, créant des erreurs de calcul.

Il s’agit d’un problème qui ne peut être surmonté que par la mise à l’échelle. Les estimations actuelles suggèrent que dans les grands ordinateurs quantiques programmables, la plupart des qubits — peut-être jusqu’à 5 sur 6 — effectueront une correction d’erreur, pas un calcul. Cela signifie que nous aurons besoin d’un million de qubits avant de pouvoir faire quoi que ce soit de vraiment utile. Garder autant de qubits suffisamment froids ou maintenir tous leurs états quantiques assez longtemps pour effectuer un calcul est un défi d’ingénierie monumental.

Cela pourrait prendre des décennies, mais les chercheurs font au moins quelques pas dans la bonne direction… IBM vise à construire une machine à 1121 qubits d’ici 2023, et la société a envisagé un réfrigérateur colossal refroidi à l’hélium pour la contenir. D’autres, dont Winfried Hensinger de l’Université du Sussex, au Royaume-Uni, veulent éviter les complications liées au refroidissement : ils intensifient les opérations avec des qubits d’ions piégés qui font la navette autour d’un grand circuit pour effectuer des calculs.

Bruit et qubits : un problème impossible à résoudre ?

D’autres encore effectuent des calculs en envoyant des qubits de photons autour d’une puce de nitrure de silicium qui peut être fabriquée à grande échelle en utilisant des processus déjà éprouvés dans l’industrie des semi-conducteurs. Cependant, Gil Kalai, mathématicien à l’Université hébraïque de Jérusalem en Israël, a soutenu que le niveau de bruit de base dans un ordinateur quantique sera toujours trop élevé, quel que soit le nombre de qubits disponibles. « Mon analyse affirme que la correction des erreurs de qualité ne sera pas possible ».

Sabrina Maniscalco de l’Université d’Helsinki en Finlande, est également sceptique. « Trouver un remède à l’effet du bruit induit par l’environnement n’est pas seulement, à mon avis, un problème technologique, mais plus conceptuel et fondamental. Je dirais que je suis optimiste, plutôt que confiante ».