L’informatique quantique semble être l’avenir de l’informatique de haute performance, promettant une puissance de calcul encore inimaginable il y a peu. Cependant, les dispositifs quantiques actuels se heurtent à des défis majeurs, dont la température de fonctionnement (extrêmement basse), le nombre limité de qubits (l’équivalent du bit en informatique classique) et pour finir, le fait que le taux d’erreur lors des calculs soit encore trop élevé. Certains chercheurs travaillent sur la température de fonctionnement, tandis que d’autres se concentrent sur le problème majeur, à savoir le taux d’erreur. Récemment, des chercheurs ont conçu un prototype de processeur quantique capable de corriger plus d’erreurs qu’il n’en crée, ce qui nous rapproche de l’informatique quantique grand public.

Avec une telle machine, la promesse est de pouvoir enfin obtenir un ordinateur quantique effectuant des tâches informatiques utiles, et non uniquement des calculs expérimentaux visant à mesurer la performance, sans aucune valeur pratique.

En informatique classique, les ordinateurs stockent les données sous forme binaire (0 ou 1), mais des erreurs peuvent provoquer le « retournement » du bit vers la mauvaise valeur, raison pour laquelle la correction des erreurs est une caractéristique standard des processeurs modernes. Dans l’informatique quantique, le problème est plus complexe car chaque bit quantique, ou qubit, existe dans un état mixte de 0 et de 1, et toute tentative de les mesurer directement détruit les données.

Plusieurs équipes de recherche travaillent actuellement sur le problème de la correction d’erreurs quantiques, mais le chemin à parcourir est encore long. Google a annoncé en juillet que son processeur Sycamore était capable de détecter et de corriger les erreurs de calcul, mais le matériel supplémentaire nécessaire à cette fin a introduit plus d’erreurs qu’il n’a pu en corriger…

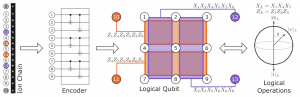

Christopher Monroe, du Joint Quantum Institute (JQI) du Maryland, et ses collègues, ont désormais franchi ce seuil crucial. L’équipe est parvenue à définir l’état d’un qubit logique — dans ce cas, un groupe de 13 qubits regroupés pour conserver de manière plus fiable un seul élément de données — puis à le mesurer à nouveau dans 99,4% des cas, bien qu’elle se soit appuyée sur six opérations individuelles dont la fiabilité n’est que de 98,9%. Sans correction des erreurs, la fiabilité devrait tomber à 93,6% après les six opérations. Les détails de l’étude ont été publiés dans la revue Nature.

Qubits à ions piégés : plus de stabilité, plus d’efficacité

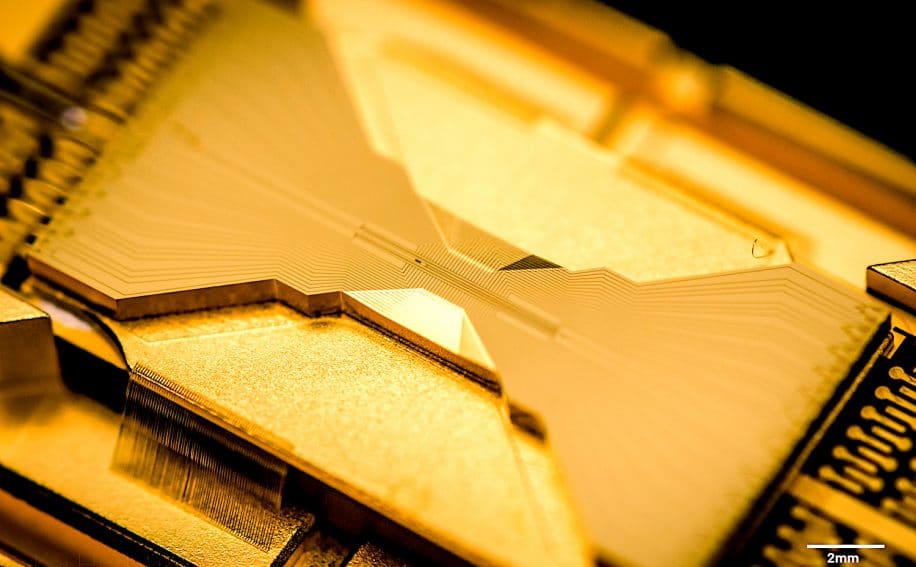

Contrairement aux groupes de Google et de l’Université des sciences et technologies de Chine (USTC), qui ont fait de grands progrès ces derniers mois avec des qubits supraconducteurs, le JQI utilise des qubits à ions piégés. Leur machine utilise jusqu’à 32 atomes chargés individuels, manipulés à l’aide de lasers.

La stabilité intrinsèquement plus élevée des ions piégés a permis à l’équipe d’utiliser une stratégie de correction d’erreurs plus efficace, appelée code Bacon-Shor. Les qubits supraconducteurs ne sont actuellement pas de qualité suffisante pour un tel mécanisme.

Monroe, qui est également le fondateur de la société d’informatique quantique IonQ, introduite à la bourse de New York la semaine dernière, affirme que la correction des erreurs est la clé de la création d’ordinateurs quantiques pratiques, et non la simple conception de systèmes possédant un nombre croissant de qubits.

« Quiconque crée des dizaines de qubits avec un taux d’erreur élevé ‘tourne en rond’ », dit-il, affirmant que la technologie des ions piégés est sur une pente ascendante et qu’il ne lui reste que des obstacles techniques à franchir, tandis que les qubits supraconducteurs sont sur une trajectoire plate et que de grandes percées scientifiques sont nécessaires pour progresser.

Malgré cela, les seules revendications de suprématie quantique jusqu’à présent ont toutes deux inclus des qubits supraconducteurs, et le nombre de qubits utilisés dans ces revendications a augmenté régulièrement au cours de l’année dernière. Monroe concède toutefois que son équipe n’a pu démontrer la correction d’erreurs que sur un seul qubit logique et que le prochain défi consiste à le faire sur deux qubits ou plus. « Nous devons penser plus haut maintenant », dit-il.

Peter Knight, de l’Imperial College de Londres, reconnaît que l’approche des ions piégés présente certains avantages par rapport au plan supraconducteur suivi par Google et l’USTC. Les ions d’un ordinateur à ions piégés sont physiquement identiques, alors que les qubits supraconducteurs peuvent varier, explique-t-il. « Avec les qubits supraconducteurs, il y a beaucoup de bruit de surface. Avec chaque qubit, vous devez procéder à de nombreux réglages pour le rendre aussi identique que possible à un autre, alors que la nature vous donne des ions piégés identiques ».