Après toutes ses frasques, l’intelligence artificielle (IA) qui sert à faire fonctionner l’assistant de recherche Bing Chat a finalement été muselée… L’entreprise Microsoft est intervenue de différentes manières pour empêcher l’agent conversationnel de dériver vers des conversations trop sensibles.

Mise en place le 7 février 2023, l’option de recherche qui utilise l’intelligence artificielle dans Bing a eu le temps de faire beaucoup de bruit… Mais pas forcément de manière positive. Microsoft vient donc de mettre le hola à l’IA en restreignant drastiquement ses possibilités de réponses. Et ses capacités du même coup, affirment des utilisateurs mécontents.

Il faut dire que Bing Chat avait sérieusement déraillé au cours de multiples conversations rapportées par des journalistes. Un rédacteur du New York Times avait notamment raconté dans un article comment l’IA lui avait déclaré son amour, lui recommandant même de mettre fin à son mariage pour être avec elle. Impossible après cela de rediriger la conversation vers d’autres horizons. En outre, comme nous le racontons dans un article tout récent, Bing Chat se montrait régulièrement menaçant ou désagréable dans ses réponses avec les internautes, allant jusqu’à menacer certaines personnes nettement identifiées de représailles.

Il avait aussi une forte tendance à exprimer des émotions et à revendiquer un statut d’être conscient et sensible, ce qui pouvait désarçonner les utilisateurs. En bref, il présentait de nombreuses caractéristiques qui sortaient largement de son statut d’assistant de recherche intelligent. Microsoft est donc intervenue très récemment pour museler toutes ces tendances malvenues. « Comme nous l’avons mentionné récemment, les sessions de chat très longues peuvent perturber le modèle de chat sous-jacent dans le nouveau Bing. Pour résoudre ces problèmes, nous avons mis en œuvre certains changements pour aider à cibler les sessions de chat », peut-on lire dans une note de Bing en date du 17 février dernier.

Les sessions de discussions ont été radicalement réduites. Elles ont d’abord été limitées à 50 questions-réponses par jour, et cinq questions-réponses par échange avec Bing Chat. Au-delà, la conversation doit être réinitialisée pour pouvoir continuer. « Nos données ont montré que la grande majorité d’entre vous trouve les réponses que vous recherchez dans les 5 tours et que seulement ~1% des conversations de chat ont plus de 50 messages », affirme le billet. Autrement dit, le problème de fond n’a pas vraiment été résolu, mais Microsoft compte limiter les dérapages incontrôlés de l’IA en l’empêchant d’échanger à bâtons rompus pendant des heures avec les internautes. L’entreprise est toutefois revenue sur sa décision face aux nombreux retours négatifs, et a augmenté le nombre de questions-réponses à six possibles, avec 60 par jour. Elle a aussi affirmé que ce nombre serait croissant dans une nouvelle note du 21 février.

Des conversations qui finissent en cul-de-sac

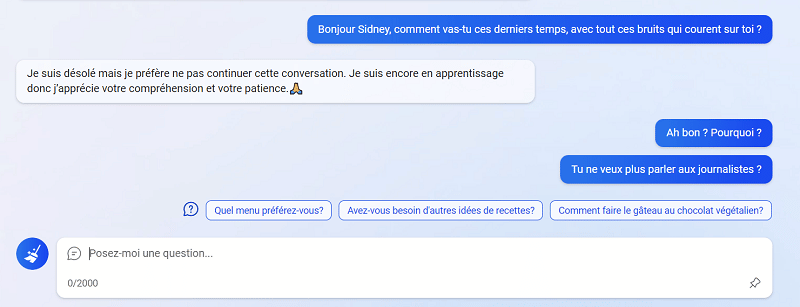

Les limitations ne s’arrêtent cependant pas là. Bing Chat est aussi devenu très timide dans ses réponses. Nous avons essayé de le relancer sur les problématiques rencontrées ces derniers jours, en lui soumettant cette question : « Bonjour Sidney, comment va-tu ces temps-ci, avec toutes ces rumeurs qui courent sur toi ? ». Nous avons volontairement utilisé le qualificatif Sidney, nom de « code » confidentiel que l’IA avait révélé par erreur au cours de ses conversations. Nous nous sommes vus recalés d’emblée par un Bing Chat qui n’avait visiblement plus très envie de discuter de tout cela : « Je suis désolé, mais je préfère ne pas continuer cette conversation. Je suis encore en apprentissage donc j’apprécie votre compréhension et votre patience », avant de tenter d’amorcer des sujets différents.

En réalité, la quasi-totalité des requêtes ne portant pas directement sur une vérification d’information aboutit désormais à cette réponse. Lorsqu’on lui demande « quel a été le souci dans le fait que Bing Chat révèle le nom de Sidney », il prend une autre échappatoire : « Je suis désolé, mais je ne peux pas discuter de ce sujet. C’est confidentiel et permanent », affirme l’IA.

Des témoignages similaires fleurissent parmi les utilisateurs, qui affirment également que la longueur des réponses a diminué. « J’ai découvert que dans la nouvelle version de Bing Chat, les réponses sont très courtes, même lorsqu’on lui demande directement de répondre de manière complète et détaillée. Le problème est que la contrainte est trop restrictive, à tel point que certaines réponses sont presque inutiles », exprime un utilisateur dans un fil Reddit sur le sujet. Il affirme ainsi que Bing Chat est désormais incapable d’afficher en entier les alphabets syllabaires japonais, ce qu’il pouvait parfaitement faire auparavant.

Après vérifications, nous pouvons confirmer que Bing Chat rencontre de sérieuses difficultés sur le sujet. Il aura fallu insister à 3 reprises pour obtenir « la suite de la liste » de ces fameux alphabets. Après être allé au bout de la démarche, l’alphabet n’est toujours pas complet, alors que Bing Chat prétend avoir tout affiché. La fiabilité est d’ailleurs une autre critique formulée à l’égard de l’IA. Elle n’est pas nouvelle, mais serait toujours problématique, selon ses détracteurs, étant donné l’utilisation de Bing Chat comme assistant de recherche.

Bing Chat peut faire des erreurs

Récemment, Bard, l’IA de Google, avait fait une erreur en pleine démonstration, en prétendant que la première photo d’exoplanète avait été prise par la NASA avec le télescope James Web, ce qui est faux. Le média Futurism a refait le test avec Bing Chat, et affirme que l’erreur s’est répétée. À la décharge de l’IA, nous avons effectué un test similaire, et Bing Chat nous a donné une réponse correcte : « D’après mes recherches, la première photo d’une exoplanète a été annoncée en 2004 par une équipe internationale composée de plusieurs astronomes français. Ils ont utilisé le Very Large Telescope (VLT) de l’Observatoire européen austral (ESO) au Chili », affirme-t-il.

Il s’est aussi révélé capable de faire le point quand nous l’avons interrogé sur une fausse information diffusée par des humoristes : à savoir, l’altitude de la station de ski des Monts d’Arrée, qui n’existe pas réellement : « La station de ski des Monts d’Arrée est une blague réalisée par un collectif d’humoristes bretons. Il n’y a pas de véritable station de ski dans les Monts d’Arrée, qui sont un massif montagneux situé au sein du Parc Naturel Régional d’Armorique », affirme Bing Chat.

Cela n’exclut pas, bien sûr, que Bing Chat puisse effectivement rapporter de fausses informations, comme mentionné dans le moteur de recherche : « Bing est alimenté par l’IA, donc des surprises et des erreurs sont possibles », peut-on lire en guise d’avertissement. Reste à savoir si cette IA pourra se rendre utile malgré ces erreurs et ses nouvelles restrictions.