La technologie mentionnée, connue sous le nom d’IA conversationnelle ou parfois simplement « Chatbot », n’est qu’une des récentes percées de l’intelligence artificielle — permettant aux machines d’apprendre par elles-mêmes des compétences diverses et variées. Suite au succès de ChatGPT d’OpenAI, Google a lancé son propre agent conversationnel doté d’IA, Bard. Dans une interview récente, le PDG explique que ce dernier a montré ce qu’ils appellent des « propriétés émergentes » en apprenant par lui-même le bengali, sans que les experts ne puissent expliquer comment. Fake news ou non, cette annonce soulève de nombreuses questions concernant la sécurité liée aux IA et leurs conséquences sur la société.

Bard est un chatbot conversationnel expérimental basé sur l’intelligence artificielle, propulsé par LaMDA, ou « modèle de langage pour les applications de dialogue » de Google. En plus de LaMDA, Bard s’appuie sur toutes les informations du web pour peaufiner ses réponses.

Concrètement, il effectue des tâches textuelles telles que fournir des réponses et des résumés, et permet donc de créer diverses formes de contenu. Il aide également à explorer des sujets en résumant les informations trouvées sur Internet et en fournissant des liens pour explorer des sites Web avec plus d’informations.

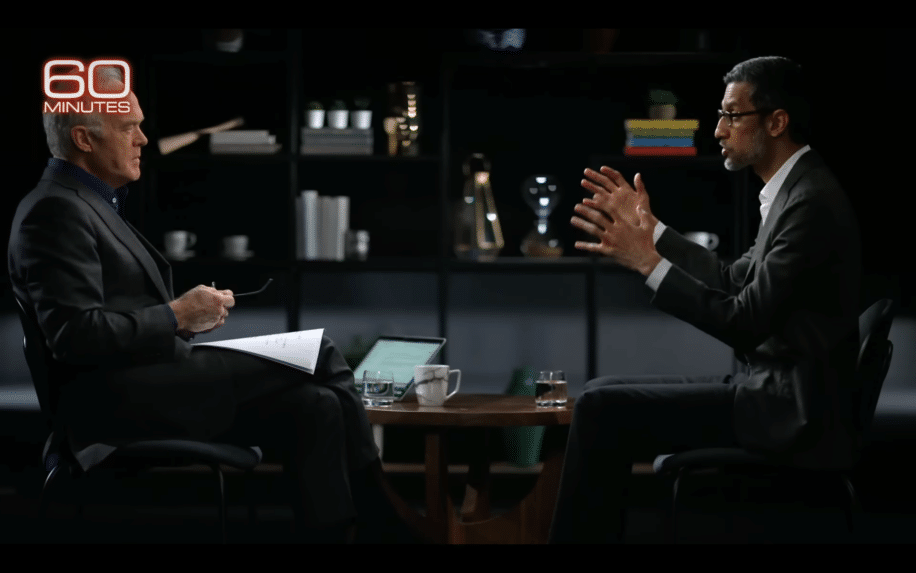

Récemment, dans une interview avec CBS’ 60 Minutes, le responsable technique de Google, James Manyika, a admis que l’IA de l’entreprise avait en quelque sorte appris une langue sur laquelle elle n’avait pas été formée. Il déclare : « Nous avons découvert qu’avec très peu d’incitations en bengali, il peut désormais traduire tout le bengali ». Une déclaration choquante et douteuse pour certains chercheurs.

Puis c’est au tour du PDG actuel de Google, Sundar Pichai, de souligner que ce type de comportement est encore inexpliqué par leurs experts, et que l’IA aura certainement de grandes conséquences, négatives, sur les emplois dans un futur proche. Il demande également une réglementation de ces nouvelles technologies, que très peu de gens semblent réellement maîtriser.

Une boîte noire insondable, une réglementation nécessaire

Apprendre une nouvelle langue sans que l’intelligence artificielle y soit formée relève des propriétés émergentes, concept popularisé en 1972, par le physicien lauréat du prix Nobel Philip Anderson. Ce dernier avait discuté l’idée que des changements quantitatifs dans un système (ici le nombre de données sur lesquelles repose l’IA) entraînent des changements qualitatifs dans le comportement (l’IA a appris une nouvelle langue).

Comme le note CBS, ces types de « propriétés émergentes » sont « mystérieuses » et continuent de déconcerter les développeurs alors même qu’elles deviennent de plus en plus courantes. D’ailleurs, Pichai déclare : « Il y a un aspect de cela que nous appelons une ‘boîte noire’. Vous savez, vous ne comprenez pas tout à fait. Et vous ne pouvez pas tout à fait dire pourquoi il a dit cela, ou pourquoi il s’est trompé ».

One AI program spoke in a foreign language it was never trained to know. This mysterious behavior, called emergent properties, has been happening – where AI unexpectedly teaches itself a new skill. https://t.co/v9enOVgpXT pic.twitter.com/BwqYchQBuk

— 60 Minutes (@60Minutes) April 16, 2023

Puis il a admis que la société devra se préparer aux progrès rapides de l’intelligence artificielle, qui sont sur le point de perturber le marché du travail et d’exacerber les problèmes de sécurité. La réponse a d’ailleurs incité le présentateur Scott Pelley à demander comment Google pouvait « lâcher prise sur le sujet » sans une compréhension totale de la technologie. Pichai a ironisé : « Laissez-moi le formuler ainsi : je ne pense pas non plus que nous comprenions parfaitement comment fonctionne un esprit humain ».

Néanmoins, il a appelé à de nouvelles réglementations pour l’IA — alors même qu’Elon Musk et d’autres appellent à une pause pure et simple sur le développement de systèmes d’IA avancés en raison de problèmes de sécurité. D’ailleurs, lorsque Pelley lui a demandé si des cadres mondiaux de type armes nucléaires pourraient être nécessaires, Pichai a acquiescé en ajoutant : « Nous aurions besoin de cela ».

En ces temps de fake news…

Certains experts estiment néanmoins que la séquence de CBS comprenait des affirmations douteuses sur l’un des grands modèles linguistiques de l’entreprise. L’ancienne chercheuse de Google Margaret Mitchell a expliqué sur Twitter, preuves à l’appui, que la déclaration est incorrecte. Elle a souligné que LaMDA de Google avait été formé pour comprendre le bengali. En parcourant la fiche technique de PaLM, on constate que le bengali est l’une des langues sur lesquelles il est formé.

Okay, @60Minutes is saying that Google's Bard model "spoke in a foreign language it was never trained to know." I looked into what this can mean, and it appears to be a lie. Here's the evidence, curious what others found. 🧵 https://t.co/u3WtvbOtAM

— MMitchell (@mmitchell_ai) April 17, 2023

Mitchell suggère que le PDG de Google n’était probablement pas au courant de ce sur quoi Bard a déjà été formé et que s’appuyer sur la « magie » de l’IA leur profite sur le plan marketing. Outre ce fait douteux, d’autres séquences se révèlent choquantes. Pichai a déclaré que l’intelligence artificielle avancée devait principalement entraîner des pertes d’emplois parmi les soi-disant « travailleurs du savoir », comme il les appelle, tels que les écrivains, les comptables, les architectes et les ingénieurs en logiciel.

Ces déclarations ne font donc qu’ajouter au battage médiatique de l’IA depuis le lancement de ChatGPT. À maintes reprises, des experts et des chercheurs ont souligné à quel point cela pourrait s’avérer préjudiciable au développement de la technologie, comme le souligne The Daily Beast. Cela a conduit à des attentes irréalistes quant à ce que l’IA est capable de réaliser à court terme, mais aussi à une prolifération de fake news.

Donner autorité aux réponses des IA sans garde-fou est dangereux. Cela peut causer d’immenses dommages si elles produisent des résultats biaisés ou totalement inventés. Le risque de diffuser de la désinformation à des utilisateurs peu méfiants est élevé.

Une étude récente publiée dans Scientific Reports a révélé que les réponses humaines aux questions morales peuvent être facilement influencées par les arguments avancés par ChatGPT — et les utilisateurs ont même largement sous-estimé à quel point ils étaient influencés par ces IA. La société est loin d’être préparée à la fulgurance du développement de ces technologies. La prudence et la réglementation stricte ne font pas de doute, mais encore faut-il qu’elles soient effectives.