L’évolution des performances des GPU façonne l’avenir du secteur de l’intelligence artificielle. Actuellement, Nvidia se positionne en leader incontesté du secteur des puces dédiées à l’IA, fournissant près de 90% des GPU spécifiquement adaptés aux applications d’IA. Renforçant sa domination, la société a récemment levé le voile sur sa nouvelle « super puce », la GH200, dont le lancement est attendu pour le deuxième trimestre de l’année à venir. Selon la firme, elle devrait réduire drastiquement les coûts d’exploitation des LLM (grands modèles de langage), tels que GPT ou Bard.

Lorsqu’on évoque le nom de Nvidia, la première chose qui vient à l’esprit est souvent leurs GPU. Ces derniers sont initialement conçus pour accélérer le traitement visuel (vidéo et image). Mais les GPU ont rapidement démontré leur polyvalence, se révélant particulièrement performants pour une gamme variée de calculs, y compris ceux au cœur de l’IA et de la cryptographie.

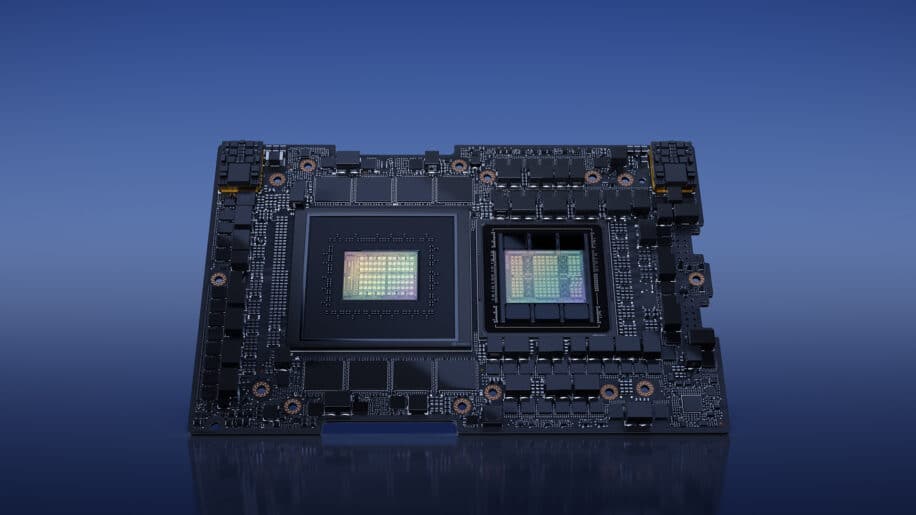

Avec l’essor des modèles d’IA de grande envergure, dont les grands modèles de langage (LLM), la demande en puissance de calcul a explosé. Les GPU, dotés de multiples cœurs, sont capables de gérer simultanément d’innombrables calculs. Ce n’est donc pas un hasard si des références de l’IA telles que Bard de Google et ChatGPT d’OpenAI reposent maintenant sur ces technologies. Face à cette demande croissante, Nvidia, toujours à la pointe de l’innovation, vient d’annoncer l’arrivée de sa dernière merveille technologique : la puce GH200 Grace Hopper.

Un pas de géant dans la technologie de mémoire

Cette nouvelle plateforme Nvidia est la première au monde à intégrer le processeur HBM3e. HBM (High Bandwidth Memory) est une technologie de mémoire qui s’est déjà distinguée par sa capacité à offrir une bande passante exceptionnelle tout en optimisant la consommation énergétique. Avec la version HBM3e, Nvidia franchit un nouveau cap.

Dotée d’une capacité impressionnante de 282 Go, la puce mémoire HBM3e se démarque en étant 50% plus rapide que son prédécesseur, la HBM3. Cette augmentation significative de la vitesse se traduit par une performance accrue, capable de délivrer une bande passante combinée de 10 To/sec. Cela signifie que la puce GH200 peut gérer des modèles d’intelligence artificielle qui surpassent de 3,5 fois en volume ce que permettait la technologie HBM3. Cette mémoire offre également à la puce la capacité de gérer des modèles d’IA ultra-complexes.

En outre, cette mémoire élargie signifie qu’un modèle d’IA de grande envergure peut être exécuté sur un unique GPU. En effet, pour atteindre une telle performance, les plateformes doivent généralement s’appuyer sur plusieurs GPU, engendrant des coûts supplémentaires et une complexité accrue.

Une super puce conçue pour l’inférence

Le travail avec l’IA inclut un processus composé de deux étapes : la formation et l’inférence. La première, la formation, est celle où le modèle d’IA est nourri et « entraîné » à partir d’énormes ensembles de données. C’est au cours de cette phase que le modèle apprend et affine ses capacités.

Une fois cette formation achevée, le modèle entre dans la phase d’inférence. C’est ici qu’il est mis à l’épreuve, générant des prédictions, du texte, des images ou d’autres formes de contenu en fonction de ce qu’il a appris. Chaque exécution d’un logiciel basé sur l’IA, chaque prédiction ou génération, nécessite une grande puissance de calcul pour l’inférence. Et c’est précisément là que la GH200 excelle.

Lors de sa présentation, Nvidia a mis l’accent sur le fait que sa nouvelle super puce GH200 a été optimisée pour le calcul d’inférence. Alors que cette opération est souvent très coûteuse, Nvidia affirme que la GH200 réduira considérablement la dépense énergétique lors de son utilisation pour les grands modèles. En d’autres termes, avec la GH200, l’inférence devient non seulement plus rapide, mais aussi plus économique.