La consommation énergétique journalière de certains modèles d’IA se mesurerait actuellement en mégawattheures. Dans un avenir proche, il est même prévu que les chiffres augmentent au point de correspondre à la consommation nationale de certains pays. C’est ce que révèle une nouvelle étude axée sur l’empreinte énergétique de ces nouvelles technologies.

Dans l’industrie technologique, les centres de données ont toujours été pointés du doigt en raison de leur consommation énergétique élevée. Face à cette réalité, des solutions ont vu le jour afin d’optimiser leur efficacité énergétique, comme notamment l’adoption de solutions de refroidissement naturel ou la valorisation de la chaleur résiduelle des serveurs. Mais qu’en est-il de l’intelligence artificielle, cette technologie qui a marqué le monde ces dernières années ?

Alex de Vries — doctorant et fondateur d’une entreprise de recherche axée sur les implications des tendances numériques — a exploré cette question. Son étude, publiée dans la revue Joule, révèle des données alarmantes. Les systèmes d’IA, notamment les grands modèles de langage (LLM), consomment une quantité d’énergie colossale. Si cette tendance se poursuit, leur consommation pourrait, dans un futur proche, rivaliser avec celle d’une nation entière.

Jusqu’à 564 MWh d’électricité par jour pour ChatGPT…

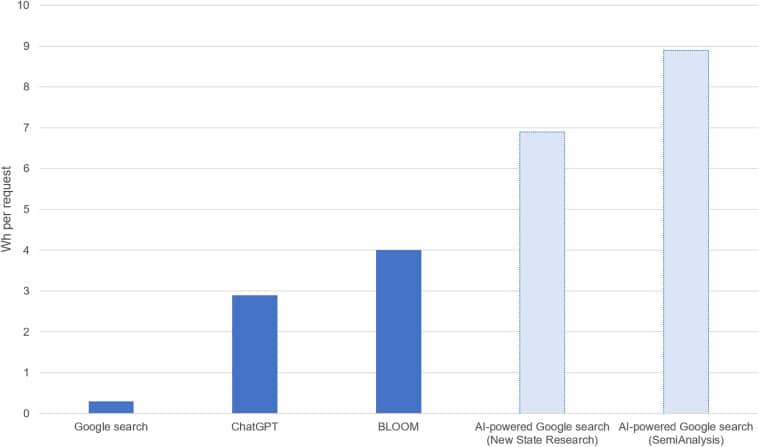

Tout comme une simple recherche sur un moteur de recherche consomme de l’énergie, les interactions avec les IA génératives ont également un coût énergétique. La différence, c’est que ces dernières seraient jusqu’à 10 fois plus énergivores, selon l’étude. Pour le cas de GPT, le modèle de langage utilisé par le chatbot d’OpenAI, une seule requête nécessiterait 2,9 Wh d’énergie. En se basant sur le nombre de requêtes effectuées quotidiennement en début d’année, l’étude estime que ChatGPT pourrait consommer jusqu’à 564 MWh par jour. Pour contextualiser, cette quantité d’énergie correspond à la consommation annuelle moyenne de 52 foyers américains.

Outre l’interaction avec les utilisateurs, les LLM sont particulièrement énergivores lors de leur phase d’entraînement. Durant cette étape cruciale, ces modèles effectuent une multitude de calculs qui requièrent énormément de puissance. À cela pourrait également s’ajouter l’énergie nécessaire pour traiter l’énorme volume de données de l’opération. Ce ne sont ici que des exemples montrant le coût énergétique élevé des IA. Pour ChatGPT-3, il lui aurait fallu plus de 1,2 TWh d’énergie pour son entraînement. D’autres LLM tels que Gopher et OPT (Open Pre-trained Transformer) auraient respectivement consommé 1 TWh et 324 MWh.

Bientôt une consommation équivalente à celle d’un pays ?

D’après l’étude, d’ici 2027, la consommation énergétique liée à l’IA pourrait être équivalente à celle de certains pays tels que les Pays-Bas, l’Argentine, la Suède ou l’Irlande. Les projections suggèrent une consommation allant de 85 à 134 TWh par an. La raison pour laquelle l’auteur de l’étude se projette en 2027 est qu’il anticipe une résolution des défis actuels liés à la chaîne d’approvisionnement. À l’heure actuelle, l’approvisionnement en serveurs d’IA est confronté à un goulot d’étranglement, la demande surpassant largement l’offre disponible. Par ailleurs, Alex de Vries anticipe une adoption croissante de l’IA. En effet, les technologies évoluent rapidement, avec des versions toujours plus performantes et efficaces qui voient le jour régulièrement, sans compter le nombre croissant d’entreprises souhaitant intégrer l’IA à leurs opérations.

L’IA est déjà au cœur de nombreuses controverses, qu’il s’agisse de l’utilisation de données sans consentement ou de la substitution potentielle de professionnels par des machines, pour ne citer que ces deux exemples. Une question se pose alors : cette consommation énergétique croissante s’ajoutera-t-elle à la liste des préoccupations majeures liées à l’IA ?