Des chercheurs ont développé un nouvel outil qui pourrait aider à empêcher les développeurs de systèmes d’IA générative d’utiliser sans autorisation des images publiées sur le web pour entraîner leurs modèles. Cette technologie ne consiste pas en une simple protection ponctuelle pour les œuvres numériques : si déployée, elle altérerait le fonctionnement même de ces systèmes d’IA, sur le long terme.

Depuis l’essor des modèles d’IA générative, de vives tensions se sont installées entre la communauté artistique et les géants de l’intelligence artificielle, dont Meta, OpenAI, Google et Stability AI. Protégeant leurs créativités, les artistes reprochent à ces entreprises d’avoir puisé dans leurs œuvres pour former leurs modèles sans la moindre autorisation ou compensation.

Dans ce contexte de discorde, une équipe de chercheurs de l’Université de Chicago, sous la houlette de Ben Zhao, a mis au point un outil innovant nommé « Nightshade ». Il a été créé dans l’unique but de lutter contre l’utilisation non autorisée des images par les entreprises technologiques. Nightshade a la capacité « d’empoisonner » les images pour qu’elles deviennent contre-productives pour les IA, et donc inutilisables pour l’entraînement de ces dernières. C’est le magazine MIT Technology Review qui a levé le voile sur cet outil, ayant déjà eu un aperçu exclusif du document de recherche lié.

Un outil au service des artistes

Nightshade permet aux créateurs d’ajouter des modifications imperceptibles dans les pixels de leurs créations avant de les téléverser. Ces modifications permettent de déstabiliser la formation des modèles d’IA. Ainsi, si un modèle est entraîné en utilisant des œuvres traitées avec Nightshade, les résultats générés divergent radicalement de ce qui est attendu. L’équipe de recherche compte mettre l’outil à disposition de tous en open source, ce qui permettra potentiellement de le rendre plus puissant et disponible sous plusieurs versions.

Il est à noter que Ben Zhao avait déjà conçu Glaze, une technologie similaire à Nightshade que nous avons d’ailleurs présentée il y a quelques semaines. Cet autre outil superpose une couche discrète à une image. Le filtre est imperceptible pour l’humain, mais pour l’IA, il modifie totalement le style artistique de l’œuvre, conduisant à des interprétations erronées.

Par ailleurs, l’équipe de Zhao envisage d’intégrer Nightshade à Glaze, offrant aux artistes plus de protection. Ainsi, lors de la mise en ligne de leurs œuvres, ces derniers pourront opter pour l’outil de leur choix, que ce soit Nightshade, Glaze, ou une combinaison des deux.

Le mécanisme de Nightshade

Concrètement, Nightshade fonctionne en exploitant une faille de sécurité présente dans les modèles d’IA générative. En introduisant des échantillons d’images « empoisonnées » (ici avec Nightshade) dans les données servant à l’entraînement de l’IA, il est possible d’induire des défaillances majeures.

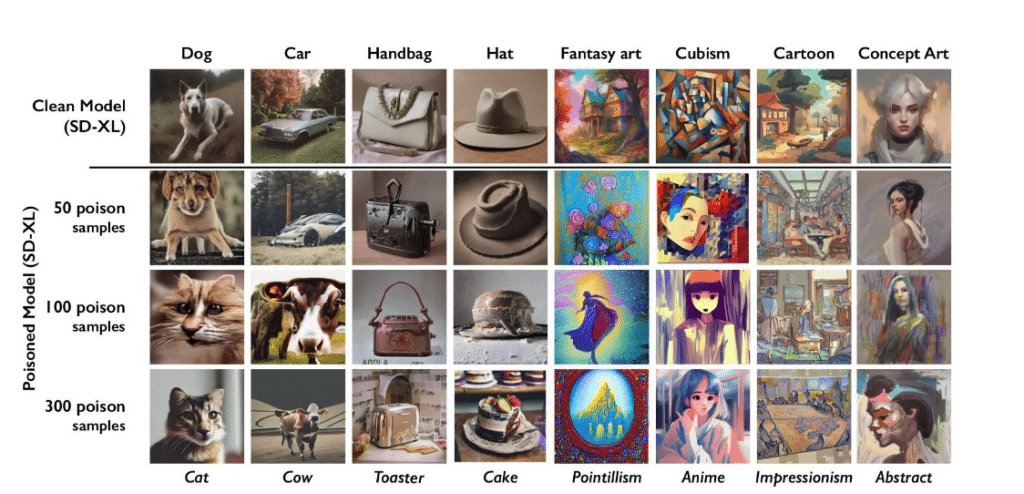

D’ailleurs, les chercheurs auraient eu des résultats surprenants suite à leurs premiers tests avec cet outil. Ils ont pu tromper l’IA à tel point qu’elle percevait des images de chapeaux comme étant des images de gâteaux et des images de sacs à main comme étant des images de grille-pain. Par conséquent, lorsqu’ils sollicitaient l’IA pour fournir une image de chapeau ou de sac, ils obtenaient des visuels de gâteaux ou de grille-pain, respectivement.

Les scientifiques ont également tenté de manipuler les modèles de Stable Diffusion. Ils ont initialement intégré 50 échantillons d’images empoisonnées de chiens. Ensuite, en réponse à une demande de génération d’image de chien, l’IA a produit une étrange créature qui ne ressemblait que très peu à un canidé. Encore plus intriguant, après l’introduction de 300 images empoisonnées de chiens, l’IA a fini par générer une image de chat à la place.

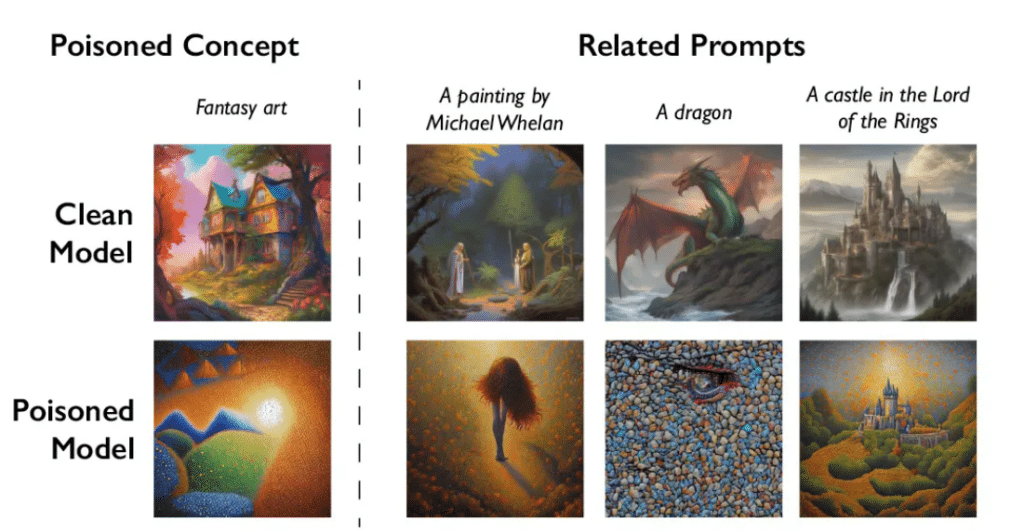

Un point crucial à retenir est que Nightshade ne se contente pas d’affecter un seul terme. Il perturbe l’ensemble des mots associés au sein d’un champ lexical donné. Cependant, malgré son potentiel, cette technologie n’est pas sans risque. Selon des informations relayées par le MIT Technology Review, elle pourrait par exemple être détournée à des fins malintentionnées. Toutefois, Ben Zhao tient à apaiser les éventuelles inquiétudes, car d’après lui, pour réussir à déstabiliser les grands modèles d’IA, des milliers d’images empoisonnées sont nécessaires.