Contribution à la désinformation, vol de données, licenciements massifs… telles sont (déjà) les conséquences actuelles de l’IA sur notre monde. Dans le futur, ces impacts pourraient être bien plus dramatiques, selon certains experts. Des modèles d’IA hors de contrôle ou contribuant à la création d’armes biologiques, des personnes devenues dépendantes du travail de l’IA, les inquiétudes sont variées. Mais certaines de ces visions du futur ne sont-elles pas un peu exagérées ? Pour Yann Le Cun, spécialiste français de l’IA, la réponse est oui.

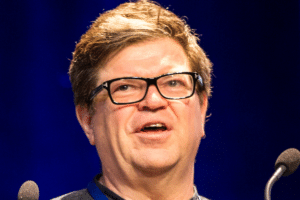

Dans un contexte de débats publics concernant les risques associés à l’émergence de l’IA, Yann Le Cun — scientifique en chef chez Meta et véritable parrain français de l’IA — s’oppose aux avis de certains dirigeants des grandes entreprises technologiques.

Dans un texte publié sur X, il critique ouvertement Sam Altman d’OpenAI, Demis Hassabis de Google DeepMind, et Dario Amodei d’Anthropic. Selon LeCun, ces derniers contribuent volontairement et stratégiquement à semer un climat de peur au sein du grand public, en véhiculant des scénarios catastrophiques liés à l’IA. Il accuse également ces dirigeants de s’adonner à des pratiques de lobbying, c’est-à-dire qu’ils tenteraient d’influencer la réglementation dans le domaine de l’IA. Tout cela pour l’intérêt de leurs entreprises.

Une manœuvre de diversion ?

Depuis la mise en ligne de ChatGPT, le débat sur les dangers de l’IA s’est intensifié. Certains vont jusqu’à évoquer des scénarios dignes de Terminator, où la technologie se retournerait contre les humains. Récemment, même les dirigeants de la société spécialisée dans l’IA de Google, DeepMind, ont exprimé leurs préoccupations concernant le développement de l’intelligence artificielle générale (IAG) et les dangers potentiels qui pourraient en découler.

Par ailleurs, il y a quelques mois, plus d’un millier de leaders du secteur technologique ont signé une lettre appelant à un arrêt d’au moins six mois du développement de l’IA. Les signataires accordent le fait que cette technologie présente « des risques profonds pour la société et l’humanité ».

Mais pour Yann Le Cun, ces discours alarmistes ne sont qu’une tactique de diversion destinée à détourner l’attention du public des véritables risques de l’IA, dont le vol de données. Le scientifique en chef de Meta estime qu’une catastrophe apocalyptique est peu probable. Il explique en effet que le développement d’une technologie suit un processus rigoureux comprenant la recherche, le développement, les tests et les améliorations nécessaires avant son déploiement à grande échelle. Ce processus permet de résoudre les problèmes en amont et d’assurer la sécurité de l’outil.

Une tout autre inquiétude

En plus des risques liés au vol de données qu’il a évoqués, LeCun a exprimé une autre de ses inquiétudes majeures. Il craint qu’un petit nombre d’entreprises ou d’individus fortunés ne parviennent à exercer un contrôle sur l’IA, notamment si la supposée « diversion » porte ses fruits. Ces individus et entités constitueraient seulement 1% des acteurs de la filière.

Selon le scénario envisagé par LeCun, ce 1% pourraient ainsi exploiter leur position dominante pour accaparer les ressources et les avantages de l’IA, privant ainsi le reste de la société des bénéfices économiques potentiels de cette technologie. Ces bénéfices incluent des avantages économiques, mais aussi sociaux, tels que l’amélioration de la productivité, la résolution de problèmes complexes et la création de nouvelles opportunités économiques. LeCun estime que les entreprises situées principalement sur la côte ouest des États-Unis et en Chine seraient les plus susceptibles de dominer le secteur.

Pour contrer ce scénario, il prône la transparence et un accès plus large à l’IA. Il défend ainsi l’idée selon laquelle le développement de l’IA devrait être open source (à code ouvert), permettant à une large communauté de contribuer à l’avancement de la technologie et de veiller à son accessibilité globale.