De nombreux artistes sont en colère. Et pour cause : plusieurs applications qui génèrent des visuels et des portraits grâce à l’intelligence artificielle se sont copieusement servies dans leurs œuvres pour apprendre à répondre aux demandes des utilisateurs. S’il leur est difficile de trouver un recours légal à l’heure actuelle, il va bientôt leur être possible d’agir pour retirer leurs créations de la base de données de certaines de ces IA.

« C’est frustrant et cela ressemble à une violation », avait déclaré récemment l’artiste Kim Leutwyler dans un article du Guardian. « Nous ne sommes pas indemnisés, nous ne sommes pas crédités pour ça ». Ce coup de gueule que nous avions mis en lumière à travers un article en décembre est surtout lié à l’application Lensa, qui a gagné fortement en popularité en quelques mois.

Cette dernière s’appuie sur Stable Diffusion, une intelligence artificielle capable « d’apprendre » à générer des images qui correspondent à une description rentrée par l’utilisateur. En résumé, il suffit de dire à l’IA ce que vous voulez qu’elle dessine pour obtenir un visuel à bas coût. Une possibilité qui n’a pas manqué de fasciner de nombreux utilisateurs : « Il est facile de comprendre pourquoi des applications comme Lensa ont captivé l’imagination de millions d’utilisateurs. Les portraits que Lensa produit sont dans une variété de styles flashy qui sont assez convaincants pour un œil non critique. À seulement 7,99 $ l’unité pour un lot de 50 images, beaucoup ont trouvé en Lensa le moyen idéal de créer une photo de profil pour les médias sociaux à un coût négligeable », écrivait en décembre à ce sujet le média Futurism.

Là où le bât blesse, c’est sur la provenance des images utilisées par Stable diffusion pour parfaire son apprentissage. En effet, ce qu’on appelle intelligence artificielle, c’est aujourd’hui la plupart du temps un « réseau neuronal artificiel ». Concrètement, il s’agit d’un système inspiré du fonctionnement des neurones biologiques, qui s’est rapproché par la suite de méthodes statistiques. En résumé, l’intelligence artificielle se « nourrit » d’un grand nombre de données. Elle en extrait des connexions logiques et les traite en vue d’un résultat. Ici, l’IA doit donc être nourrie d’images pour apprendre à créer de nouvelles images en fonction de la requête proposée.

Afin de fournir suffisamment d’images à l’IA, ses créateurs se sont basés sur la base de données nommée LAION-5B. Or, celle-ci utilise des œuvres issues de nombreuses plateformes alimentées par des artistes, telles que Deviant Art, Art Station, Getty Images… Si celles-ci ne sont pas « copiées » à l’identique, certains styles sont largement reconnaissables dans les images fournies par Lensa. Pourtant, les artistes concernés n’ont pas vraiment trouvé de recours légal pour le moment.

Une situation juridique inédite

Et pour cause : « [Ces outils fonctionnent] de la même manière qu’un être humain est capable d’apprendre et de s’autoformer à certains principes artistiques élémentaires en observant l’art, en explorant l’imagerie en ligne et en apprenant des artistes et en essayant finalement de créer quelque chose basé sur ces compétences agrégées », se défend à ce sujet un porte-parole de l’entreprise. En effet, si une œuvre d’art est bel et bien protégée, cela n’est pas vraiment le cas du style général utilisé pour créer une œuvre, notamment dans le droit américain.

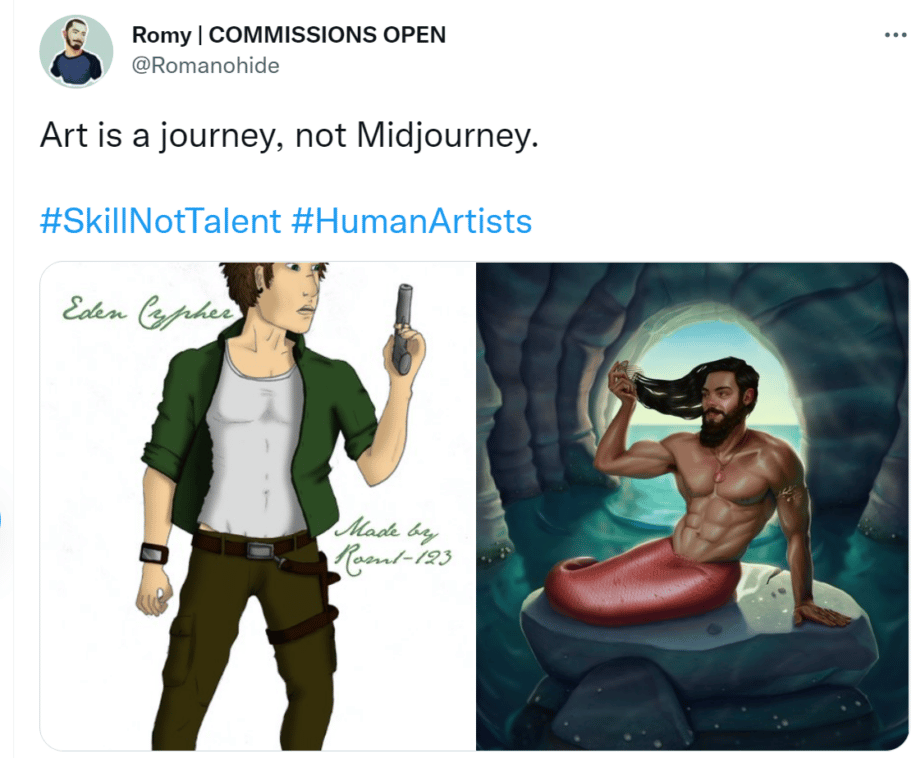

Art is a journey, not Midjourney.#SkillNotTalent #HumanArtists pic.twitter.com/ybE7vX6Fme

— Romy | COMMISSIONS OPEN (@Romanohide) December 13, 2022

Il n’en reste pas moins que le cas de figure est assez nouveau, puisqu’une machine « n’apprend » pas de la même façon qu’un être humain. « L’art est un voyage (ndlr : ‘journey’, en anglais), pas Midjourney », ironise ainsi l’artiste français Romanohide sur Twitter, en postant symboliquement côte à côte une de ses premières et dernières œuvres. La situation paraît donc injuste à de nombreux artistes, et pourrait constituer un nouveau terrain d’exploration juridique. En attendant, et depuis peu, les artistes ont tout de même un recours. Le 15 décembre dernier, Stability AI, l’entreprise derrière Stable Diffusion, a annoncé sur Twitter que la version 3.0 de son IA permettrait aux artistes qui le souhaitent de retirer leurs œuvres de la base de données d’apprentissage.

Opt-in as well of course, about 50:50 both ways.

Technically this is tags for LAION and coordinated around that.

It's actually quite difficult due to size (eg what if your image is on a news site?)

Exploring other mechanisms for attribution etc, welcome constructive input. https://t.co/uYvN4yHldo

— Emad (@EMostaque) December 14, 2022

Afin de leur permettre de vérifier si leurs œuvres y ont bel et bien été intégrées, l’organisation Spawning, créée l’année dernière, met à disposition un site internet qui permet ce contrôle : haveibeentrained.com. Il « suffit » donc aux artistes d’effectuer la vérification et de demander le cas échéant à Stability AI de retirer leurs créations. Cette mesure s’avère insuffisante pour bon nombre d’internautes, qui ont réagi à la nouvelle de façon mitigée. « Le consentement ne sera jamais vraiment respecté tant que ce ne sera pas uniquement basé sur de l’ajout volontaire. (…) Tout cela est un gâchis et doit être rayé et reconstruit de manière éthique », résume ainsi un certain Justin Wieier sur YouTube.

La vidéo explicative de Spawning :