Les grands modèles de langage (LLM) populaires comme ChatGPT d’OpenAI et Bard de Google sont énergivores, nécessitant de gigantesques centres de données (serveurs) pour fournir et traiter suffisamment de données afin de former les puissants algorithmes. La quantité d’eau utilisée pour le refroidissement de ces infrastructures est considérable. Récemment, des chercheurs ont montré qu’un simple échange conversationnel d’un utilisateur moyen avec ChatGPT revient à consommer une bouteille d’un demi-litre d’eau douce. ChatGPT et les autres IA seraient-elles une nouvelle menace pour nos réserves d’eau douce, dans le contexte de crise climatique ?

Microsoft, Google et Meta investissent des milliards de dollars dans l’intelligence artificielle (IA) générative, comme le grand modèle de langage ChatGPT d’OpenAI. Mais les caractéristiques qui rendent ces modèles tellement plus puissants que leurs prédécesseurs imposent également un lourd tribut à l’environnement.

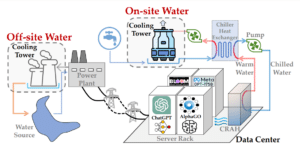

De plus en plus de modèles d’IA sont entraînés et déployés sur des serveurs énergivores. Par conséquent, leur empreinte carbone a fait l’objet d’un examen public, qui a entraîné de récents progrès. Malheureusement, l’énorme empreinte hydrique des modèles d’IA, pour générer l’électricité alimentant les serveurs de centres de données et pour refroidir ces derniers, est restée sous le radar, ce qui, s’il n’est pas correctement traité, peut devenir un problème majeur.

Effectivement, selon les Nations-Unies, la pénurie d’eau touche actuellement près de 700 millions de personnes à travers le monde. En 2025, 1,8 milliard de personnes vivront dans des régions affectées par une pénurie d’eau totale. D’ici 2030, ce sera près de la moitié de la population de la planète qui souffrira d’un fort stress hydrique.

Récemment, des chercheurs de l’Université du Colorado Riverside et de l’Université du Texas à Arlington ont examiné pour la première fois l’impact hydrique de la formation de telles IA : elle équivaut selon eux à la quantité d’eau nécessaire pour refroidir un réacteur nucléaire, soit 700 000 litres d’eau. Une aberration dans le contexte climatique. Leur article est publié sur la plateforme arXiv en attendant d’être révisé par les pairs.

Pourquoi tant d’eau ?

Les centres de données, qu’ils soient utilisés pour former des algorithmes, stocker des informations ou faire tourner des sites web, contiennent énormément de matériel informatique, qui dégage beaucoup de chaleur devant être évacuée (risquant le cas échéant d’endommager l’équipement). De fait, les salles de serveurs sont maintenues entre 10 et 27 °C et une quantité importante d’eau douce propre (l’eau de mer étant corrosive) est utilisée pour refroidir les circuits.

De manière simplifiée, de l’eau est pompée dans un lac, elle est conduite dans un refroidisseur puis injectée dans les conduits des salles de serveurs où elle absorbe la chaleur. L’eau réchauffée repart dans le refroidisseur puis dans une tour de refroidissement, où les pertes en eau se font par évaporation, pour dissiper la chaleur dans l’environnement.

De plus, il existe un processus de purge qui draine l’eau de refroidissement pour réduire la concentration de sel accumulée dans la tour de refroidissement — et qui consomme donc également de l’eau.

Par exemple, les centres de données de Google aux États-Unis ont consommé à eux seuls 12,7 milliards de litres d’eau douce pour le refroidissement en 2021. Cette quantité est suffisante pour produire 5,7 millions de véhicules électriques (y compris la fabrication de cellules de batteries) par Tesla.

Les auteurs notent : « ChatGPT doit ‘boire’ [l’équivalent] d’une bouteille d’eau de 500 ml pour une conversation simple d’environ 20 à 50 questions et réponses. Bien qu’une bouteille d’eau de 500 ml puisse ne pas sembler beaucoup, l’empreinte hydrique totale combinée pour l’inférence est toujours extrêmement importante, compte tenu des milliards d’utilisateurs de ChatGPT ».

Une soif inextinguible, mais des réserves limitées. Quelles solutions ?

Comme mentionné précédemment, la pénurie d’eau douce est l’un des défis les plus urgents que nous partageons tous dans le contexte de la crise climatique et de la croissance démographique rapide. Une grave pénurie d’eau affecte déjà 4 milliards de personnes, soit environ les deux tiers de la population mondiale, pendant au moins un mois chaque année. Sans approches intégrées et inclusives pour relever le défi mondial de l’eau, près de la moitié de la population mondiale subira un stress hydrique sévère d’ici 2030.

C’est pourquoi les auteurs tentent d’apporter quelques recommandations afin de faire baisser l’empreinte hydrique des IA. Ainsi, le lieu et le moment où les modèles d’IA sont formés font une énorme différence. Les températures ambiantes plus fraîches nécessitent moins d’eau. Cela signifie que les modèles pourraient être entraînés la nuit et/ou dans des endroits aux climats plus froids.

Dilemme soulevé : les régions plus ensoleillées et donc plus chaudes permettent de produire une énergie solaire plus verte pour le fonctionnement des structures. Néanmoins, cette chaleur nécessite plus de consommation d’eau. Les auteurs expliquent : « En d’autres termes, se concentrer uniquement sur l’empreinte carbone des modèles d’IA est loin d’être suffisant pour permettre une IA véritablement durable ».

Du point de vue des utilisateurs, il est nettement plus difficile de mettre en place des « heures creuses » pour les demandes ChatGPT, car les données concernant les périodes critiques d’utilisation de l’eau des serveurs font actuellement défaut. Les auteurs réclament donc bien plus de transparence de la part des opérateurs.

Ils concluent : « L’empreinte hydrique des modèles d’IA ne peut plus rester sous le radar, elle doit être traitée en priorité dans le cadre des efforts collectifs pour lutter contre les défis mondiaux liés à l’eau ».