Créer un jumeau numérique de la Terre consiste à simuler le système terrestre de manière complète, à haute résolution, afin de déterminer les tendances météorologiques et climatiques à venir. Ce type de simulation peut aider les décideurs à prendre les mesures nécessaires pour mieux se préparer aux événements extrêmes à venir. Ces travaux seront menés par une équipe du Centre européen pour les prévisions météorologiques à moyen terme, en collaboration avec des informaticiens de l’École polytechnique fédérale de Zürich.

L’Union européenne s’est fixé pour objectif d’atteindre la neutralité climatique d’ici 2050. Pour soutenir sa transition écologique, elle compte s’appuyer sur les technologies numériques de diverses manières. Ce jumeau numérique de la Terre est au cœur de l’initiative « Destination Terre », qui vise à améliorer radicalement les capacités de l’Europe en matière de prévision des phénomènes météorologiques extrêmes, de mesure de l’incidence du changement climatique et de gestion des catastrophes naturelles et environnementales.

La pression pour fournir des prévisions pertinentes des extrêmes dans un climat changeant — par exemple, le nombre et l’intensité des cyclones tropicaux et la probabilité de vagues de chaleur et de sécheresse concomitante — est particulièrement forte, car l’impact actuel des risques naturels au niveau mondial est stupéfiant. Au cours de la période 1998-2017, ces événements climatiques ont causé plus d’un million de morts et plusieurs milliards de dollars de pertes économiques.

Un futur outil d’aide à la décision

L’initiative Destination Terre doit débuter cette année et devrait durer dix ans. Pendant cette période, les scientifiques devront élaborer un modèle numérique très précis de notre planète. Les données d’observation, issues d’antennes, de satellites ou d’aéronefs, seront incorporées à ce modèle continuellement. En outre, les chercheurs souhaitent y intégrer des données sur les activités humaines (pollution, incendies, mouvements de masse, etc.). Ainsi, ce jumeau numérique devrait, à terme, représenter quasiment tous les processus à la surface de la Terre de la manière la plus réaliste possible, y compris l’influence des humains sur la gestion de l’eau, de la nourriture et de l’énergie, et les processus du système terrestre physique.

Ce modèle numérique constituera un véritable outil d’aide à la décision, car il permettra de tester différents scénarios. « Si vous prévoyez une digue de deux mètres de haut aux Pays-Bas, par exemple, je peux parcourir les données de mon jumeau numérique et vérifier si la digue protégera vraisemblablement encore contre les événements extrêmes prévus en 2050 », explique Peter Bauer, directeur adjoint de la recherche au Centre européen pour les prévisions météorologiques à moyen terme (ECMWF) et co-initiateur de Destination Terre. Il pourra également être utilisé pour la planification stratégique des approvisionnements en eau douce et en nourriture, ou bien pour les parcs éoliens et les centrales solaires.

Pour Bauer, il était indispensable que les experts en sciences de la terre et en informatique collaborent pour mener à bien ce projet. Les chercheurs de l’ECMWF ont donc travaillé avec des scientifiques de l’ETH Zurich et du Centre suisse de calcul scientifique (CSCS) ; ensemble, ils proposent des mesures concrètes qu’ils aimeraient utiliser pour faire avancer cette « révolution numérique des sciences du système terrestre ». Le fruit de leur réflexion vient d’être publié dans la revue Nature Computational Science.

Les modèles climatiques actuels représentent déjà un large ensemble de processus physiques, mais négligent généralement les processus de plus petite échelle, qui sont pourtant essentiels pour établir des prévisions météorologiques précises. Les modèles climatiques doivent représenter des cycles fermés et stables de l’énergie, de l’eau et des constituants au détriment des détails des processus à petite échelle ; les modèles météorologiques, en revanche, ont besoin de ce niveau de détail pour fournir des prévisions localement précises, mais choisissent d’exclure les processus du système terrestre qui sont moins pertinents à des échelles de temps quotidiennes.

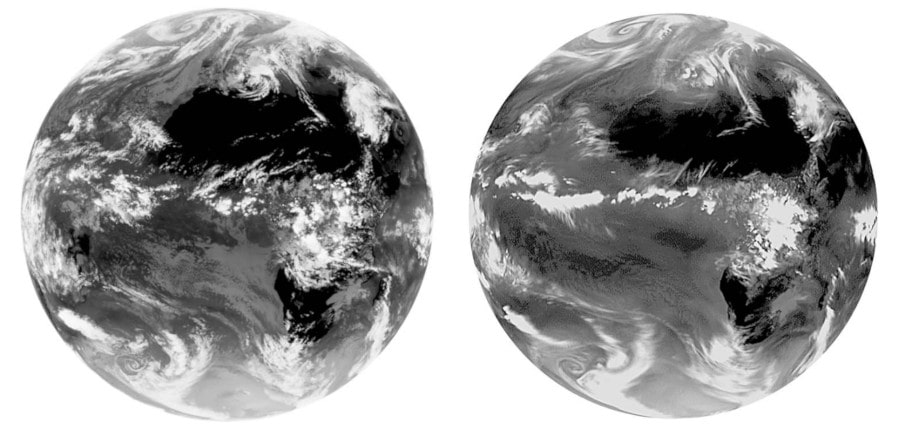

Le jumeau numérique vise à répondre à ces deux besoins et devrait aller beaucoup plus loin en termes de précision et de masse de données traitées : les chercheurs ambitionnent de créer une cartographie au kilomètre carré (tandis que les modèles climatiques et météo qui quadrillent le globe aujourd’hui ont des mailles plus larges, de dizaines ou centaines de kilomètres carrés). Pour y parvenir, les programmes de simulation doivent être adaptés aux nouvelles technologies promettant une puissance de calcul nettement améliorée.

Développer le matériel et les algorithmes simultanément

Avec les ordinateurs et les algorithmes disponibles aujourd’hui, les simulations très complexes peuvent difficilement être effectuées à la résolution extrêmement élevée prévue, car pendant des décennies, le développement de code a stagné d’un point de vue informatique. En effet, pendant quelque temps, la recherche climatique a pu exploiter les nouvelles générations de processeurs sans avoir à modifier fondamentalement le code de ses programmes.

Mais ce gain de performance « gratuit » s’est arrêté il y a environ 10 ans. « Jusqu’alors, la performance de chaque processeur augmentait et il était aisé d’ajouter de la complexité, de la résolution, ou de faire des simulations plus longues. Mais la loi de Moore s’étiole : nous gagnons désormais de la puissance en additionnant les processeurs, ou grâce à des architectures complexes mêlant par exemple processeurs CPU et accélérateurs GPU. C’est une révolution pour le calcul, qui nécessite de retravailler nos codes en profondeur » résume Sylvie Joussaume, climatologue et directrice de recherche au CNRS. Aujourd’hui, les programmes actuels ne peuvent généralement utiliser que 5% des performances de pointe des processeurs conventionnels.

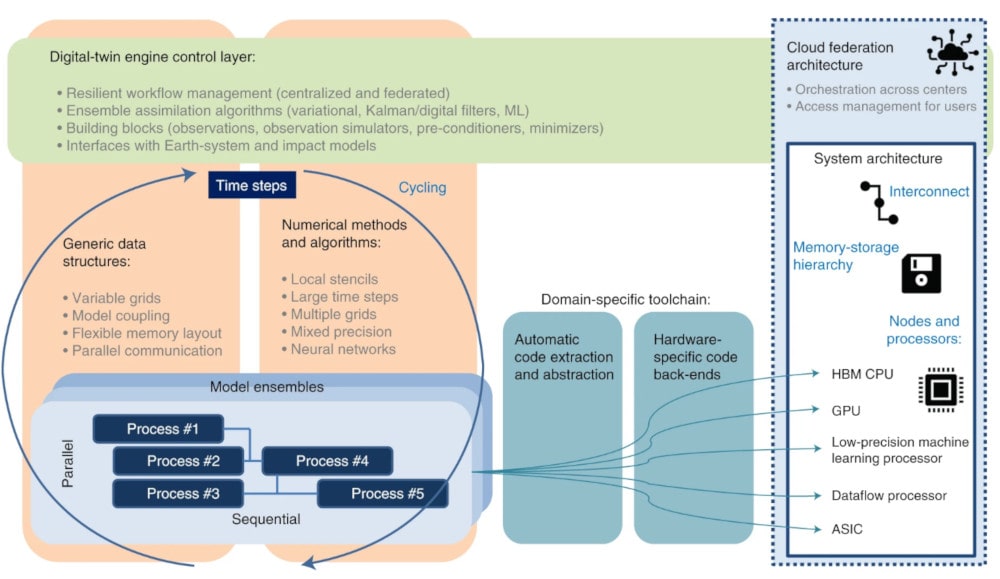

Pour réaliser les améliorations nécessaires, les chercheurs insistent sur la nécessité de co-conception, c’est-à-dire le développement simultané du matériel et des algorithmes. Ils suggèrent en outre de séparer les codes des architectures système, de manière à pouvoir envisager une transition plus rapide et plus efficace vers les architectures futures. L’intelligence artificielle a selon eux un rôle majeur à jouer dans ce projet pour accélérer les simulations. Elle pourrait notamment être utilisée pour collecter, filtrer et traiter les données d’observation, ou représenter les processus physiques incertains. Les chercheurs pensent que l’apprentissage automatique peut non seulement rendre les calculs plus efficaces, mais peut également aider à décrire les processus physiques plus précisément.

Parmi les architectures informatiques disponibles aujourd’hui et celles attendues dans un futur proche, les supercalculateurs basés sur des unités de traitement graphique (GPU) apparaissent comme l’option la plus prometteuse. Les chercheurs estiment que l’exploitation d’un jumeau numérique à pleine échelle nécessiterait un système équipé d’environ 20’000 GPU, consommant environ 20 MW d’énergie. Pour des raisons à la fois économiques et écologiques, un tel ordinateur devra être utilisé dans un endroit où l’électricité produite neutre en CO2 est disponible en quantité suffisante.