Des chercheurs ont conçu un outil basé sur l’IA capable de lire les pensées afin de les traduire en texte. La technologie repose sur deux modèles distincts d’IA. Le premier analyse les signaux électriques cérébraux tandis que le deuxième traduit ces derniers sous forme de texte. Le dispositif n’est pas totalement au point, mais il montre une fiabilité de conversion étonnante pour un prototype : plus de 60%.

Des signaux électriques sont constamment produits dans le cerveau, résultant de l’activité neuronale, que ce soit lorsque nous pensons, bougeons ou dormons… Grâce aux dernières avancées des technologies de lecture cérébrale, ces signaux peuvent désormais être interprétés avec une certaine précision.

Ces technologies avancées sont exploitées par certaines startups neurotechnologiques comme Neuralink, dont l’un des objectifs est d’aider les personnes paralysées à communiquer ou à contrôler des appareils électroniques par la pensée. Cependant, bien que prometteur, le dispositif de Neuralink présente de nombreux risques : afin de lire correctement les signaux, il nécessite une intervention chirurgicale visant à implanter ses électrodes dans directement dans le tissu cérébral.

Récemment, des chercheurs ont développé un système non invasif éliminant complètement le besoin de chirurgie. Issus de l’Université de technologie de Sydney (UTS), plus précisément du département d’IA centrée sur l’humain (GrapheneX-UTS), ils ont mis au point un dispositif qui permet de traduire les pensées en texte. Il a été présenté lors de l’événement NeurIPS, une conférence dédiée aux avancées de l’IA, en Louisiane.

Deux modèles d’IA pour lire vos pensées…

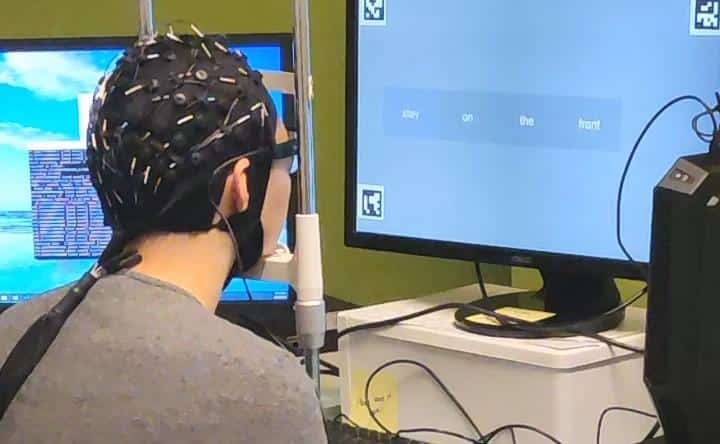

Pour développer ce nouveau dispositif, l’équipe a d’abord mené une expérience sur 29 participants, qui étaient chargés de lire des passages de texte. Pendant qu’ils lisaient, ils portaient un équipement spécialisé enregistrant l’activité électrique du cerveau. Cette activité cérébrale était mesurée par un dispositif commun appelé électroencéphalogramme (EEG). La méthode implique l’utilisation de capteurs placés sur le cuir chevelu, qui détectent les signaux électriques produits par le cerveau. Les signaux enregistrés par l’EEG étaient ensuite transmis à un modèle d’IA appelé DeWave.

Au cours de son entraînement, DeWave était exposé à une grande variété de signaux, chacun associé à des mots ou des phrases spécifiques. En effet, chaque mot ou phrase pensée génère un motif de signal différent.

Après qu’il a « appris à comprendre » les signaux cérébraux, DeWave a été connecté à un grand modèle de langage (LLM) open source. Ce deuxième modèle d’IA agit comme une sorte « d’écrivain cérébral » utilisé pour formuler des phrases cohérentes et significatives à partir des informations brutes fournies par le premier modèle. Le LLM ne génère pas seulement des mots isolés basés sur les signaux cérébraux, mais construit des phrases complètes, en tenant compte du contexte et de la structure linguistique.

Jusqu’à 60 % de précision

Initialement, le système avait une précision d’environ 40 %, c’est-à-dire que lors de la conversion des pensées en texte, environ 40 % des mots ou phrases générés correspondaient correctement à ce que les participants pensaient (lisaient). Toutefois, l’équipe a précisé que des recherches actuelles ont déjà permis une amélioration, notamment d’atteindre une efficacité supérieure à 60 %.

Évidemment, une fiabilité encore plus élevée est nécessaire pour rendre cette technologie viable pour des applications pratiques. Les chercheurs espèrent qu’à terme, leur système pourrait aider les personnes ayant perdu la parole (dont celles souffrant de séquelles post-AVC) à communiquer à nouveau. Pour ces individus, une telle technologie offrirait un nouveau moyen d’expression.

Le système a également le potentiel d’être utilisé dans le domaine de la robotique. En effet, la technologie pourrait offrir une interface plus naturelle et intuitive faisant le pont entre l’humain et la machine : notamment via des interfaces ou les instructions/commandes seraient transmises par la pensée.

Vidéo de démonstration réalisée par l’UTS (© YouTube/UTS HAI Research) :