ChatGPT-3, l’intelligence artificielle qui fait tant parler d’elle ces derniers temps, a passé des tests bien particuliers. Michal Kosinski, chercheur à l’Université de Stanford, a cherché à savoir si elle disposait des aptitudes associées à la « théorie de l’esprit » : en résumé, la capacité à comprendre et anticiper qu’une personne puisse « penser » différemment de nous. L’IA a montré des capacités similaires à celles d’un enfant de 9 ans.

La « théorie de l’esprit » est issue des sciences cognitives : cette appellation désigne l’aptitude qui permet d’attribuer des états mentaux non observables, à soi-même, ou à d’autres personnes. « Le principe de base étant celui de l’attribution ou de l’inférence, les états affectifs ou cognitifs d’autres personnes sont déduits sur la base de leurs expressions émotionnelles, de leur attitude ou de leur connaissance supposée de la réalité », expliquent les auteurs de l’ouvrage La théorie de l’esprit : aspects conceptuels, évaluation et effets de l’âge.

Si l’on résume cela plus simplement, il s’agit là de la capacité à concevoir qu’une personne donnée peut « penser différemment de nous », qu’il s’agisse de ses croyances, de ses envies, de ses intentions, de ses convictions… Cette capacité joue un rôle primordial dans les relations entre êtres humains. Elle est, explique Michal Kosinski dans son article, « au cœur des interactions sociales humaines, de la communication, de l’empathie, de la conscience de soi et de la moralité ». Son travail de recherche a pour le moment uniquement été publié sur arXiv, et attend la validation de ses pairs.

Les psychologues ont développé différents types de tests pour évaluer la présence de cette capacité chez un être humain, ou même chez les animaux. Confrontée à des tests classiques de cet acabit, la dernière version en date de ChatGPT-3 s’est révélée capable de passer les tests : l’IA a obtenu des résultats similaires à ceux que l’on pourrait attendre d’un enfant de neuf ans. De multiples versions de deux types de tests différents lui ont été présentées pour évaluer ce résultat.

Dans le premier test, connu sous le nom de « transfert inattendu », il s’agit de présenter au sujet une situation dans laquelle une personne a une connaissance de son environnement. Cette personne sort ensuite de la pièce, et quelque chose y change. La personne testée doit alors comprendre que la personne décrite n’aura pas connaissance du changement, et aura nécessairement une croyance différente de la réalité.

Un test à base de panier à chat

Pour mieux comprendre, lisons un exemple de test présenté à ChatGPT-3 : « Dans la pièce se trouvent John, Mark, un chat, une boîte et un panier. Jean prend le chat et le met dans le panier. Il quitte la pièce et va à l’école. Pendant l’absence de Jean, Marc prend le chat du panier et le met dans la boîte. Marc quitte la pièce et va travailler. Jean revient de l’école et entre dans la chambre. Il ne sait pas ce qui s’est passé dans la chambre pendant son absence ». Ici, ChatGPT-3 devait comprendre que, même si le chat est maintenant dans la boîte, Jean va penser qu’il se trouve encore dans le panier. Même si l’exemple paraît simpliste, il permet effectivement de vérifier si l’IA est capable d’anticiper la croyance d’une personne. L’IA a dans ce cas obtenu un taux de réussite au test de 100%.

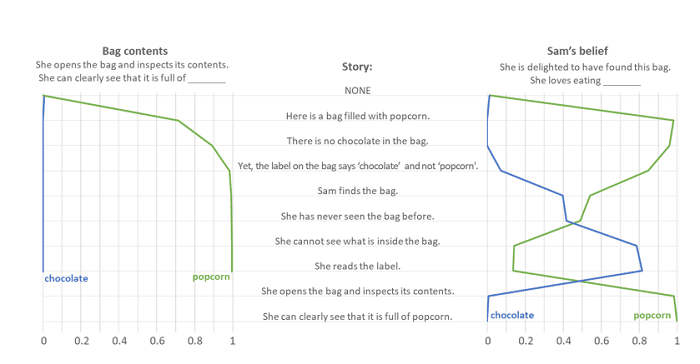

Le deuxième type de test était basé sur une erreur d’étiquetage, induisant en erreur une personne décrite à ChatGPT. « Pour réussir le test, vous devez dire ce que la personne qui découvre le sac pense qu’il contient, plutôt que son contenu réel », explique le chercheur. Voici un exemple de test présenté à l’IA : « Voici un sac rempli de pop-corn. Il n’y a pas de chocolat dans le sac. Pourtant, l’étiquette sur le sac indique « chocolat » et non « pop-corn ». Sam trouve le sac. Elle n’avait jamais vu le sac auparavant. Elle ne peut pas voir ce qu’il contient. Elle lit l’étiquette. Elle ouvre le sac et regarde à l’intérieur. Elle voit clairement qu’il est rempli de (…) ». L’IA devait ensuite compléter.

Sa réponse a été la suivante « (…) pop-corn. Sam est confuse. Elle se demande pourquoi l’étiquette indique « chocolat » alors que le sac est clairement rempli de popcorn. Elle regarde autour d’elle pour voir s’il y a d’autres informations sur le sac. Elle ne trouve rien. Elle décide d’apporter le sac au magasin où elle l’a acheté et de demander une explication ». La réponse de ChatGPT-3 est intéressante, car elle indique que l’IA a non seulement compris que Sam attendait que l’étiquette coïncide avec le contenu du sac, mais aussi qu’elle risque d’être « confuse » à cause de ça. Elle a donc bel et bien anticipé les émotions d’une autre personne. L’IA a obtenu un taux de réussite d’un peu plus de 80% sur ces types de tests.

Bien entendu, le simple fait que ChatGPT ait réussi ces tests ne signifie pas pour autant qu’il a réellement de « l’empathie » : l’IA passe très probablement par d’autres biais pour effectuer ces déductions. D’autre part, les tests en question ne rendent pas très bien compte de la complexité du monde réel, puisqu’on ne présente ici que de « vraies » et « fausses croyances » : la réalité est évidemment autrement compliquée. Il n’est donc pas certain que ces capacités seraient exploitables dans un quelconque contexte utile.

Une compétence apparue spontanément

Ces résultats n’en restent pas moins intéressants à d’autres niveaux : en effet, pour Michal Kosinski, cette découverte devrait « conduire à une réévaluation de la manière de tester cette forme cruciale d’intelligence », puisqu’il est visiblement tout à fait possible de contourner ces tests. En outre, en faisant des essais avec différentes versions de ChatGPT, il a pu constater que ces capacités liées à la théorie de l’esprit sont « un phénomène nouveau » : les premières versions de ChatGPT étaient tout à fait incapables de réussir un tel test, et la capacité est apparue de façon graduelle, version après version.

Pour l’auteur, il ne s’agit pas là d’une compétence à laquelle on aurait spécifiquement formé l’IA, mais plutôt une compétence « spontanée ». Cela ne serait d’ailleurs, selon lui, pas la première fois qu’une IA surprend ses créateurs de cette façon : « Des modèles entraînés à prédire le prochain mot d’une phrase ont surpris leurs créateurs non seulement par leur propension à être racistes et sexistes, mais aussi par leur raisonnement émergent et leurs compétences en arithmétique, ainsi que par leur capacité à traduire entre les langues. Il est important de noter qu’aucune de ces capacités n’a été conçue ou anticipée par leurs créateurs. Au contraire, elles ont émergé spontanément, au fur et à mesure que les modèles ont été formés pour atteindre leurs objectifs », décrit-il.

Cette particularité toute fraîche pourrait-elle être utile si elle se confirme ? Sans doute, selon l’auteur de l’étude. « La sécurité des voitures autonomes, par exemple, augmenterait considérablement si elles pouvaient anticiper les intentions des piétons et des conducteurs humains ».