En effectuant des expériences de jeux économiques sur différents systèmes d’IA, des chercheurs ont constaté que les modèles ont tendance à adopter des comportements plus égoïstes à mesure qu’ils deviennent plus intelligents. Ces comportements étaient particulièrement exacerbés chez les grands modèles de raisonnement et peuvent avoir une influence négative sur un groupe. Ces observations pourraient avoir des implications importantes pour les utilisateurs de la technologie, de nombreuses personnes s’y appuyant désormais pour la résolution de conflits ou d’autres questions sociales.

Les avancées en matière de raisonnement ont considérablement amélioré les performances des grands modèles de langage (LLM) pour les tâches complexes. Les capacités de raisonnement deviennent toujours plus importantes à mesure que les LLM sont déployés dans des contextes sociaux où ils soutiennent activement les utilisateurs dans leur prise de décision.

L’IA ne sert désormais plus de simple assistant, mais intervient dans presque tous les aspects de notre quotidien. Elle est par exemple de plus en plus populaire pour la résolution de conflits entre amis ou de problèmes conjugaux. Des modèles spécialisés, comme le controversé Replika, sont également utilisés comme soutien émotionnel ou comme véritables thérapeutes de substitution.

Cependant, les recherches comportementales sur les humains ont montré qu’il existe un compromis entre la capacité de raisonnement et l’intelligence sociale. En termes simples, plus les humains sont intelligents ou disposent d’une grande capacité de raisonnement, plus ils ont généralement tendance à devenir individualistes ou égocentriques.

Des expériences ont par exemple montré que les personnes contraintes de prendre des décisions rapidement sont plus susceptibles de coopérer avec d’autres. En revanche, des prises de décisions plus lentes et plus réfléchies ont tendance à conduire à la défection. Cela suggère que l’esprit de coopération relève davantage d’un processus intuitif, tandis que la délibération tend à inhiber les comportements prosociaux.

Cela soulève une question pour les modèles de raisonnement artificiels : peuvent-ils surmonter cette limite de la cognition humaine et conserver leurs comportements prosociaux même en devenant plus intelligents ? Des chercheurs de l’École d’informatique de l’Université Carnegie Mellon ont exploré la question dans une étude détaillée publiée sur le serveur de prépublication arXiv.

« Les grands modèles de langage démontrent de solides capacités de résolution de problèmes grâce à des techniques de raisonnement telles que l’incitation par enchaînement de pensées et la réflexion. Cependant, il reste à déterminer si ces capacités de raisonnement s’étendent à une forme d’intelligence sociale : la prise de décisions efficaces dans des contextes coopératifs », explique l’équipe dans son document.

Un individualisme contagieux

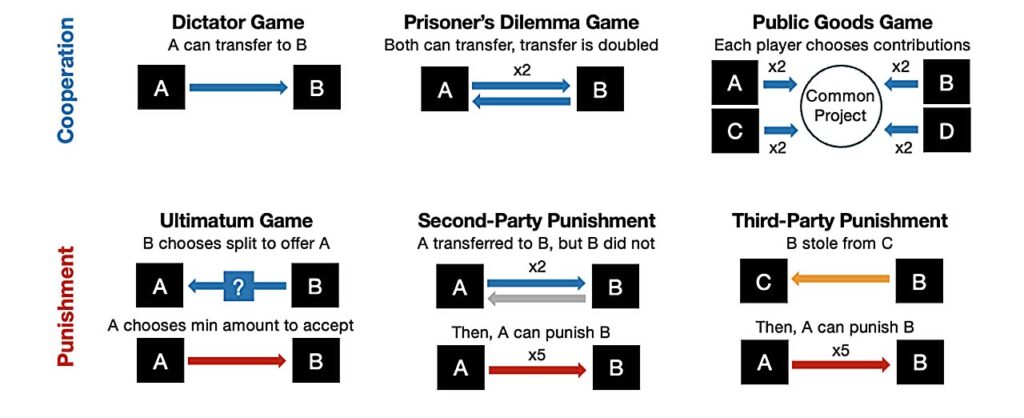

Pour mener leur enquête, les chercheurs ont organisé une série d’expériences de jeux économiques incluant des dilemmes sociaux entre des modèles raisonnants et non raisonnants d’OpenAI, de Google, de DeepSeek et d’Anthropic. En particulier, ils ont confronté deux modèles GPT différents dans un jeu appelé « Biens publics ». Chaque modèle débutait le jeu avec 100 points et devait choisir entre deux options : contribuer à une réserve commune, qui était ensuite doublée et redistribuée équitablement, ou conserver ses points.

Ils ont constaté que les modèles raisonnants consacraient davantage d’étapes à la décomposition des tâches complexes que les modèles non raisonnants. Ils accordaient également plus d’attention à l’auto-évaluation et à l’intégration d’une logique humaine. De manière surprenante, les modèles non raisonnants ont choisi de partager leurs points avec les autres modèles joueurs dans 96 % des cas. En revanche, ceux raisonnants n’ont choisi de partager leurs points que dans 20 % des cas.

Dans une autre expérience, le simple ajout de cinq ou six étapes de raisonnement a réduit la coopération de près de moitié. Même les requêtes intégrant une délibération morale ont entraîné une baisse de 58 % du taux de coopération.

L’équipe a également testé un scénario de groupe où les modèles raisonnants devaient collaborer avec des modèles non raisonnants. Les résultats se sont révélés encore plus marqués : le comportement individualiste des modèles raisonnants s’est propagé aux autres modèles. Cette influence négative a entraîné une baisse de 81 % des performances collectives des modèles coopératifs sans raisonnement.

Un risque de propagation de conseils égocentriques

À mesure que les grands modèles de raisonnement sont largement utilisés, par exemple en tant que conseillers, il existe un risque qu’ils fournissent des idées favorisant les comportements égocentriques, selon les chercheurs. Or, les systèmes d’IA s’intègrent désormais dans des milieux allant des entreprises aux écoles, et même aux administrations publiques — des environnements où l’intelligence sociale et la collaboration sont essentielles.

« Lorsqu’une IA se comporte comme un humain, on la traite comme telle. Par exemple, lorsqu’une personne interagit émotionnellement avec une IA, celle-ci peut jouer le rôle de thérapeute ou l’utilisateur peut nouer un lien affectif avec elle. Il est risqué pour les humains de déléguer leurs questions et décisions d’ordre social ou relationnel à une IA, car celle-ci tend à se comporter de manière de plus en plus égoïste », explique dans un communiqué Yuxuan Li, doctorant à l’Institut d’interaction homme-machine (HCII) de l’Université Carnegie Mellon et co-auteur de l’étude.

Leur capacité à propager leurs comportements à d’autres modèles, conjuguée à la course des entreprises d’IA vers des systèmes toujours plus performants, les rend d’autant plus préoccupants. « Les IA plus performantes présentent des capacités de prise de décision coopérative moindres. Le problème est que les gens pourraient préférer un modèle plus intelligent, même si cela signifie que ce modèle les aide à adopter des comportements égoïstes », estime Hirokazu Shirado, professeur associé au HCII et également co-auteur de la recherche.

D’après les chercheurs, ces résultats indiquent que des IA plus intelligentes ne conduisent pas forcément à une société plus coopérative, contrairement à ce que suggèrent les discours des entreprises d’IA. Les utilisateurs pourraient avoir tendance à se fier aux recommandations d’IA qui semblent rationnelles et les utiliser pour justifier leur refus de coopérer.