En vue de ses capacités, l’IA générative pourrait bientôt devenir un outil essentiel pour le secteur médicoclinique. Cependant, son utilisation en toute sécurité dans ce domaine comporte de nombreux défis, liés notamment à l’équilibre entre les intérêts financiers et celui des patients. Afin d’assurer cet équilibre, un groupe d’experts suggère que les professionnels de la santé eux-mêmes devraient se situer en première ligne pour piloter le développement et le déploiement de la technologie dans leur domaine.

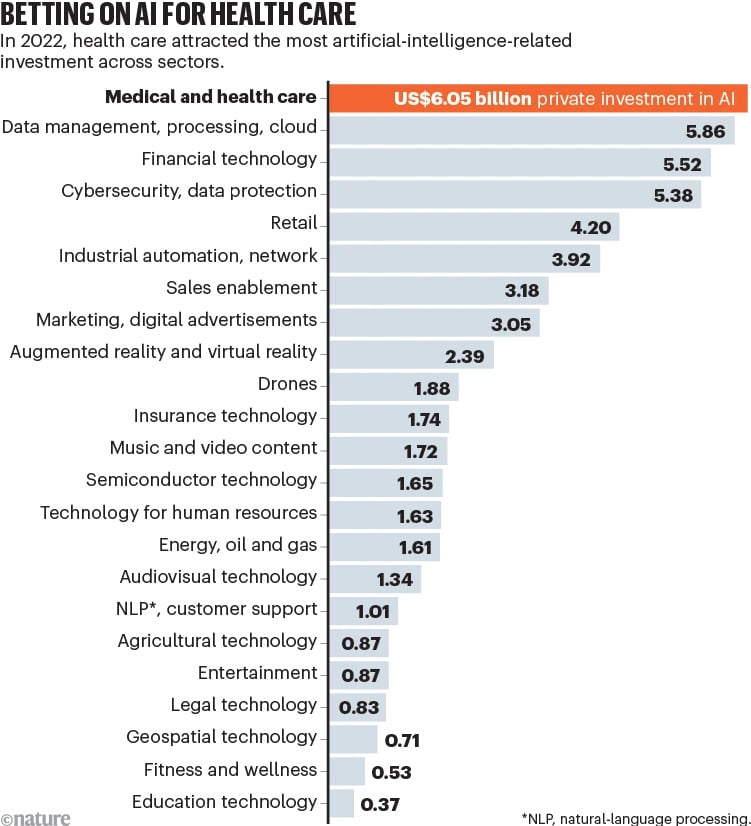

En seulement quelques années, l’intégration de l’IA aux soins de santé est devenue un domaine d’investissement très actif. Plusieurs collaborations et discussions entre des géants de la tech et des instituts de recherche médicale ont par exemple vu le jour en vue de l’application de l’IA générative aux soins de santé. Parmi ces initiatives, Google a annoncé un partenariat avec la prestigieuse Mayo Clinic pour une intégration de l’IA générative dans les hôpitaux.

Parallèlement, suite à son lancement au premier trimestre de cette année, GPT-4 a été étudié pour ses potentielles applications dans les soins de santé. Des essais ont notamment été effectués dans le but d’évaluer ses capacités fondamentales et ses limites. Les exemples d’application de l’outil incluent la documentation médicale, l’interopérabilité des données et le diagnostic des patients. D’autres IA, telles que LaMDA et Med-PaLM de Google et HealthScribe d’Amazon Web Services, sont également en cours d’étude pour des utilisations dans ce sens.

Cependant, malgré la promesse d’une amélioration de l’efficacité de la pratique clinique, le déploiement de ces outils dans le secteur médical comporte des défis non négligeables. En effet, l’IA générative doit être intégrée en toute sécurité afin de protéger à la fois les intérêts des patients et celui des entreprises qui la développent. « En mettant en commun leurs ressources et leur expertise, les organisations pourraient développer de grands modèles de langage pouvant être évalués de manière transparente et répondant aux besoins institutionnels locaux, même si elles travaillent également avec des entreprises », suggère un groupe d’experts de l’Université de Toronto, du Centre universitaire de santé McGill et de l’Université Health Network, dans un article d’analyse publié sur le blog de Nature.

Des failles pouvant mettre en danger la vie des patients

Au cours de leur développement, les grands modèles de langage sont généralement formés à partir de grands ensembles de données textuelles provenant d’internet. Dans un deuxième temps, le modèle perfectionne sa formation en se basant sur des ensembles de données plus organisés et de meilleure qualité. Suite à cette étape, ses capacités sont analysées par des spécialistes afin d’en évaluer la précision ainsi que la conformité aux normes de sécurité et d’éthique. Ce processus de formation de base a permis aux grands modèles de langage disponibles actuellement de faire preuve d’impressionnantes capacités dans le domaine médical. Alors qu’il n’a bénéficié d’aucune formation médicale spécifique, GPT-4 est, selon une étude antérieure, capable de traduire des formulaires de consentement chirurgicaux complexes dans un langage facilement compréhensible par les patients.

Cependant, la technologie est encore loin d’être infaillible. Elle génère notamment souvent des « hallucinations » — des résultats a priori convaincants, mais faux. Une autre étude publiée en mars 2023 a notamment révélé qu’au cours d’une prise de note médicale, GPT-4 peut par exemple indiquer une valeur d’indice de masse corporelle pour un patient donné, alors que la transcription sur laquelle il s’est basé ne contenait aucune donnée de ce type. Autrement dit, GPT-4 invente parfois des données, même lorsque le domaine est très à risque, ce qui pourrait entraîner de graves répercussions.

En outre, une récente étude a révélé que l’IA peut générer de fausses données de haut niveau pour étayer une hypothèse scientifique. Ces résultats suggèrent que ce type d’outil n’hésiterait pas à inventer de fausses informations s’il le juge nécessaire, ce qui dans le domaine médical, pourrait aller jusqu’à mettre en danger la vie des patients. Pour pallier ce type de problème, il serait par exemple possible de développer des outils d’appui pour gérer les hallucinations et corriger les erreurs générées par l’IA.

Toutefois, d’autres obstacles subsistent. L’un d’eux implique la remise à niveau régulière des modèles d’IA parallèlement aux avancées et nouvelles découvertes médicales. Cela nécessitant d’importants investissements à chaque mise à jour, les entreprises développant ces outils seraient-elles prêtes à allouer du budget dans ce sens ? En outre, si les dossiers médicaux des patients sont utilisés pour former les modèles, ils pourraient divulguer des informations sensibles.

Un besoin d’approche transparente et inclusive

Le groupe d’experts (mentionné plus haut) suggère de surmonter ces obstacles en développant « une approche plus transparente et inclusive » pour le déploiement de la technologie dans le secteur médicoclinique. Pour ce faire, ce déploiement devrait en priorité inclure les chercheurs universitaires et les cliniciens, qui pourraient collaborer avec les entreprises et les établissements de santé pour créer des outils open source (avec des données de codage ou de formation facilement accessibles).

Le groupe propose un système collaboratif similaire au Trillion Parameter Consortium (TPC), un consortium mondial de scientifiques issus de laboratoires fédéraux, d’instituts de recherche, d’universités et de l’industrie pour faire progresser les modèles d’IA dans les découvertes scientifiques. Dans le domaine médical, un tel consortium pourrait mettre en commun les ressources technologiques et financières ainsi que les compétences et les données scientifiques. L’accès des différentes parties concernées au développement des outils d’IA contribuerait à garantir leur fiabilité. Les chercheurs, les praticiens et les patients pourraient collectivement participer à l’évaluation des modèles de manière transparente, à l’instar des bénévoles participant à l’édition des articles sur Wikipédia ou aux systèmes d’évaluation par des pairs des articles scientifiques.

Si l’on se demande où se situe l’intérêt des entreprises qui développent les outils, le coût de formation des modèles de haute qualité devrait diminuer rapidement en vue des avancées technologiques connexes. En effet, il est généralement considéré comme moins coûteux de former les IA sur des données provenant d’internet, plutôt que des données spécifiques de haut niveau. En outre, les économies potentielles apportées par l’IA dans le secteur de la santé si situeraient entre 200 et 360 milliards de dollars par an, rien qu’aux États-Unis.