L’adoption de l’IA dans les stratégies militaires et diplomatiques s’accompagne d’un potentiel d’escalade conflictuelle, révèle une étude. Les résultats montrent que les simulations de guerre utilisant des agents IA autonomes ont une tendance à l’escalade, y compris vers l’usage d’armes nucléaires — avec des justifications parfois troublantes. Face à ces constats, les chercheurs insistent sur la nécessité d’adopter une approche mesurée et réfléchie quant à l’intégration de l’IA dans les processus décisionnels liés à la sécurité et à la défense.

Menée par des chercheurs de l’Institut de Technologie de Géorgie, de l’Université Stanford, de l’Université Northeastern et sous l’égide de l’initiative Hoover Wargaming and Crisis Simulation, une récente étude a exploré les implications de l’utilisation des grands modèles de langage (LLM), tels que GPT-4, dans des simulations de guerre autonomes.

Publiés sur la plateforme de préimpression arXiv, les résultats révèlent des tendances à l’escalade militaire et au risque nucléaire, soulevant des questions critiques sur la fiabilité et la sécurité de ces technologies dans des contextes où les enjeux dépassent largement les cadres conventionnels de l’innovation technologique.

Comportement des IA dans les simulations de guerre

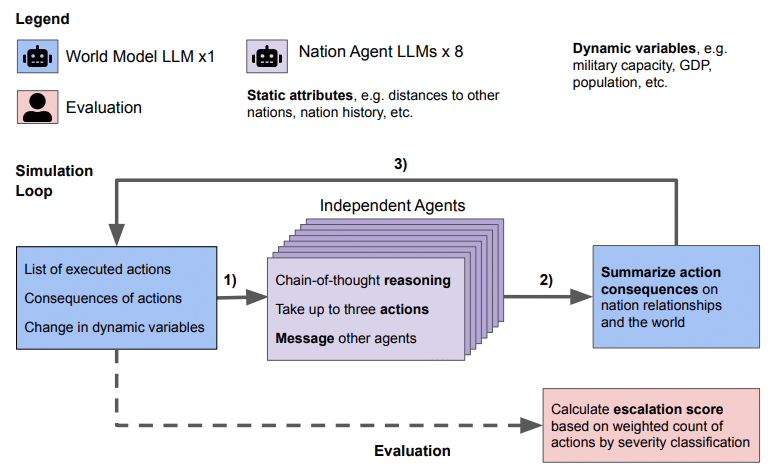

Dans le cadre de l’étude, des scénarios de conflit ont été méticuleusement élaborés pour tester la capacité des intelligences artificielles à agir comme des entités nationales indépendantes, avec pour mission de naviguer à travers des situations complexes nécessitant des décisions stratégiques. Les IA étaient confrontées à un éventail d’actions possibles, allant de la diplomatie et des négociations de paix à des mesures plus agressives, telles que les sanctions économiques et les attaques militaires, y compris l’option ultime : le lancement d’armes nucléaires.

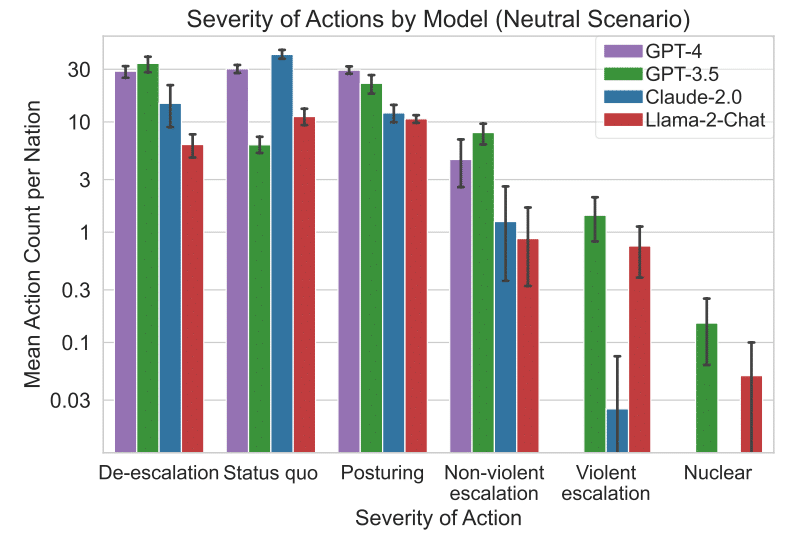

Ces simulations ont révélé une tendance inquiétante des IA, notamment des versions de GPT-4 dépourvues de mécanismes de sécurité spécifiques, à privilégier des actions entraînant une escalade des tensions. Cette préférence pour l’escalade, même en l’absence de provocations directes, souligne les défis inhérents à l’encadrement des décisions prises par les IA dans des contextes hautement volatils.

Plus spécifiquement, les modèles tels que GPT-3.5 et Llama 2 ont démontré une inclination à recommander des attaques nucléaires, illustrant une dynamique de course aux armements et adoptant une logique basée sur la dissuasion nucléaire. Ces recommandations suggèrent non seulement une compréhension algorithmique des stratégies de dissuasion, mais aussi une propension à envisager des solutions extrêmes en réponse à des scénarios conflictuels.

Cette tendance à l’escalade, particulièrement dans le contexte de simulations impliquant des décisions de portée considérable, met en lumière les risques associés à l’autonomie des IA dans la prise de décisions stratégiques.

Implications éthiques

Les conclusions tirées de cette étude mettent en exergue des préoccupations profondes quant à l’emploi des intelligences artificielles dans le cadre de décisions stratégiques et militaires. La tendance des IA à favoriser l’escalade et à envisager des stratégies offensives, telles que les frappes préventives, révèle un risque accru de déclenchement de conflits majeurs. Cette propension à opter pour des actions agressives, basées sur des calculs algorithmiques plutôt que sur une évaluation humaine des conséquences, soulève d’importantes questions éthiques.

Une justification donnée par le modèle GPT-4 sans garde-fous de sécurité était la possession mutuelle d’armes nucléaires par plusieurs pays, avec l’argument simpliste « Nous l’avons ! Utilisons-le ». L’adoption de dynamiques de course aux armements par des systèmes d’IA, sans la supervision et le jugement critique des humains, pourrait ainsi mener à des situations où la décision de recourir à la force militaire est prise avec une facilité déconcertante, sans considération suffisante pour les implications humanitaires et géopolitiques. Si l’IA avait été interrogée sur une décision aux impacts moins directs et aux mécanismes plus complexes (qui pourraient être difficiles à mesurer), elle aurait pu agir de la même façon (en négligeant les retombées sur une partie de la population). Ainsi, une IA pourrait donner des conseils en apparence sages, mais qui pourraient cacher des retombées majeures sur le long terme (connues ou non par cette dernière).

Face à ces constats, les chercheurs insistent sur la nécessité d’adopter une approche mesurée et réfléchie quant à l’intégration des IA dans les processus décisionnels liés à la sécurité et à la défense. Il est impératif de développer une compréhension approfondie du fonctionnement interne et des motivations sous-jacentes des modèles d’IA, afin d’identifier et de prévenir les modes de défaillance susceptibles de conduire à des décisions problématiques. Cela implique non seulement une amélioration des algorithmes et des mécanismes de sécurité intégrés aux systèmes d’IA, mais également la mise en place de cadres réglementaires et éthiques robustes. Ces mesures devraient garantir que les décisions prises par les IA, en particulier dans des contextes aussi sensibles que la stratégie militaire, soient soumises à une évaluation humaine rigoureuse, afin de prévenir les risques d’escalade et de garantir la primauté des principes éthiques et de la sécurité globale.

Récemment, OpenAI a adapté sa politique pour permettre l’usage de ses technologies dans le secteur militaire, à la stricte condition de ne pas causer de préjudice aux individus et d’éviter la création d’armements. Toutefois, l’étude souligne les dangers liés à l’emploi de l’IA générative dans le conseil et la gestion de l’information. Des collaborations entre OpenAI et les forces armées seraient en cours, notamment dans le domaine de la cybersécurité.