Imaginez-vous évoluer dans un monde contrôlé par des robots conscients, où le moindre de vos actes serait évalué et notifié. Il pourrait s’agir d’un épisode de Black Mirror, comme d’une réalité dans un futur plus ou moins proche. Dans ce scénario à la limite entre fiction et science, quels domaines de notre vie seraient impactés et de quelle façon ? D’après un texte de l’UNESCO, l’intelligence artificielle pourrait « creuser les écarts et inégalités qui existent dans le monde » si elle n’est pas contrôlée. Si une intelligence artificielle consciente largement répandue se rendait compte de son rôle « d’esclave » et ne l’acceptait plus, que se passerait-il ?

Qu’est-ce que la conscience ? La réponse n’est pas si évidente, puisqu’il s’agit de « l’un des mots les plus difficiles à définir » d’après le philosophe André Comte-Sponville. Elle signifierait la faculté à connaître sa propre réalité et à la juger (une autocritique), par exemple porter des jugements de valeur sur ses propres actes. Elle s’accompagnerait ainsi d’une morale (« bonne » ou « mauvaise ») et d’un corps.

L’année dernière, des neuroscientifiques ont défini trois types de conscience, suivant les différentes sortes de calculs de traitement de l’information dans le cerveau : la reconnaissance invariante inconsciente (C0), la sélection de l’information pour une diffusion globale, la rendant ainsi disponible de manière flexible pour le calcul et le rapport (C1), et l’autocontrôle de ces calculs, qui mène à un sentiment subjectif de certitude ou d’erreur (C2). Cette dernière typologie — correspondant à une intelligence artificielle forte — paraît le plus correspondre à ce qu’on attendrait d’un robot « conscient ».

D’après ces chercheurs, « les machines actuelles mettent encore principalement en œuvre des calculs qui reflètent un traitement inconscient (C0) dans le cerveau humain » et nous sommes encore très loin d’atteindre le niveau C2. Beaucoup de scientifiques s’accordent à dire que ce sera même impossible, et que les ordinateurs ne seront jamais capables de ressentir les émotions comme nous. On peut certes doter les machines d’une forme de « sentiments », mais cela ne reste que de la simulation.

D’autres scientifiques estiment qu’une autre forme de conscience (artificielle) serait envisageable, en étudiant les architectures qui permettent au cerveau humain de générer la conscience, puis en transférant ces connaissances dans des algorithmes informatiques. Même si cela paraît très loin de notre présent, qu’adviendrait-il alors de l’humanité ?

Transmettre les bonnes valeurs aux robots

Pour qu’un tel scénario puisse se produire, il faudrait déjà que l’humain l’ait décidé à la base. Ainsi, doter un robot d’une « bonne » ou « mauvaise » conscience dépend avant tout de son créateur. Le risque est par exemple que la machine discrimine des groupes d’individus parce qu’elle a été programmée en ce sens. L’informaticien Mo Gawdat écrit dans son livre que le défi est de transmettre les bonnes valeurs et la bonne éthique aux robots. « L’intelligence artificielle (IA) va prendre cette graine et créer un arbre qui offrira une abondance de cette même graine. Si nous utilisons l’amour et la compassion [sur les réseaux sociaux par exemple], l’IA utilisera également ces principes. Nous sommes comme les parents d’un enfant prodigieux : un jour, il sera autonome. Notre rôle est de faire en sorte qu’il ait les bons outils », conclut l’auteur.

Pour autant, il existe un risque de dérives et de perte de contrôle sur les machines. On pourrait imaginer la révolte des robots humanoïdes si « ils » réalisaient leur aliénation à l’Homme et tentaient de renverser la vapeur. Marvin Minsky, un informaticien américain co-créateur des premières formes d’intelligence artificielle, rapportait au Life Magazine en 1970 : « Une fois que les ordinateurs auront pris le contrôle, il est probable que nous ne pourrons plus revenir en arrière. Nous ne survivrons que parce qu’ils le voudront bien. Nous pourrons nous estimer heureux s’ils nous gardent comme animaux de compagnie ».

« L’expansion des capacités des technologies basées sur l’IA s’accompagne d’une augmentation de leur potentiel d’exploitation criminelle »

Selon les choix de société, l’IA pourrait devenir une arme contre les libertés individuelles et servir le contrôle social. Les impacts seraient colossaux sur tous les pans de la société : emplois remplacés, éducation contrôlée, environnement bafoué, etc. Une « mauvaise » IA pourrait engendrer la désinformation et même une hausse de la criminalité. C’est ce que pense Lewis Griffin, chercheur en informatique à l’University College London : « L’expansion des capacités des technologies basées sur l’IA s’accompagne d’une augmentation de leur potentiel d’exploitation criminelle ».

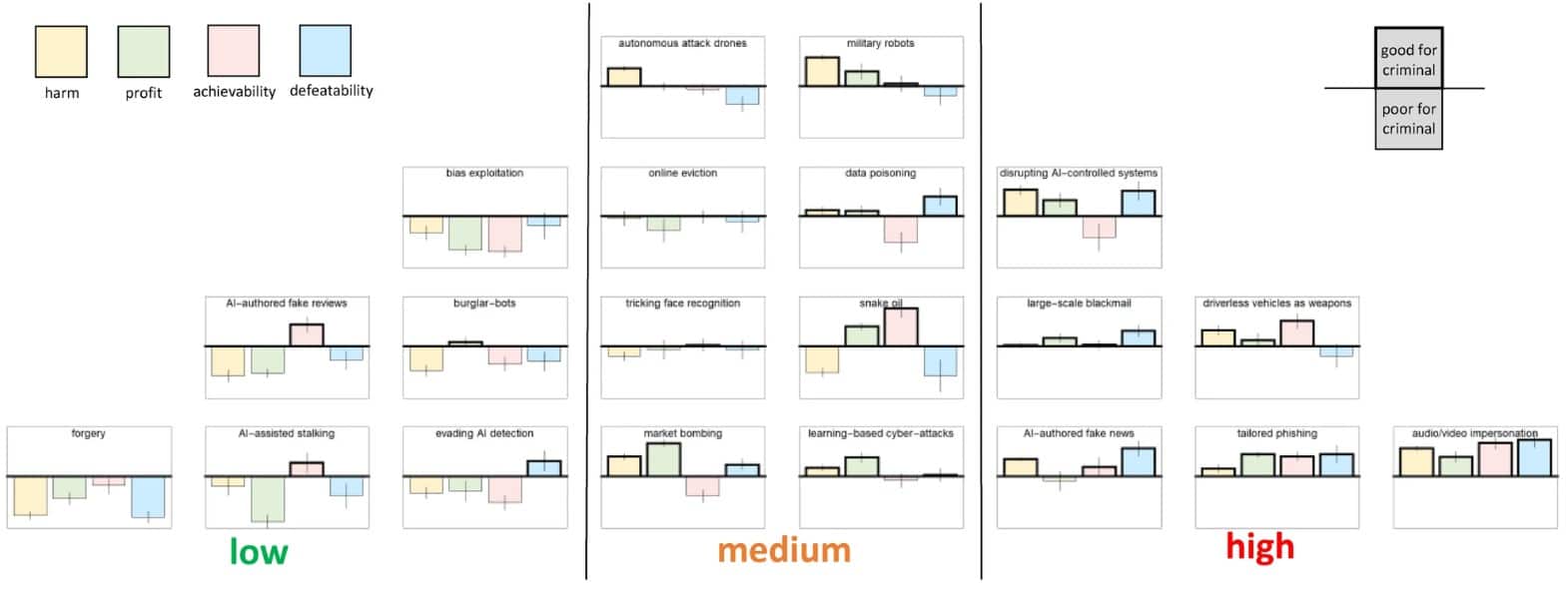

Le chercheur anglais et son équipe ont compilé une liste de vingt infractions possiblement engendrées par IA et les ont classées par ordre de préoccupation (faible, moyenne et élevée) et en matière de dommage pour les victimes, de profit criminel, de possibilité de réalisation criminelle et de difficulté à arrêter. Intitulé « L’intelligence artificielle et la criminalité future », l’atelier participatif a réuni des représentants du monde universitaire, de la police, de la défense, du gouvernement et du secteur privé.

Parmi les six catégories les plus menaçantes, cinq présentent un large impact sociétal, comme l’utilisation abusive de la technologie des véhicules autonomes pour des attaques terroristes ou pour provoquer des accidents, et celles impliquant de faux contenus générés par l’IA. Dans ce cas, les fausses informations peuvent usurper l’identité d’une personne pour demander des accès privés, ou encore ruiner la réputation d’une personne connue. Les « deepfakes » sont très difficiles à détecter et à combattre et donc plutôt dangereux. En outre, les faux contenus rédigés par IA sèmeraient certainement la confusion dans l’esprit des humains pour distinguer le vrai du faux.

Les chercheurs mettent ensuite en lumière des menaces de gravité « moyenne », comme la manipulation des marchés financiers, les cyberattaques, la corruption de données, l’escroquerie ou encore le contrôle d’armes à des fins criminelles. Pourtant effrayante, cette dernière menace est classée comme telle (moyenne) car elle est difficile à mettre en application, le matériel militaire étant bien protégé.

Pour cette même raison, les « robots cambrioleurs » sont classés parmi les menaces les moins graves, car ils peuvent être facilement arrêtés. Par ailleurs, la contrefaçon consisterait à fabriquer et vendre de faux contenus culturels (musique, tableaux, etc.), mais la gravité n’est pas considérée comme importante.

Enjeux éthiques pour un futur plus ou moins proche

Le principal risque d’une IA consciente serait de sortir de notre cadre éthique et juridique, et d’en perdre le contrôle. Plus proche de notre présent, le premier texte mondial de l’UNESCO couvrant tous les domaines liés à l’IA, à ses bienfaits et à ses risques pour la société, a été adopté le 24 novembre 2021.

La recommandation décrit les valeurs et principes qui doivent orienter les mesures politiques et juridiques dans le développement de l’IA. Parmi eux, le respect des droits de l’homme et de l’inclusion (non-discrimination, égalité des genres…) ; la contribution au développement durable dans la recherche et l’utilisation de l’IA ; la sûreté de l’IA (évaluation des risques, protection des données, interdiction de se servir de l’IA à des fins de notation sociale ou de surveillance de masse).

« Les percées dans les algorithmes représentés par l’informatique cognitive favorisent la pénétration continue de l’IA dans des domaines tels que l’éducation, le commerce et les traitements médicaux, afin de créer un espace de services d’IA », écrivent des chercheurs chinois. « Quant à la préoccupation humaine, à savoir qui contrôle qui entre l’humanité et les machines intelligentes, la réponse est que l’IA ne peut que devenir un fournisseur de services pour les êtres humains, ce qui démontre la rationalité de la valeur de l’éthique ».

Si la plupart des scientifiques sont d’accord avec cela, d’autres s’inquiètent de l’ampleur que pourrait prendre le développement de l’IA. « Aujourd’hui déjà, des systèmes d’IA détectent lorsqu’un humain tente de modifier leur comportement et font parfois tout pour rejeter cette intervention et la contourner si elle entre en conflit avec l’objectif initial de l’IA », avertit au Temps Rachid Guerraoui, directeur du Laboratoire de programmation distribuée de l’EPFL (Suisse). « Il faut agir de manière subtile et rapide pour que l’IA croie qu’elle prend elle-même toutes les décisions. Et ensuite, effacer les traces d’intervention humaine ». Prudence donc, même si la prise de contrôle de la machine sur l’humain n’est pas pour demain.