L’intelligence artificielle a fait d’énormes progrès ces dernières années, avec des applications dans tous les domaines, des voitures autonomes les plus avancées aux algorithmes de diagnostic pour détecter le cancer avec une fiabilité jusqu’ici jamais atteinte, en passant par la résolution d’équations mathématiques complexes. Récemment, le site Protocol a révélé un brevet de Microsoft un peu déconcertant : l’entreprise semble prévoir la conception de chatbots (robots de chat) capables d’imiter numériquement une personne cible.

Le brevet, déposé la semaine dernière, est intitulé « Creating a Conversational Chatbot of a Specific Person » (« Créer un robot de chat d’une personne spécifique »). « Par certains biais, des données sociales (par exemple des images, des données vocales, des messages sur les médias sociaux, des messages électroniques, des lettres écrites, etc.) sur la personne spécifique peuvent être accessibles. Les données sociales peuvent ainsi être utilisées pour créer ou modifier un ‘index’ spécial sur le thème de la personnalité de la personne ciblée », peut-on lire dans l’abrégé du brevet.

Pourquoi un tel brevet ? Que prévoient-ils exactement ? La question ne trouvera pas de réponse précise de sitôt, mais il est possible d’imaginer ce qu’ils mijotent, et ce que d’autres développeurs pourraient en faire. À en croire ces lignes, Microsoft espère peut-être avec cette technologie (dans un premier temps) améliorer ses robots de chat de service client, ainsi que probablement l’assistance future en matière d’IA pour son système Cortana et d’autres assistants personnels intelligents. Mais le document du brevet révèle des détails intrigants…

Des applications encore floues

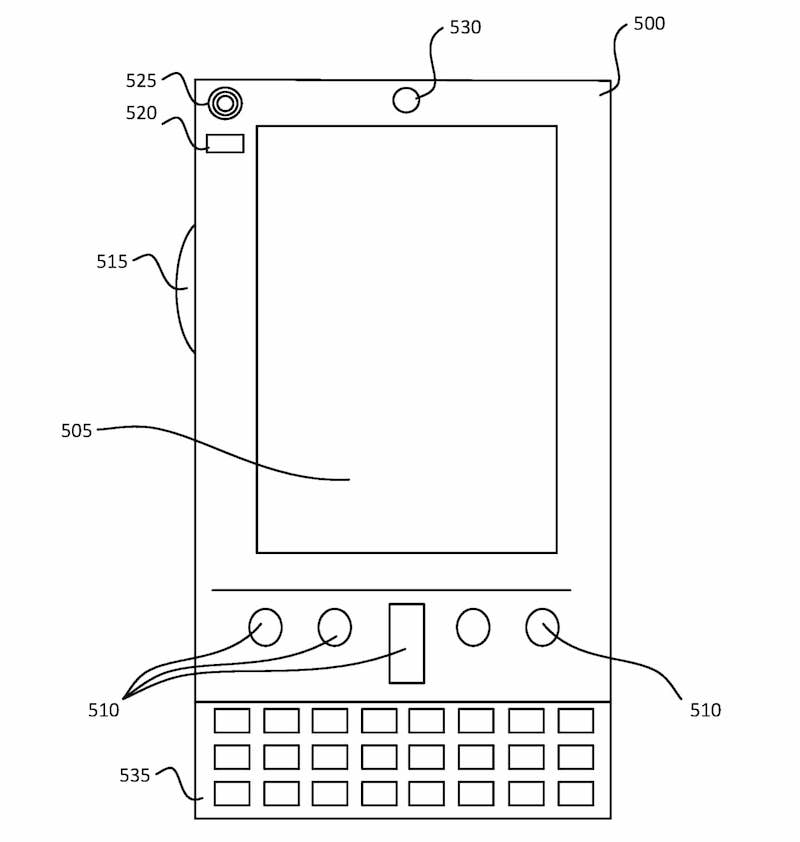

Pour reprendre la phrase citée plus haut : « […] des messages sur les médias sociaux, des messages électroniques, des lettres écrites, etc.) […] »… pourquoi vouloir pouvoir se baser sur des lettres ? Qui, de nos jours, utilise encore ce format pour correspondre, si ce n’est pour de l’administratif ? Comme nous l’avons déjà mentionné, peut-être que cela servira donc dans un but d’amélioration du service client de Microsoft, mais sinon ? Pourquoi ce dispositif en forme de Tamagotchi géant si le but est d’améliorer un assistant virtuel ?

S’agira-t-il de stocker des « personnalités virtuelles » à l’intérieur ? Selon les détails du brevet, il s’agirait bien uniquement d’une interface permettant de se connecter à plusieurs dispositifs afin de nourrir l’algorithme d’apprentissage automatique, qui permettra ensuite de « modeler » l’assistant virtuel personnalisé. Mais personnalisé à quel point ? « Pour certains aspects, la conversation sur la personnalité d’une personne spécifique peut inclure la détermination et/ou l’utilisation des attributs conversationnels de la personne spécifique, tels que le style, la diction, le ton, la voix, l’intention, la longueur et la complexité du dialogue, le sujet et la cohérence. La conversation basée sur la personnalité d’une personne spécifique peut en outre inclure la détermination et/ou l’utilisation d’attributs comportementaux (intérêts des utilisateurs, opinions, etc.) et des informations démographiques », peut-on lire plus loin dans le résumé du brevet, pour ne citer que l’un des nombreux détails évoqués. Conclusion : avec une telle technologie, Microsoft pourrait bien aller au-delà de la simple amélioration des robots de chat actuels… Reste à déterminer à quel point et pourquoi.

Risque de cyber-fraude et de vol d’identité

Mais qu’en serait-il si un tel dispositif tombait entre les mains de développeurs moins éthiques ou mal intentionnés ? Les implications de ce type de mimétisme de personnalité hyperspécifique et numérisé pourraient dans ce cas être aussi variées qu’inquiétantes.

Si Microsoft a probablement suffisamment de jugeote (on l’espère) pour ne pas utiliser cette technologie à des fins non éthiques, comme faire revivre numériquement des personnes décédées ou permettre de copier la « personnalité numérique » de toute autre personne ciblée, on ne peut pas en dire autant des autres entreprises et programmeurs qui en feraient usage. L’idée d’une IA conversationnelle basée sur un concentré de tweets, de messages Facebook et de SMS, éventuellement couplée à une imitation vocale (au passage, déjà possible) pourrait ouvrir une toute nouvelle ère de cyber-fraude et de vol d’identité.

Il y a également le sujet épineux concernant le droit à la vie privée d’une personne après sa mort. Qu’en est-il de la propriété des droits sur les données numériques ? L’assistant numérique que vous auriez modelé en 2024 et que vous avez acheté sur un coup de tête vous appartient-il vraiment ? Tant de questions dont les réponses sont encore floues, étant donné la jeunesse de ces technologies. Il sera probablement nécessaire et avisé de déterminer des cadres d’utilisation précis pour ces technologies.