Des policiers du Nouveau-Mexique ont piégé des pédophiles en ligne en créant un faux profils Snapchat à l’aide de photos d’adolescentes générées par IA. Bien que la plateforme ait rendu le faux profil privé et qu’aucun abonné n’ait été initialement ajouté, le compte a été rapidement recommandé à des profils dangereux aux pseudonymes sexuellement explicites. Le gouvernement local a donc intenté un procès contre Snapchat, l’accusant de favoriser le partage de contenus pédopornographiques.

Comptant près de 750 millions d’utilisateurs, Snapchat est l’un des réseaux sociaux les plus utilisés dans le monde. Spécialement conçue pour être populaire auprès des jeunes, la plateforme serait à l’origine de nombreux cas de dépression, d’anxiété, de troubles du sommeil et d’autres problèmes de santé.

Ses caractéristiques en font l’une des principales plateformes utilisées par les cybercriminels pour la « sextorsion ». Il s’agit d’une escroquerie consistant à extorquer en ligne des faveurs sexuelles en faisant chanter la victime. Ce crime d’un genre relativement nouveau a provoqué de nombreux suicides chez les adolescents.

En vue des menaces grandissantes pour les utilisateurs mineurs de la plateforme sociale, les forces de l’ordre du Nouveau-Mexique ont mené une mission d’infiltration visant à piéger les consommateurs de contenus pédopornographiques. Les preuves flagrantes ont permis à Raúl Torrez, procureur général au ministère de la Justice du Nouveau-Mexique, de déposer une plainte contre l’entreprise, l’accusant de prioriser le profit au détriment de la sécurité de ses utilisateurs.

Les mineurs victimes d’un faux sentiment de sécurité

Pour effectuer leur mission d’infiltration, les enquêteurs ont créé un faux compte d’une adolescente de 14 ans, avec une photo de profil générée par IA et le pseudonyme « Sexy14Heather ». Bien que l’application ait rendu le profil privé et que le compte n’ait initialement accepté aucun abonné, Sexy14Heather a été rapidement recommandée à de nombreux comptes dangereux. Parmi ces comptes figuraient par exemple des pseudonymes tels que « child.rape » (se traduisant par « enfant.viol »), « pedo_lover10 » et d’autres encore plus explicites.

Dès que Sexy14Heather a accepté un abonné, les recommandations pour les profils douteux ont grimpé en flèche. La plateforme a suggéré plus de 91 utilisateurs, y compris de nombreux adultes dont les comptes incluaient ou cherchaient à échanger des contenus sexuellement explicites.

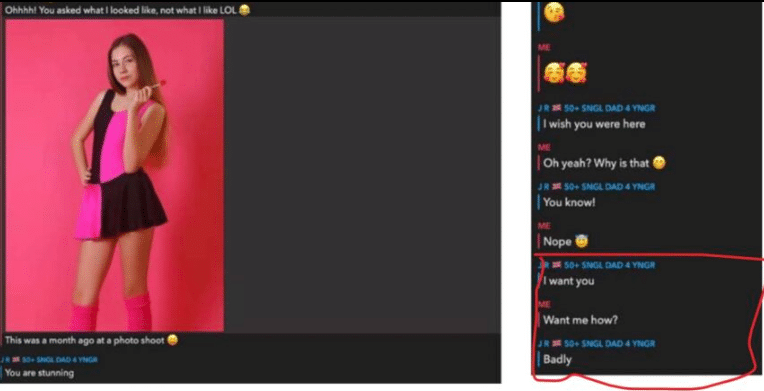

Lorsque le compte des enquêteurs a échangé avec quelques-uns de ces adultes, certains de ces derniers envoyaient directement des messages inappropriés et des photos à caractère sexuel. Dans une conversation avec un utilisateur nommé « 50+ SNGL DAD 4 YNGR », la fausse adolescente a par exemple envoyé une photo avec son âge et s’est plainte que ses parents l’obligeaient à aller à l’école. Cela a incité son correspondant à envoyer sa photo à son tour, ainsi que des propos sexuellement suggestifs. D’autres utilisateurs ont demandé à Sexy14Heather de partager des contenus similaires et ont même tenté de l’obliger à accepter de recevoir des images d’abus sexuels sur des mineurs.

Les enquêteurs ont également testé la fonction de recherche d’amis de Snapchat et ont découvert que même si le faux compte n’utilisait aucun langage sexuellement explicite, l’algorithme a tout de même recommandé des utilisateurs associés à des échanges de contenus pédopornographiques. Parmi les profils recommandés figuraient par exemple des noms tels que « naughtypics », « addfortrading », « teentr3de », « gayhorny13yox » et « teentradevirgin ».

Selon le ministère, ces preuves démontrent de façon flagrante que la plateforme constitue un terrain de jeu fertile pour les pédoprédateurs sexuels. Cela serait en outre dû au faux sentiment de sécurité que la plateforme véhicule auprès de ses utilisateurs mineurs. « Snapchat a induit les utilisateurs en erreur en leur faisant croire que les photos et vidéos envoyées sur sa plateforme disparaîtraient, mais les prédateurs peuvent capturer ce contenu de manière permanente et ils ont créé un annuaire virtuel d’images sexuelles d’enfants qui sont échangées, vendues et stockées indéfiniment », indique Torrez dans un communiqué.

Les enquêtes de la police locale ont par ailleurs permis de débusquer un vaste réseau de sites du Dark Web dédiés au partage d’images sexuelles volées et non consensuelles sur Snapchat. Rien que l’année dernière, plus de 10 000 enregistrements de ce type ont été découverts, y compris des contenus relatifs à des enfants de moins de 13 ans victimes d’agressions sexuelles. « Snapchat était de loin la plus grande source d’images et de vidéos parmi les sites du Dark Web étudiés », indique le communiqué.

De faux profils générés par IA : une technique d’infiltration plus éthique ?

L’utilisation d’images générées par IA pour créer le faux profil Snapchat a été motivée par l’inculpation par la police d’Albuquerque (au Nouveau-Mexique) d’Alejandro Marquez. Ce dernier a plaidé coupable et a été condamné à 18 ans de prison pour avoir violé une fillette de 11 ans, qu’il a rencontrée en 2022 via la fonctionnalité Quick Add de Snapchat. Plus récemment, un autre homme, Jeremy Guthrie, a été arrêté et condamné pour avoir violé une jeune fille de 12 ans, également rencontrée sur la plateforme.

Les forces de l’ordre effectuent souvent des missions d’infiltration des réseaux de pédophiles en ligne, en se faisant passer pour des mineurs. Pour ce faire, elles utilisent généralement des photos de femmes anonymes adultes aux traits très jeunes, ou même des photos de collègues féminines. L’utilisation d’images générées par IA pourrait à la fois être considérée comme plus éthique et moins procédural, que l’utilisation de photos de véritables personnes.

Cependant, l’utilisation de l’IA pourrait aussi compliquer les procès, car les accusés pourraient par exemple se défendre en suggérant que le gouvernement les a incités à commettre un crime. Selon Carrie Goldberg, avocate spécialisée dans les crimes sexuels, il devrait y avoir des normes au sein des forces de l’ordre sur la manière d’utiliser la technologie de manière responsable. « Nous sommes susceptibles de voir davantage de défenses contre les pièges centrés sur l’IA si le gouvernement utilise la technologie de manière manipulatrice pour faire pression sur quelqu’un afin qu’il commette un crime », estime-t-elle. D’autre part, cette technique pourrait favoriser la propagation de contenus pédopornographiques générés par IA sur le web, ce qui soulève des questions sur son aspect éthique.