Des chercheurs ont conçu un outil basé sur l’apprentissage automatique pour détecter les articles scientifiques générés par ChatGPT. Surpassant d’autres détecteurs connus, cet outil est particulièrement efficace pour analyser les textes dans le domaine de la chimie. Toutefois, après avoir développé ce premier modèle, les chercheurs ont constaté qu’il serait relativement facile de concevoir des outils de détection dédiés à d’autres domaines.

Avant l’essor de l’IA, les accusations concernant les articles scientifiques portaient souvent sur le plagiat. Désormais, alors que la technologie s’est à peine démocratisée, le débat semble se déplacer vers la question des contenus produits par l’IA.

Particulièrement dans le milieu académique, les chercheurs et étudiants qui soumettent des travaux générés par l’IA violent les principes de l’originalité et du travail personnel. C’est pour cela qu’une équipe de scientifiques de l’Université du Kansas aux États-Unis, dirigée par Bruyère Desaire, a développé un logiciel permettant de détecter avec une grande fiabilité les contenus générés par ChatGPT.

L’outil est basé sur l’apprentissage automatique et est particulièrement efficace dans l’analyse d’articles scientifiques, notamment du domaine de la chimie. Pour procéder, le détecteur examine 20 caractéristiques différentes du style d’écriture, y compris la variation de la longueur des phrases, la fréquence de certains mots et les signes de ponctuation. L’étude est détaillée dans la revue Cell Reports Physical Science.

Jusqu’à 100% de fiabilité

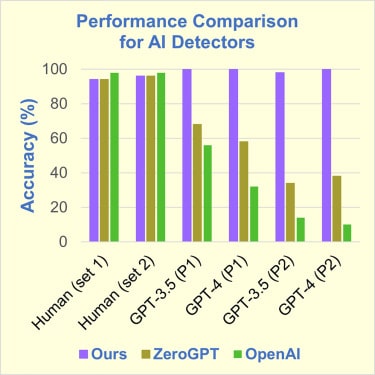

Pour entraîner le détecteur, les chercheurs ont utilisé 100 introductions d’articles issues de dix revues différentes de l’American Chemical Society (ACS). Ces échantillons de textes ont servi d’exemples de contenus rédigés par des humains. Ensuite, ils ont demandé à ChatGPT-3.5 de créer 200 introductions imitant le style d’écriture des revues de l’ACS. 100 de ces textes ont été générés en ayant inséré uniquement des titres d’articles dans les prompts. Les 100 restants ont été produits en intégrant également les résumés des articles.

Durant les essais, lorsque le détecteur a été utilisé pour identifier les introductions générées par ChatGPT-3.5 à partir des titres d’articles, il a atteint une fiabilité de 100%. Pour les introductions que ChatGPT a générées en utilisant les résumés comme point de départ, la fiabilité du détecteur était de 98%. Le détecteur aurait également bien fonctionné avec les textes générés par ChatGPT-4.

L’équipe a également comparé l’outil avec deux autres détecteurs. Le premier, appelé ZeroGPT, a montré des performances bien inférieures, avec une fiabilité qui variait entre 35% et 65%, selon la version de ChatGPT. Le deuxième outil est celui qui a été développé par OpenAI (l’entreprise qui a conçu ChatGPT), et a montré une fiabilité encore inférieure, située entre 10% et 55%.

Un détecteur spécialisé dans les articles scientifiques

Lors des tests, il a été démontré que le système était particulièrement efficace pour analyser des articles de revues scientifiques, et précisément de chimie. Selon l’un des chercheurs, il serait préférable de développer des détecteurs spécialisés dans des domaines spécifiques, plutôt que des outils « universels ». Cela optimiserait la précision, car ils seraient entraînés à reconnaître les styles d’écriture propres ces dits domaines.

Sans compter qu’en démontrant l’efficacité déjà acquise de son détecteur, Desaire et son équipe sont sur la bonne voie. D’après eux, une fois qu’une méthode de détection efficace sera mise au point pour un thème donné, il suffira de l’appliquer à d’autres domaines.