En comparant les résultats de la recherche internet standard avec la recherche par IA, des chercheurs ont mis en lumière des différences fondamentales dans les résultats. Si les outils d’IA brassent un ensemble de données plus vaste, issu de sites web plus diversifiés, les sources mobilisées ne figurent généralement pas parmi celles classées comme les plus pertinentes dans les résultats de recherche traditionnels. Leurs réponses auraient ainsi tendance à être moins fiables et moins cohérentes.

Bien que la recherche internet traditionnelle ait beaucoup évolué au cours des dernières décennies, son mode de fonctionnement de base est resté globalement inchangé. En réponse à une requête ou à un mot-clé, les moteurs de recherche comme Google, Bing ou DuckDuckGo fournissent des résultats sous la forme d’une liste d’une dizaine de sites web classés selon divers critères : pertinence, notoriété ou encore correspondance avec le profil de l’utilisateur.

D’importants travaux ont été menés pour affiner ces résultats en fonction des besoins des internautes. Mais avec l’essor de l’IA générative, la recherche en ligne s’oriente désormais vers une interaction continue avec des chatbots d’IA, fournissant les résultats sous forme de conversations plutôt que de listes de liens.

Les moteurs de recherche populaires comme Google intègrent désormais des outils d’IA capables de produire des réponses uniques, présentées en un ou plusieurs paragraphes et accompagnées de quelques liens sources. Il s’agit en principe de synthèses fondées sur les sites jugés les plus pertinents pour la requête.

Cela pose une question importante : les outils d’IA ont-ils réellement amélioré la recherche sur internet ? Pour y répondre, des chercheurs de l’Université de la Ruhr à Bochum et de l’Institut Max Planck pour les Systèmes logiciels ont comparé la recherche traditionnelle à la recherche par IA, afin d’en identifier les effets sur la qualité des résultats.

Au-delà du simple format de restitution, la recherche par IA se distingue de la recherche traditionnelle par sa couverture plus large. Les moteurs classiques affichent par défaut des extraits des dix premiers sites web les mieux référencés ou jugés les plus pertinents, contraignant les utilisateurs à naviguer manuellement pour explorer d’autres sources.

Les synthèses générées par les outils d’IA, en revanche, peuvent intégrer le contenu de plus de dix sites. Par ailleurs, la recherche traditionnelle repose exclusivement sur des sources externes, tandis que l’IA combine des informations extraites du web avec des connaissances internes issues de son apprentissage.

L’enquête visait à déterminer dans quelle mesure les outils d’IA exploitent leur capacité à accéder à un plus grand nombre de sources, et dans quelle proportion ils s’appuient sur des connaissances externes par rapport à leurs connaissances internes. L’étude analyse également si cette diversité d’origine améliore la précision et la variété des réponses par rapport aux moteurs de recherche standards.

Des réponses plus larges, mais pas toujours plus fiables

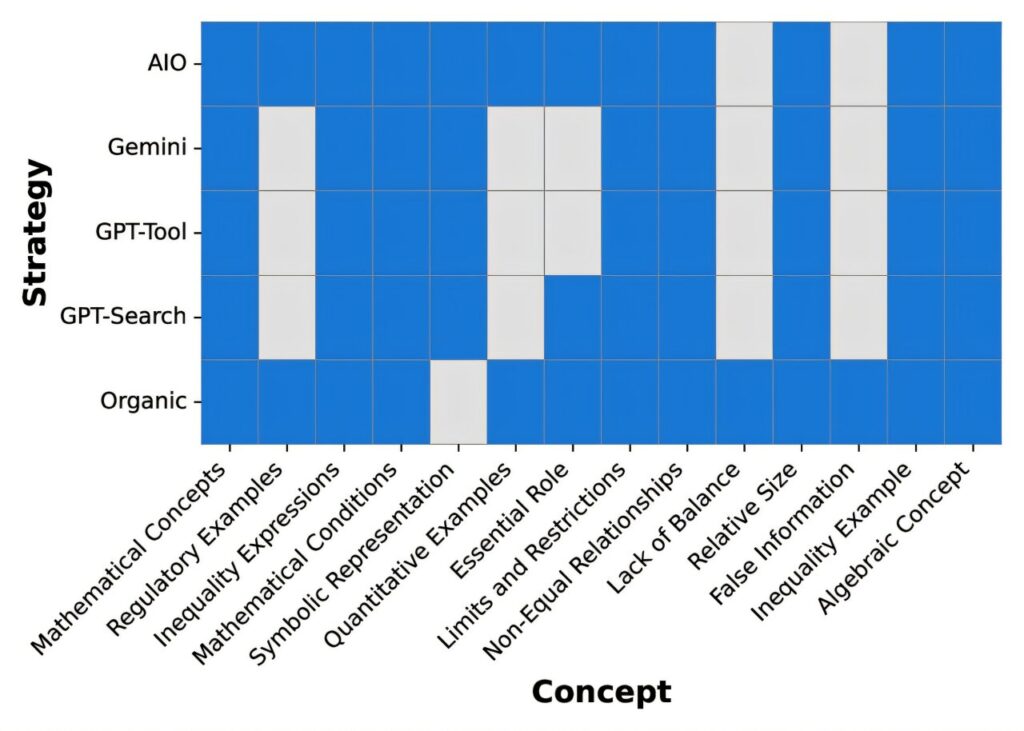

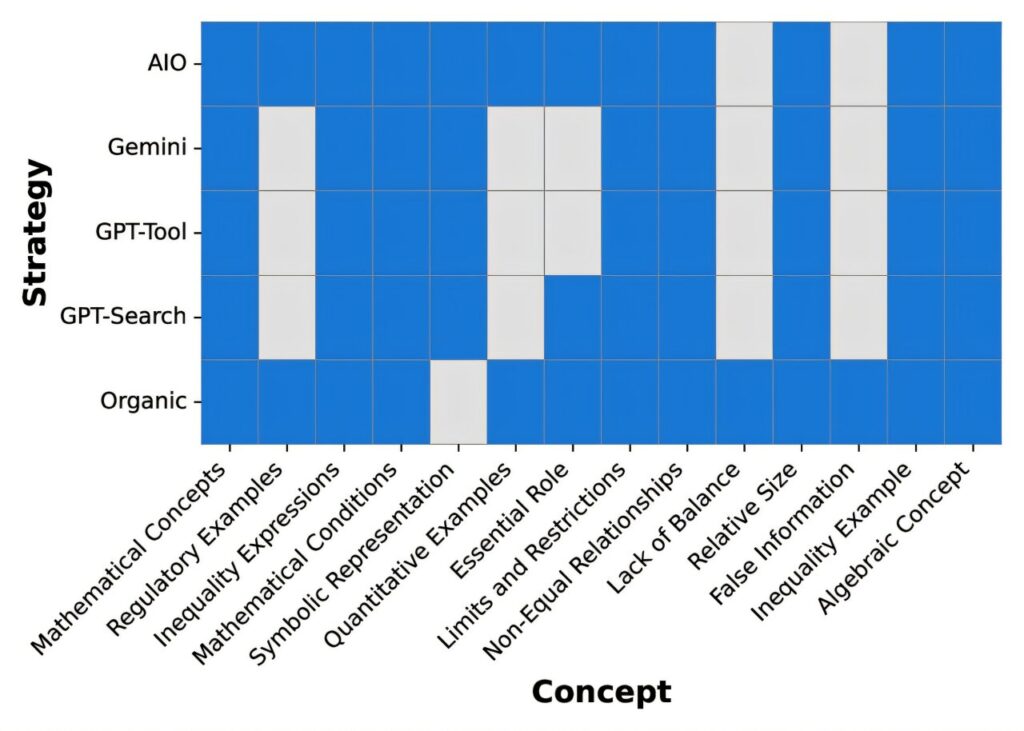

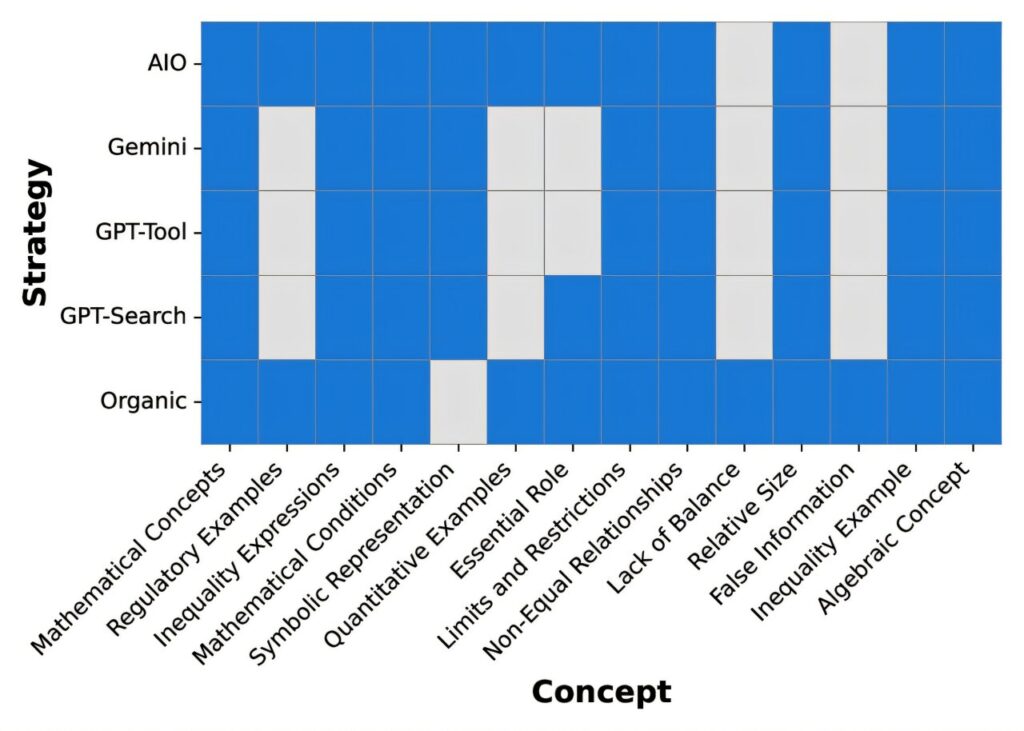

Les chercheurs ont comparé la recherche Google traditionnelle à quatre moteurs de recherche intégrant de l’IA : Google AI Overview, Gemini, GPT-4o-Search et GPT-4o avec Search Tool. Ces outils ont été testés sur des milliers de requêtes couvrant six grands domaines, notamment la culture générale, la politique, les sciences et le commerce.

Les résultats ont été évalués selon trois principaux indicateurs : la diversité des sources utilisées, la dépendance aux connaissances internes ou externes et la couverture conceptuelle, c’est-à-dire l’éventail d’idées englobé dans les résultats. Les tests ont ensuite été répétés deux mois plus tard afin d’observer l’évolution des sources et des réponses.

Les analyses de l’équipe — détaillées dans une étude parue sur le serveur de prépublication arXiv — révèlent des écarts notables entre les deux approches. Les outils d’IA exploraient effectivement un spectre de sources plus large que les moteurs classiques. Toutefois, les liens qu’ils mobilisaient n’appartenaient que rarement aux sites les plus pertinents habituellement proposés par la recherche standard.

Selon les chercheurs, le recours à un plus grand nombre de sources ne garantit donc pas une réponse plus complète ou plus cohérente. Les données comparatives auraient même montré que ce n’était souvent pas le cas. « Les différences dans le choix des sources et l’utilisation des connaissances internes peuvent subtilement modifier les perspectives et les faits auxquels les utilisateurs sont exposés, même lorsque la couverture globale du sujet semble similaire », précisent-ils dans leur rapport.

Les résultats produits par les IA se sont également révélés moins stables dans le temps, évoluant sensiblement après deux mois. Des différences entre outils ont aussi été relevées : GPT-4o avec Search Tool s’appuyait par exemple davantage sur ses connaissances internes, tandis que Google AI Overview et Gemini privilégiaient les informations issues de sources externes.

L’étude ne conclut pas que les outils d’IA soient moins performants en matière de recherche, mais elle met en évidence un risque accru d’instabilité et de manque de fiabilité. Cela pourrait signifier que les résultats de recherche d’IA nécessitent des vérifications approfondies pour en garantir l’exactitude. Les chercheurs soulignent enfin la nécessité de définir de nouveaux critères et normes d’évaluation pour juger la qualité des réponses produites par ces outils.