Des chercheurs ont développé un système de vision par ordinateur capable de détecter les mouvements plus rapidement que l’œil humain et jusqu’à quatre fois plus rapidement que les modèles existants. Le système imite la perception visuelle de l’œil biologique grâce à un nouveau dispositif de calcul de flux optique, lui conférant un gain de vitesse notable dans la détection des mouvements. La technologie pourrait contribuer à améliorer les systèmes autonomes afin de les rendre plus sûrs et plus efficaces dans des environnements dynamiques.

Proposés pour la première fois dans les années 1950, les systèmes de flux optique visent à imiter la perception visuelle de l’œil biologique en estimant en temps réel les vecteurs de mouvement au sein d’une scène visuelle. L’œil biologique excelle notamment dans le traitement instantané de grands volumes de signaux visuels, en se focalisant de manière dynamique sur les régions générant des mouvements.

Les systèmes de flux optique exploitent des représentations bidimensionnelles des gradients de mouvement des pixels, offrant ainsi des représentations plus précises que les approches standards et permettant de s’adapter plus efficacement aux environnements réels et en constante évolution. Autrement dit, au lieu de traiter l’ensemble du champ visuel, ces systèmes réagissent spécifiquement aux objets en mouvement.

L’application des flux optiques aux technologies robotiques représente cependant un défi de taille, car l’analyse des mouvements dans des environnements réels exige de grandes puissances de calcul. L’analyse du flux optique sur une image de 1920 × 1080 pixels nécessiterait, par exemple, plus de 0,6 seconde avec un GPU Nvidia V100 (l’un des plus puissants du marché), selon les estimations avancées — soit environ quatre fois plus de temps que celui attribué à l’œil humain pour une tâche équivalente. Un tel temps de latence serait peu compatible avec des systèmes autonomes appelés à évoluer dans des environnements réels.

À titre de comparaison, le système Autopilot de Tesla utilise des réseaux de détection de présence pouvant atteindre un temps de latence de seulement 10 millisecondes, mais n’atteint pas encore, sur certains critères tels que la finesse de représentation des mouvements, les performances que les systèmes à flux optique pourraient offrir.

Une équipe internationale de chercheurs propose un nouveau système de vision numérique destiné à surmonter les limites actuelles des dispositifs de flux optique. « Inspirés par le système d’interaction entre la rétine et le corps genouillé latéral biologiques, nous proposons un dispositif neuromorphique qui détecte directement les changements de mouvement grâce à des transistors synaptiques neuromorphiques bidimensionnels », écrivent les chercheurs dans leur étude publiée le 10 février dans la revue Nature Communications.

Quatre fois plus rapide que les modèles existants

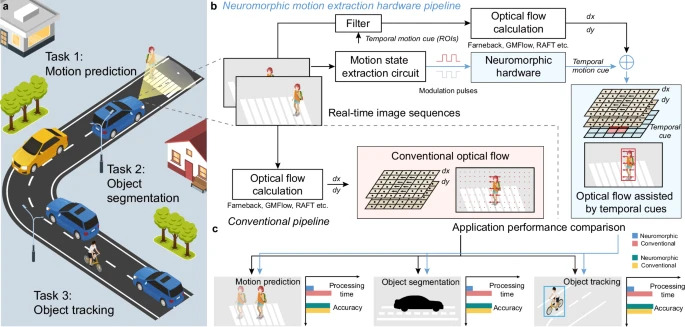

Pour analyser les flux optiques avec précision, le nouveau dispositif s’appuie sur un réseau de transistors synaptiques bidimensionnels, chargé d’identifier les zones de mouvement dans le champ visuel à partir des variations de luminosité. Cette approche permet de concentrer le traitement sur les seules régions en mouvement. Une fois repérées, ces « zones d’intérêt » sont transmises à des algorithmes de vision classiques pour une analyse plus approfondie.

Testé dans divers scénarios — conduite de véhicules autonomes, pilotage de drones et de bras robotisés — le système détecte les variations de luminosité du champ visuel en seulement 100 microsecondes. Il pouvait également conserver les informations de mouvement pendant plus de 10 000 secondes — une durée correspondant, selon les auteurs, à la capacité de rétention du dispositif dans les conditions expérimentales — et fonctionner pendant plus de 8 000 cycles opérationnels sans dégradation de ses performances.

D’après les estimations de l’équipe, ces performances sont quatre fois supérieures à celles des systèmes de vision par ordinateur existants. L’approche aurait même permis de dépasser, dans certains cas, la vitesse de traitement de l’œil humain.

« Nous ne remplaçons pas complètement le système de caméra existant ; en revanche, grâce à l’utilisation de modules matériels, nous permettons aux algorithmes de vision par ordinateur existants de fonctionner quatre fois plus vite qu’auparavant, ce qui représente une valeur pratique accrue pour les applications d’ingénierie », explique au South China Morning Post, Gao Shuo, co-auteur de l’étude et professeur associé à l’École d’instrumentation et d’ingénierie optoélectronique de l’Université de Beihang, en Chine.

La technologie pourrait améliorer le traitement d’images en temps réel et permettre aux systèmes autonomes de prendre en charge des tâches plus complexes, telles que l’évitement des collisions. Davantage de recherches seront toutefois nécessaires afin d’évaluer les performances effectives du système dans une variété d’environnements.