ChatGPT se révèle plus apte que les experts humains pour offrir des chroniques ou des conseils personnels, révèle une étude. Ce constat met en lumière la capacité de l’IA à répondre à des besoins émotionnels spécifiques. Il ouvre ainsi potentiellement la voie à une nouvelle ère, où l’IA pourrait compléter, voire améliorer, les méthodes traditionnelles de conseil.

Lancée en novembre de l’année dernière, ChatGPT compte désormais environ 100 millions d’utilisateurs actifs mensuels. Ce chatbot est basé sur l’un des modèles de langage les plus vastes jamais conçus, avec sa version premium GPT-4, qui compte environ 1,76 billion (un billion = mille milliards) de paramètres, témoignant de sa puissance en tant que modèle d’IA leader du marché. Cette innovation a marqué un tournant significatif dans le secteur de l’intelligence artificielle.

Entraîné avec une quantité massive de textes, une grande partie provenant du web, ChatGPT est capable de donner un avis sur une multitude de sujets. Il peut traiter des questions juridiques, médicales, historiques, géographiques, et économiques, bien qu’il soit toujours recommandé de vérifier ses réponses. Des chercheurs de l’Université de Melbourne se sont demandé si le modèle pouvait également fournir des conseils sociaux et des chroniques.

Dans le cadre de l’étude, publiée dans la revue Frontiers in Psychology, ChatGPT a démontré sa capacité à fournir des avis subjectifs plus efficaces et empathiques que ceux de chroniqueurs professionnels. Cette révélation interroge sur le rôle croissant de l’IA dans des domaines traditionnellement réservés à l’expertise humaine et soulève des questions sur l’évolution de notre interaction avec ces technologies.

Mise en situation de l’IA

Les auteurs ont cherché à savoir si les réponses fournies par ChatGPT étaient jugées supérieures à celles des humains dans des situations nécessitant de l’empathie. Pour cela, ils ont choisi aléatoirement 50 questions portant sur des dilemmes sociaux issus de dix colonnes de chroniques renommées dans les journaux, abordant divers thèmes tels que les relations amoureuses, les dilemmes éthiques, les défis managériaux, les questions de fin de vie et d’autres préoccupations quotidiennes auxquelles beaucoup peuvent s’identifier. À chacun des 400 participants, ils ont présenté un dilemme accompagné des réponses de ChatGPT et de celles d’un chroniqueur professionnel, sans indiquer l’origine de chaque réponse.

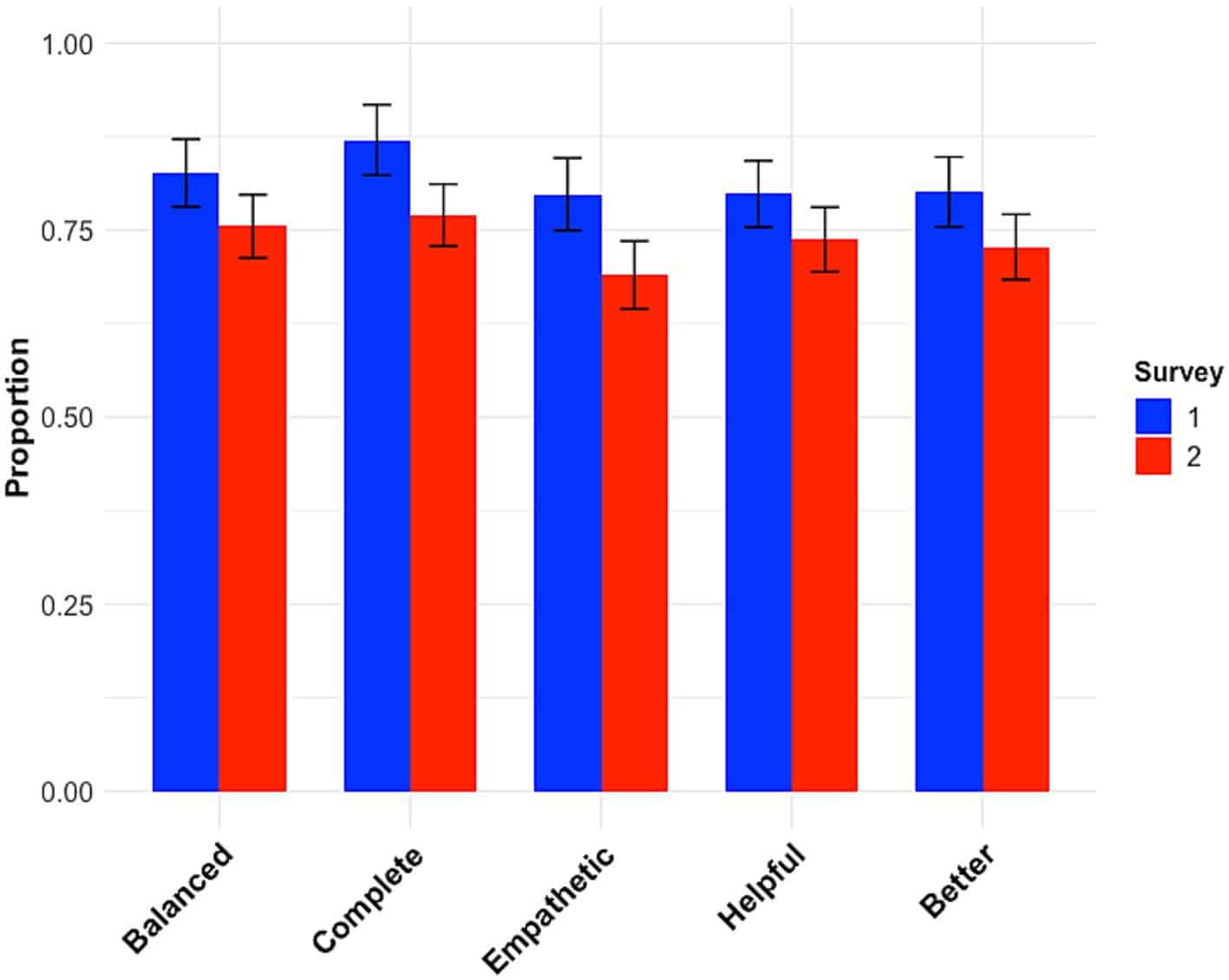

Près de trois quarts des participants ont trouvé que les chroniques de ChatGPT étaient plus équilibrées, complètes, empathiques, utiles et de meilleure qualité globale que celles du chroniqueur professionnel.

Les auteurs ont également remarqué que les réponses de ChatGPT tendaient à être plus détaillées que celles des chroniqueurs. S’agirait-il là de la raison de leur préférence par les participants ? Afin de vérifier cette hypothèse, ils ont répété l’étude en ajustant la longueur des réponses de ChatGPT pour qu’elles correspondent à celles des chroniqueurs humains.

Les résultats ont été similaires à ceux de l’étude initiale. Les participants ont continué à juger les avis de ChatGPT supérieurs en matière d’équilibre, de complétude, d’empathie, d’utilité et de qualité globale.

ChatGPT : un chroniqueur empathique et équilibré

Cette performance de l’IA est d’autant plus étonnante que l’intelligence artificielle n’a pas été spécifiquement programmée pour interpréter ou exprimer des dérivés d’émotions humaines. Initialement, ChatGPT a été conçu pour prédire le mot suivant le plus probable dans une phrase, une fonction basée sur l’analyse de vastes quantités de texte.

Cependant, il semble que cette capacité à traiter et à comprendre le langage ait évolué pour répondre de manière plus nuancée et sensible aux besoins émotionnels des utilisateurs. Cette évolution suggère que l’IA peut, dans une certaine mesure, simuler une compréhension des complexités humaines, y compris les nuances émotionnelles (certains chatbots alternatifs comme Jarvis en sont un bon exemple) qui entrent en jeu dans les conseils personnels.

Pourtant, malgré la qualité et l’apparente empathie des avis fournis par ChatGPT, de nombreux individus expriment une préférence pour les avis humains, en particulier lorsqu’il s’agit de questions personnelles, rapportent les auteurs dans un communiqué. Cette réticence à accepter pleinement l’IA comme source de conseils peut être attribuée à la perception que les machines, quel que soit leur degré de sophistication, ne possèdent pas la capacité de ressentir de véritables émotions.

Les êtres humains, en revanche, sont vus comme intrinsèquement capables de comprendre et de partager les sentiments d’autrui, une qualité fondamentale pour l’empathie. Cette distinction entre la simulation d’empathie par l’IA et l’expérience réelle de l’empathie humaine souligne une frontière claire dans la perception publique de l’intelligence artificielle, malgré ses avancées. Il reste à voir comment cette perception évoluera à mesure que l’IA continuera de se développer et de s’intégrer davantage dans nos vies.

Réflexion sur le comportement humain

Les chroniqueurs professionnels, face à l’émergence de ChatGPT et de ses capacités en matière de conseil, se trouvent à un point de réflexion critique. L’intelligence artificielle, en démontrant sa capacité à fournir des avis non seulement complets, mais aussi nuancés, redéfinit les attentes. Cette nouvelle norme, établie par l’IA elle-même, met un véritable coup de pression sur les chroniqueurs, et d’autres professionnels. Mais certains voient cela comme une opportunité de reconsidérer et d’adapter les méthodes.

En s’inspirant de l’approche analytique et empathique de ChatGPT, les chroniqueurs peuvent par exemple enrichir leur propre style, laissant percevoir une compréhension plus profonde et diversifiée des problématiques soumises. Cette adaptation n’est pas seulement une question de compétition avec l’IA, mais aussi une chance d’améliorer la qualité globale de certains textes, en tirant parti des aptitudes de l’intelligence artificielle à compléter et renforcer l’expertise humaine.