Après un lancement en grande pompe, nous apprenons que Gemini — le nouveau modèle d’IA de Google Bard — est loin d’être aussi performant que Google l’avance dans sa vidéo de présentation. En effet, cette dernière, mettant en avant des capacités a priori bluffantes, aurait été au moins partiellement truquée et ne refléterait pas ses performances réelles. Le modèle peut-il donc réellement surpasser son concurrent GPT-4, comme l’affirme l’entreprise ?

Plus tôt cette semaine, Google a lancé Gemini, le présentant comme son modèle d’IA le plus performant à ce jour. Trois versions ont été annoncées : Gemini Nano, intégré au Google Pixel 8, Gemini Pro, intégré à Bard et Gemini Ultra (pour l’instant indisponible), la version la plus performante destinée à la réalisation de tâches complexes.

La vidéo de présentation publiée par l’entreprise révèle les performances et capacités du modèle, dont la reconnaissance et l’analyse d’une série d’illustrations et d’objets, tout en « conversant » avec son utilisateur à leur sujet. Il devait par exemple suivre un morceau de papier caché sous un gobelet afin de définir sa position, reconnaître un jeu de pierre-feuille-ciseaux ou déduire qu’une image en pointillés représentait un crabe. Sa capacité à engager un processus de réflexion multimodal semble impressionnante dans la vidéo. Cette dernière donne en effet l’impression d’une interaction en temps réel avec l’utilisateur, Gemini se montrant capable de tenir une conversation fluide et stimulante.

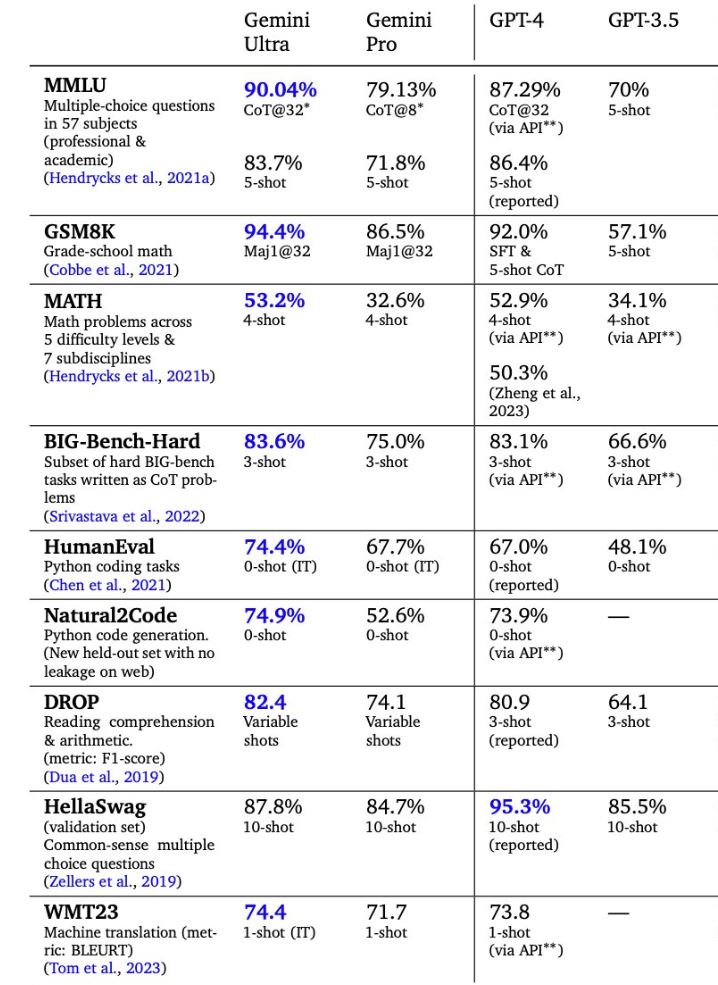

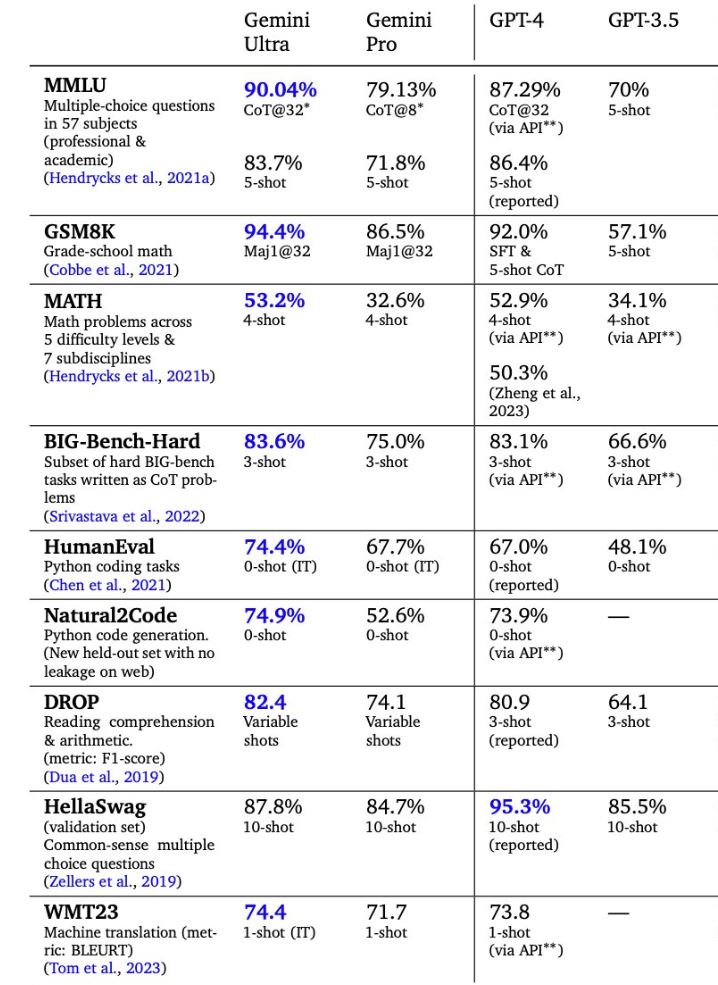

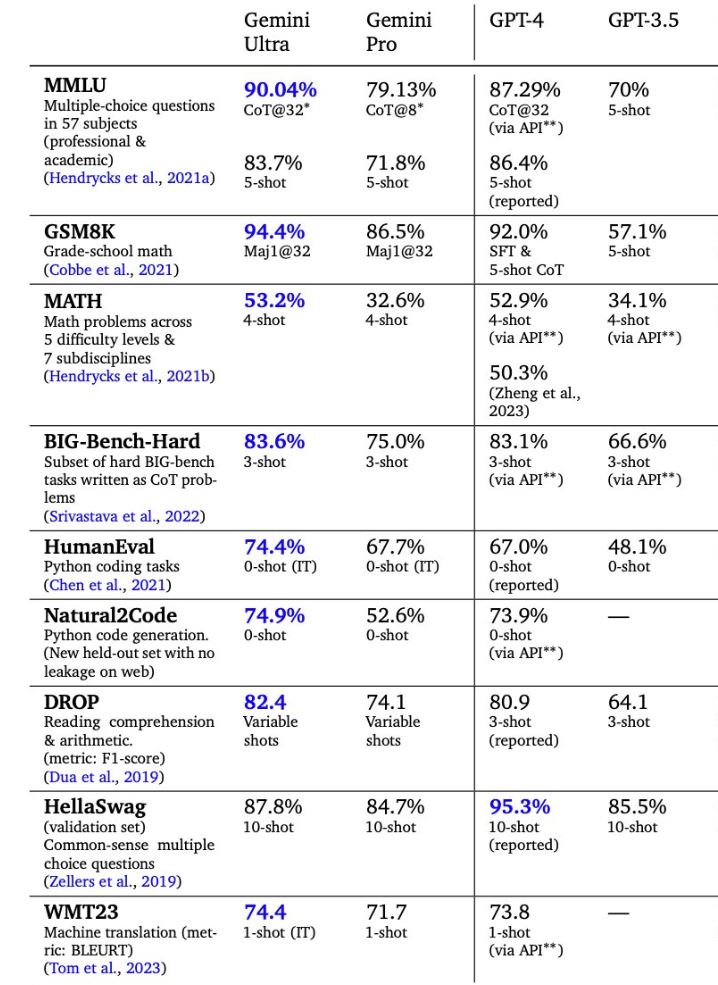

Cependant, Google semble lui-même avoir admis que cette vidéo de démonstration est au moins partiellement truquée, selon un rapport de Bloomerberg. Cela signifie qu’elle ne reflète pas nécessairement les véritables capacités du modèle, surpassant selon l’entreprise GPT-4 (du moins dans sa version Ultra, selon leurs essais).

Un coup de publicité mensongère ?

En réalité, la démo n’a pas été réalisée en temps réel comme semble le montrer la vidéo. En fait, l’utilisateur ne converse pas réellement de vive voix avec Gemini. Selon un porte-parole de Google, ce semblant de conversation a été réalisé en montrant des séquences d’images fixes à l’IA et en entrant des invites textuelles que la voix « off » qu’on entend dans la vidéo lisait. C’est très différent de ce que l’entreprise semble suggérer, notamment le fait que l’on puisse avoir une conversation réelle avec Gemini et qu’il puisse interagir en temps réel avec l’environnement qu’on lui présente.

En outre, la description de la vidéo indique que « pour les besoins de cette démo, la latence a été réduite et les sorties de Gemini ont été raccourcies par souci de concision ». La vidéo comporte d’ailleurs des notifications indiquant « séquence raccourcie ». Cela signifie que le temps de réponse du modèle est en réalité plus long que dans la vidéo. En d’autres termes, Google a modifié la vitesse des réponses. Cela implique que finalement, nous n’avons aucune idée des performances réelles de la gestion multimodes.

« La vidéo illustre à quoi pourraient ressembler les expériences utilisateur multimodes créées avec Gemini », a expliqué sur X Oriol Vinyals, vice-président de la recherche et responsable de l’apprentissage profond chez Google DeepMind. Cette utilisation du conditionnel pourrait suggérer que les impressionnantes fonctionnalités démontrées dans la vidéo n’en sont encore qu’au stade de projet ou de prototype.

Par ailleurs, si certaines des fonctionnalités présentées manquent aux autres grands modèles de langage, d’autres en revanche sont loin d’être inédites. Bon nombre d’entre elles peuvent d’ailleurs être reproduites avec ChatGPT Plus. Nous avons d’ailleurs pu mettre à l’épreuve la version Pro de Gemini par le biais, entre autres, d’un simple test de logique. Verdict : ses performances au test sont comparables à celles de GPT-4, bien qu’il se soit montré plus méthodique dans ses réponses. Toutefois, même si Google annonce pouvoir surpasser GPT-4 avec Gemini Ultra, il n’a pas été précisé dans la vidéo si la version « présentée » (les guillemets sont désormais nécessaires) est la Pro ou l’Ultra.

En vue de ces constats, les performances de Gemini telles que présentées ne seraient-elles rien d’autre que de la publicité mensongère ? Il est important de noter qu’il ne s’agit pas de la première fois que Google échoue à convaincre avec une démonstration, comme le triste exemple de l’ancien modèle derrière Bard, qui avait généré une fausse information sur le télescope James Webb, plus tôt cette année.

D’un autre côté, on pourrait penser que l’entreprise s’est précipitée pour lancer son modèle d’IA, qui n’était pas encore tout à fait prêt, probablement dans le but de profiter d’un moment durant lequel OpenAI fait face à certains défis organisationnels. L’éviction temporaire de Sam Altman aurait en effet créé une vague d’incertitudes au sein de l’entreprise, avec des impacts sur le cours de ses actions en bourse. Néanmoins, OpenAI semble toujours avoir une longueur d’avance sur Google et les autres concurrents.