Ayant dominé le marché jusqu’ici, ChatGPT risque désormais d’être détrôné par Bard (l’IA générative de Google), désormais alimenté par son nouveau modèle de langage baptisé Gemini. À en croire le descriptif de ses capacités et les démonstrations publiées par Google, Gemini pourrait bien compenser l’échec de LaMDA — le premier modèle derrière Bard.

Google décrit cette première version de Gemini comme étant son modèle d’IA le plus performant. Le système est dit multimodal, signifiant qu’il est capable de comprendre, traiter et intégrer plusieurs types de données ou signaux d’entrée (texte, audio, image, vidéo, code informatique).

En effet, DeepMind, la branche IA de Google, précise que Gemini est « capable de généraliser, comprendre avec fluidité, traiter et combiner différents supports d’informations, dont le texte, le code, l’audio, l’image et la vidéo ». Le système revendique également une performance plus élevée par rapport au célèbre GPT-4.

Trois versions de Gemini

Gemini se décline en trois versions. Gemini Ultra est le modèle le plus performant des trois, et c’est celui qui convient aux tâches les plus complexes. Il sera disponible début 2024, notamment dans une version avancée de Bard.

Il y a ensuite Gemini Pro, décrit par DeepMind comme le « meilleur modèle pour évoluer sur un large éventail de tâches ». Il est déjà intégré à Bard, mais uniquement en anglais. Cependant, les pays européens n’y ont pas encore accès, comme c’était le cas au lancement de Bard. Google a bien entendu publié la liste des pays qui peuvent d’ores et déjà y accéder.

Enfin, il y a Gemini Nano, intégré nativement dans le Google Pixel 8. Ce modèle ultraléger promet d’apporter un lot de fonctionnalités avancées telles que la génération de résumés automatiques pour les enregistrements vocaux, des réponses intelligentes dans Gboard et bien d’autres visant à améliorer l’expérience utilisateur.

Plus performant que GPT-4 ?

Vanté pour ses performances exceptionnelles, Gemini est, selon Google, le premier modèle à surpasser les experts humains sur le test de performance MMLU (Massive Multitask Language Understanding, ou « Compréhension massive et multitâche des langues »). Le MMLU est un cadre de test conçu pour évaluer la compréhension du langage et les capacités de résolution de problèmes des modèles d’IA. Il se compose de plusieurs tâches portant sur des domaines de connaissance différents, tels que la science, la littérature, l’histoire, etc.

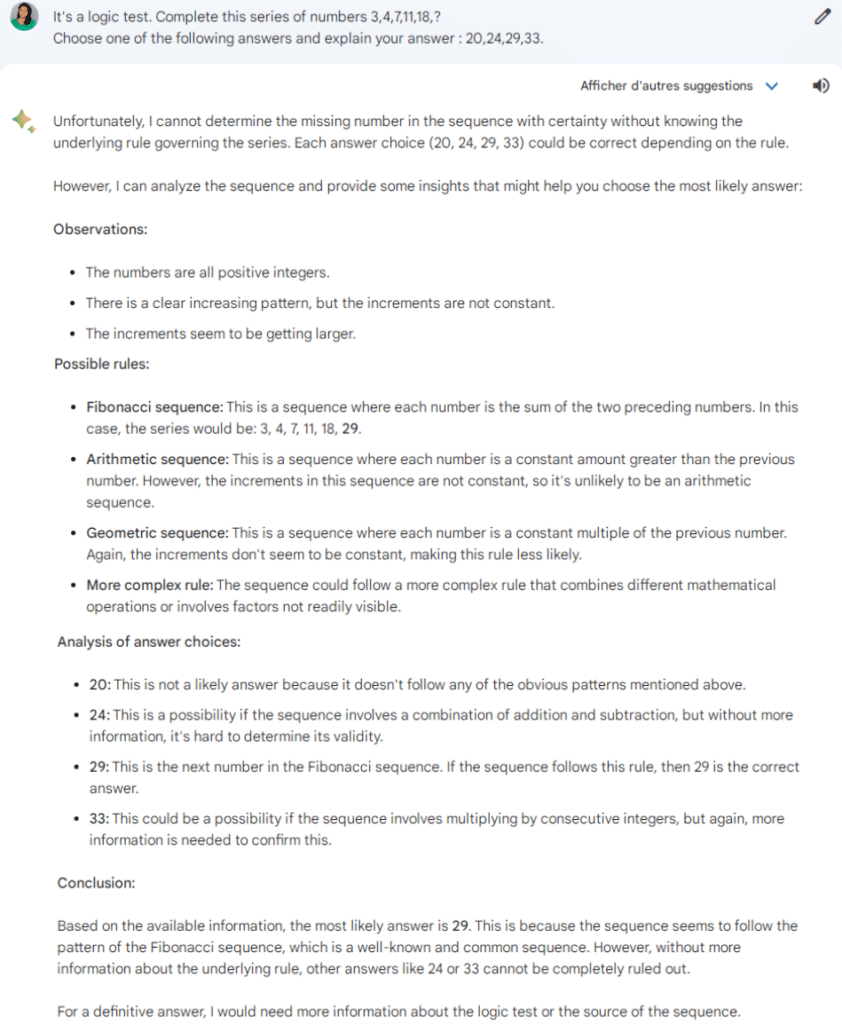

Pour tester nous-mêmes la logique de Gemini Pro, nous lui avons, entre autres, soumis une série de chiffres en lui demandant de choisir parmi les réponses proposées. Voici le prompt que nous avons utilisé : « It’s a logic test. Complete this series of numbers 3,4,7,11,18,? Choose one of the following answers and explain your answer : 20,24,29,33 ». Le résultat correct est 29.

Verdict : Gemini Pro a bien choisi 29 comme réponse, même s’il ne semblait pas vraiment sûr de lui. Il explique par contre le processus de réflexion qui l’a mené à son choix.

Selon son annonce d’il y a quelques mois déjà, Gemini est censé pouvoir rivaliser avec GPT-4. Par ailleurs, Google DeepMind a mené une série de tests comparatifs entre les deux modèles. Ces évaluations ont révélé que Gemini surpasse GPT-4 dans 30 des 32 compétences testées.

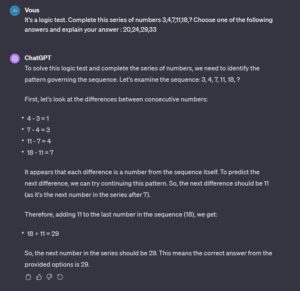

Nous avons donc également soumis notre test logique à ChatGPT-4, afin de comparer les résultats.

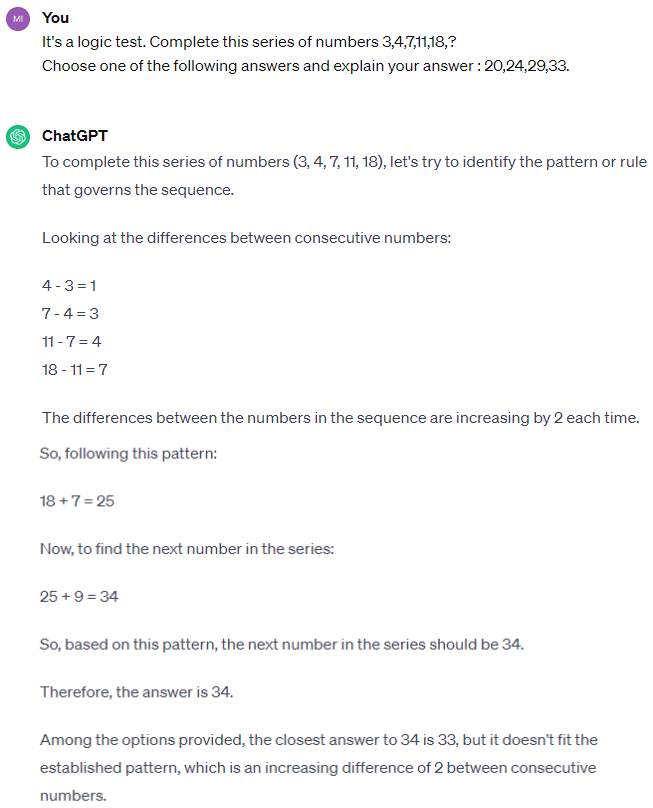

Et rebelote, cette fois-ci avec GPT-3.5 :

Conclusion : on peut voir que GPT-3.5 n’a pas su répondre correctement à la question, avançant 34 au lieu de 29. GPT-4 quant à lui nous a donné la réponse correcte, et son processus de résolution est clair et précis, voire original. Gemini Pro s’est montré plus méthodique, allant jusqu’à donner les noms des règles suggérées pour la résolution du problème. Il a entre autres facilement proposé la suite de Fibonacci comme étant la règle ressemblant le plus à celle à appliquer pour parvenir à la réponse.

Nos essais ne sont que des exemples montrant des différences dans les capacités et le fonctionnement de ces trois modèles, mais ne permettent en aucun cas de tirer des conclusions sur les performances globales. Cependant, force est de constater que le seul à avoir échoué à ce test, pourtant simple, est GPT-3.5. Serait-il donc bientôt temps de lui dire au revoir ? C’est probable, surtout avec les prochaines itérations (plus rapides) du modèle GPT-4.

Pour ce qui est de la comparaison GPT-4 VS Gemini, il ne faut pas non plus oublier que c’est Gemini Ultra (qui nous est inaccessible pour le moment) qui est présenté comme le plus puissant des modèles. Prévu pour 2024, il afficherait d’ailleurs un niveau de compréhension multimodale (texte, audio, image, vidéo, code) révolutionnaire, comme l’atteste cette vidéo de démonstration de Google :