L’intelligence artificielle, tout comme les technologies d’interfaçage homme-machine, ont fait des progrès extraordinaires durant ces dernières années. Les systèmes de mesure et de lecture des ondes cérébrales deviennent de plus en plus précis, et combinés à l’intelligence artificielle, il est déjà possible d’obtenir des technologies capables de lire de mieux en mieux « dans les pensées ». Une nouvelle IA développée par la société Neurobotics est désormais capable, dans une certaine mesure, de « lire » des vidéos que les gens regardent en déchiffrant leurs ondes cérébrales.

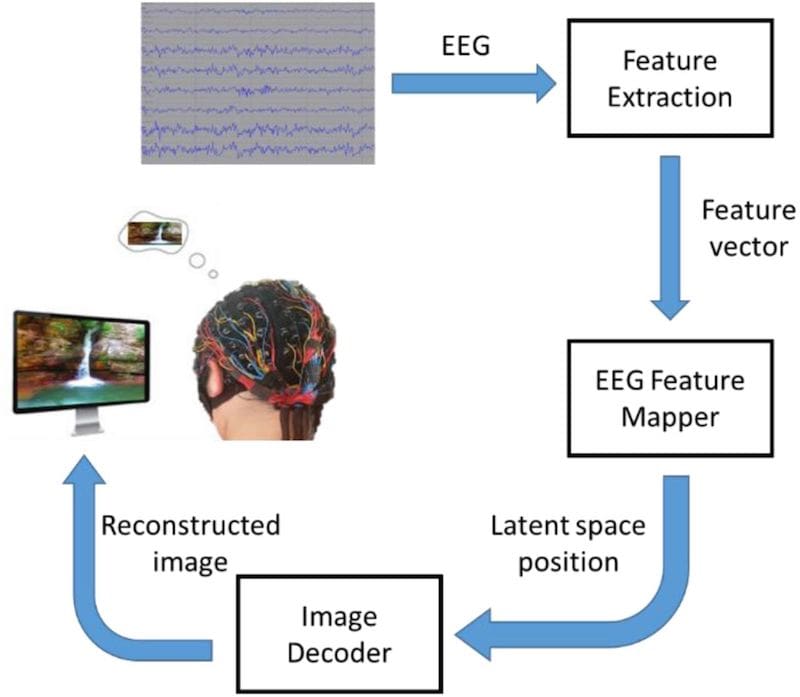

Grigori Rachkov de la société de recherche russe Neurobotics et ses collègues, ont développé un système d’IA par apprentissage automatique, à l’aide de clips vidéo de différents objets et d’enregistrements des ondes cérébrales d’individus les observant.

Les enregistrements ont été réalisés à l’aide d’un casque EEG (électroencéphalogramme), et les clips vidéo comprenaient des scènes de nature, des courses automobiles, des personnes en jet-ski et des visages humains faisant différentes expressions.

L’intelligence artificielle a ensuite essayé de classer et de recréer les clips vidéo à partir des données EEG uniquement. Dans 210 tentatives sur 234, l’IA a réussi à catégoriser chaque vidéo en fournissant la catégorie appropriée, telles que « cascades », « sports extrêmes » ou « visages humains ».

Visuellement, l’IA semblait avoir le plus de succès à recréer les thèmes principaux des images, tels que les couleurs et les grandes formes. Les détails plus nuancés tels que ceux caractérisant les visages humains étaient plus difficiles à recréer, la plupart apparaissant déformés et illisibles.

Les systèmes IA actuels capables de « lire dans les pensées » ne se concentrent que la surface de la pensée humaine, explique Victor Sharmas de l’Université de l’Arizona. « Ce que nous voyons actuellement est une caricature de l’expérience humaine, mais rien de très exact », dit-il.

Sur le même sujet : Une intelligence artificielle peut prédire le risque de décès à court terme, et les chercheurs sont confus quant à son fonctionnement

Selon les chercheurs, d’autres recherches approfondies seront donc nécessaires pour explorer l’efficacité des systèmes BCI (interface cerveau-ordinateur, ou interface neuronale directe) dans des applications réelles. Il s’agira surtout d’améliorer la précision des images reconstruites.

Dans leurs travaux futurs, les scientifiques se concentrerons notamment sur les aspects suivants : explorer plus de catégories de stimuli visuels, l’amélioration de la qualité des images reconstruites par l’intégration d’un discriminateur dans le réseau de décodeurs d’images, l’élaboration de critères d’évaluation de la qualité des images reconstruites à partir des caractéristiques de l’EEG, ainsi que la mise en place d’expériences comparatives pour évaluer le rôle de la sélection de stimuli adaptatifs et de la présentation visuelle de la rétroaction dans la vitesse et la qualité de la formation des opérateurs BCI.

Démonstration du système en plein fonctionnement :

P.S : À partir d’un certain moment dans la vidéo, il y a un léger décalage entre l’image originale affichée et l’image reconstruite.