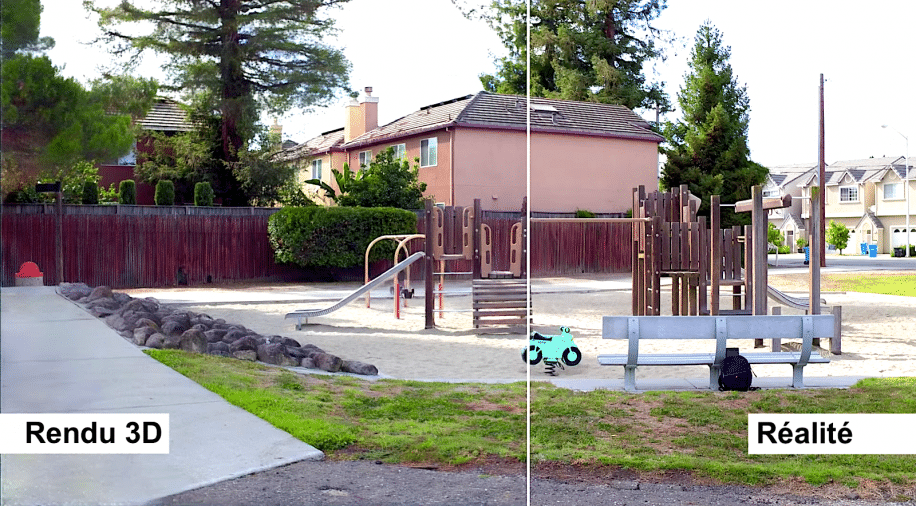

Des chercheurs allemands ont développé une intelligence artificielle capable de créer, automatiquement, des environnements virtuels 3D à partir de quelques images (2D). En simplifiant ainsi la création d’espaces 3D réalistes, les applications potentielles sont variées, allant de la réalité virtuelle à la recherche, en passant par le cinéma.

Pour créer une scène 3D, les chercheurs n’ont besoin d’alimenter leur intelligence artificielle qu’avec quelques images. Leur réseau neuronal, qui est capable de visualiser et de comprendre avec précision l’aspect et les jeux de lumière de n’importe quelle vue 2D, fournit ainsi toutes les informations nécessaires pour les phases de création et de rendu 3D, réalisées avec le logiciel COLMAP.

Les plus calés d’entre vous se diront ici : « mais des algorithmes similaires ont déjà été inventés ! ». Oui, similaires certes, mais pas plus… En effet, ce réseau neuronal est très différent des systèmes précédents : il est capable d’extraire de véritables propriétés physiques à partir d’images fixes ! « Nous pouvons changer la pose de la caméra et obtenir ainsi une nouvelle vue de l’objet », explique Darius Rückert, qui a dirigé l’étude, de l’université d’Erlangen-Nuremberg (Allemagne).

Un monde 3D explorable à partir de deux images…

Pour résumer l’étendue des capacités de ce système, les chercheurs avancent qu’il pourrait créer un monde 3D explorable à partir de deux images seulement (bien qu’il ne serait pas très détaillé dans ce cas là). « Plus vous avez d’images, meilleure est la qualité », explique Rückert. « Le modèle ne peut pas créer des choses qu’il n’a pas vues ».

Certains des exemples les plus détaillés d’environnements générés utilisent entre 300 et 350 images capturées sous différents angles. Mais Rückert espère améliorer le système en lui faisant simuler la façon dont la lumière se reflète sur les objets de la scène pour atteindre la caméra, ce qui signifierait que moins d’images fixes seraient nécessaires pour un rendu 3D précis.

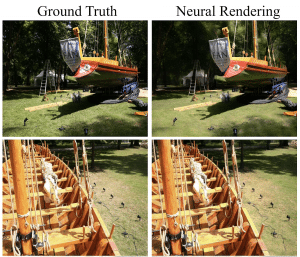

« Chaque point est projeté dans l’espace et son ‘descripteur’ neuronal est fusionné en une image neuronale multirésolution. Cette image est traitée par un réseau neuronal convolutionnel profond pour générer une image HDR de la scène », expliquent les chercheurs dans leur document. À partir de cela, un réseau neuronal convolutif convertit l’image HDR (High Dynamic Range) en LDR (Low Dynamic Range). Ce sont ces images optimisées autogénérées qui sont ensuite utilisées pour interpréter l’environnement, afin de créer un espace 3D en combinant et en croisant les données.

Les chercheurs peuvent entraîner le réseau neuronal de bout en bout en utilisant des images, un nuage de points ou les paramètres de la caméra en entrée. « Comme toutes les étapes sont différentiables, les paramètres qui doivent être optimisés peuvent être choisis librement, par exemple la pose de la caméra, le modèle de la caméra ou la couleur de la texture », ajoutent-ils.

Quelques notions : L’imagerie à grande gamme dynamique (HDRI) regroupe des systèmes permettant de capturer et/ou afficher une image (fixe ou animée) d’une scène comportant des niveaux très variés de luminosité. L’obtention d’une photographie HDR peut aussi se faire avec un appareil traditionnel en prenant plusieurs photos LDR (low dynamic range) puis en les fusionnant avec un logiciel.

« Une qualité de rendu inégalée »

« Jusqu’à présent, la création d’images photoréalistes à partir de reconstructions 3D n’était pas entièrement automatisée et présentait toujours des défauts perceptibles », explique Tim Field, fondateur de la société new-yorkaise Abound Labs, qui travaille sur des logiciels de capture 3D.

Bien que Field souligne que le système nécessite encore la saisie de données 3D précises et qu’il ne fonctionne pas encore pour les objets en mouvement, « la qualité du rendu est inégalée », affirme-t-il. « C’est la preuve que le photoréalisme automatisé est possible ». Field pense que cette technologie pourra être utilisée pour générer des effets visuels cinématographiques et à proposer des visites de lieux en réalité virtuelle. « Elle va accélérer le domaine de recherche déjà très dynamique du rendu basé sur l’apprentissage automatique pour l’imagerie générée par ordinateur », conclut-il.

Vidéo expliquant le projet et présentant les rendus 3D, publiée par les chercheurs :