Dans une autre étude, l’algorithme a correctement prédit le taux de mortalité par maladie cardiaque d’une région des États-Unis, en analysant le contenu de 148 millions de tweets ; les termes reliés à la colère et aux mauvaises relations humaines se sont révélés être des facteurs de risque. Les prédictions issues des réseaux sociaux se sont montrées bien plus fidèles aux taux de mortalité actuellement estimés que les prédictions basées sur 10 facteurs de risque, comme le diabète et la cigarette.

Les chercheurs ont utilisé la même méthode pour prédire les types de personnalités, les revenus mensuels, les idées politiques, les stéréotypes, la couverture médicale ou encore les expériences mystiques. L’IA a même permis d’élaborer une carte colorée de chaque région selon le bien être, la confiance et cinq traits de personnalité, uniquement à partir de Twitter.

« Une révolution est en marche concernant l’analyse du langage, et ses liens avec la psychologie » explique James Pennebaker, psychologue à l’université du Texas. Le contenu étant moins important que la forme ; l’utilisation d’articles et de prépositions indiquant des capacités analytiques plus élevées et prédisant des diplômes plus importants. En étudiant les mots et leur agencement, l’IA est désormais capable de prédire le comportement des masses avec un degré de fidélité spectaculaire.

Identifier les origines génétiques de l’autisme en séquençant le génome

Si les troubles du spectre de l’autisme (TSA) sont encore mal connus, de nombreuses recherches au cours de ces dernières années ont démontré qu’une forte composante génétique pouvait en être à l’origine. Mais les mutations retrouvées dans les gènes actuellement connus impliqués dans les TSA, n’expliquent que 20% des cas d’autisme observés. Identifier d’autres variations génétiques qui pourraient jouer un rôle dans l’autisme, nécessite l’analyse de 25’000 autres gènes humains et de leur satellites génétiques ; une tâche écrasante pour les généticiens.

Afin de contourner ce problème, la bio-informaticienne Olga Troyanskaya (université de Princeton) et la Fondation Simons utilisent l’intelligence artificielle comme outil principal. « En tant que biologistes, nous nous sommes limités dans notre recherche des facteurs sous-jacents de maladies comme l’autisme. La puissance d’une machine capable de traiter des centaines de milliards de données là où nous ne sommes humainement capable d’en traiter que des centaines, est un avantage crucial » explique Robert Darnell, directeur du Centre sur le Génome de New York.

Troyanskaya a combiné des milliers de données sur les gènes codants dans l’ADN des cellules humaines, sur l’interaction des protéines, les sites de liaison des facteurs de transcription et plusieurs autres éléments importants. Ensuite, son équipe a utilisé un réseau de neurones pour développer une carte des interactions entre gènes, et comparer les quelques gènes impliqués dans l’autisme avec des milliers d’autres inconnus, dans le but de trouver des similarités. Les résultats, publiés dans le journal Nature Neuroscience, ont révélé 2500 gènes supplémentaires jouant un rôle dans les TSA.

Toutefois, les gènes n’agissent pas de manière isolée, leur dynamique est régulée par les millions de bases non-codantes environnantes interagissant avec les protéines de liaisons à l’ADN et d’autres facteurs génétiques. Identifier quelles variations non-codantes affectent les gènes impliqués dans l’autisme s’avère donc être un problème nettement plus compliqué.

Pour le solutionner, les scientifiques ont entraîné un algorithme de deep-learning en lui soumettant les données collectées par l’Encyclopédie des éléments de l’ADN et la Carte Épigénomique, deux projets ayant catalogué des dizaines de milliers de sites non-codants de l’ADN affectant les gènes alentours.

À partir de ces données, l’algorithme a identifié les facteurs clés permettant de discriminer quels sites non-codants affectent effectivement les gènes ou non. Le projet, appelé « DeepSEA », et dont les premiers résultats ont été publiés dans la revue Nature Methods, analyse aujourd’hui les génomes de plusieurs patients autistes afin de déterminer quels bases non-codantes affectent les gènes impliqués dans l’autisme. En outre, l’algorithme est également entraîné pour reconnaître d’autres mutations susceptibles de provoquer plusieurs maladies génétiques.

Scruter et comprendre le ciel grâce aux réseaux de neurones

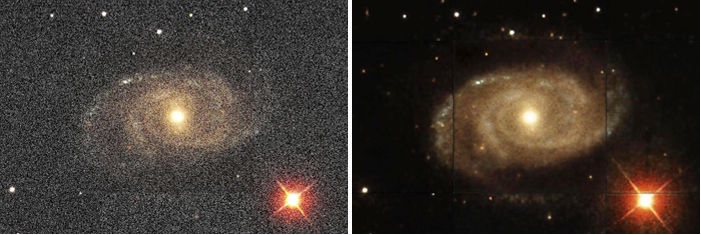

En avril 2017, l’astrophysicien Kevin Schawinski a posté 4 images floues de galaxies sur Twitter, en demandant à ses collègues de l’aide pour les identifier. Ces derniers ont catégorisé les galaxies comme des galaxies spirales et elliptiques. Cependant, certains astrophysiciens se sont révélés plus sceptiques et on demandé à Schawinski s’il s’agissait de véritables galaxies ou de simulations réalisées grâce à des paramètres physiques pré-enregistrés.

L’astrophysicien a répondu qu’il ne s’agissait ni de l’un ni de l’autre. En effet, à l’Ecole Polytechnique de Zurich (Suisse), lui et ses collègues ont utilisé un réseau de neurones qui ne connaissait rien de la physique pour réaliser ces images de galaxies ; l’IA semblait savoir à quoi celles-ci devaient ressembler.

Grâce à sa publication, Schawinski souhaitait montrer à quel point le travail d’une IA peut être convaincant. Mais surtout, il a voulu montrer qu’un réseau de neurones était capable de produire une image de galaxie comme si elle provenait directement d’un télescope. Une telle prouesse pourrait aider les astronomes à discerner certains détails plus facilement que de réels clichés. « Des millions de dollars sont investis dans la surveillance de l’espace. Avec cette technologie, nous pouvons extraire bien plus d’informations » explique Schawinski.

L’équipe d’astrophysiciens a utilisé un modèle de machine-learning particulier appelé « réseau générateur contradictoire » ; c’est un modèle composé de deux réseaux de neurones en compétition l’un contre l’autre. L’un est un générateur produisant l’image et l’autre est chargé d’identifier tous les défauts de l’image, qui pourraient indiquer une simulation, forçant le générateur à s’améliorer davantage. Les chercheurs ont utilisé des milliers d’images de galaxies et les ont dégradées artificiellement. Ensuite, ils ont appris au générateur à les remettre en forme afin qu’elles passent inaperçues aux yeux du discriminateur.

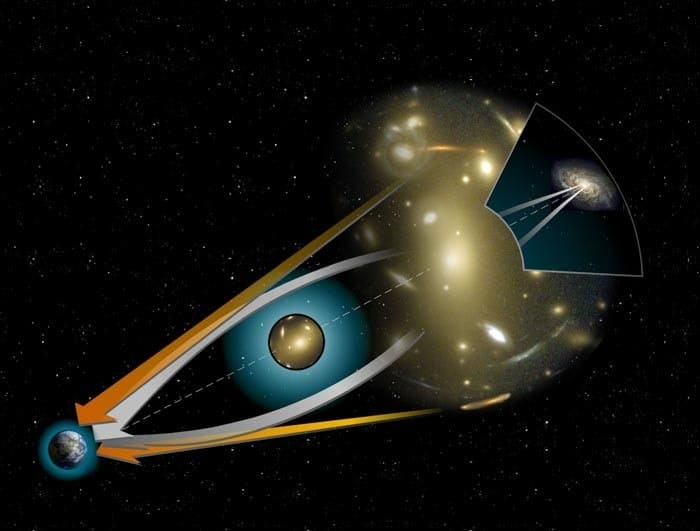

Si la méthode de Schawinski est une véritable prouesse technologique dans le domaine de l’astrophysique, ce n’est cependant pas la seule. En effet, peu avant, l’astrophysicien Brian Nord (Fermi National Accelerator Laboratory) avait présenté un algorithme de machine-learning capable de traquer les lentilles gravitationnelles fortes. Celles-ci sont facilement identifiables par l’œil humain, mais extrêmement compliquées à discriminer mathématiquement pour un ordinateur. En entraînant un réseau de neurones avec des milliers d’images de lentilles gravitationnelles, Nord et ses collègues ont donné cette capacité à leur IA.

Mais les possibilités offertes par l’IA ne s’arrêtent pas là. Récemment, des réseaux de neurones ont permis la découverte de plusieurs exoplanètes. L’identification manuelle d’exoplanètes au sein des millions de données collectées par les télescopes est fastidieuse et facilement sujette à l’erreur. Les réseaux de neurones sont capables de détecter précisément les schémas et récurrences dans les transits et de les distinguer du bruit de fond, afin de mettre en évidence l’existence d’exoplanètes.

Construire des molécules : l’intelligence artificielle au service de la chimie

Le travail des chimistes débute souvent par la fin ; ils ont une vision précise de la molécule finale à synthétiser, puis s’emploient à en élaborer la recette. « Vous avez besoin des bons ingrédients et de la recette pour les combiner correctement » explique Marwin Segler, chimiste à l’université de Münster (Allemagne).

Pour ce faire, lui et ses collègues utilisent l’intelligence artificielle afin de les aider à choisir entre les milliers d’éléments constitutifs et entre les milliers d’interactions chimiques pour les lier. Pendant des dizaines d’années, les chimistes ont difficilement programmé des ordinateurs intégrant des recettes connues, espérant créer un système calculant rapidement les bonnes réactions.

Cependant, comme le rappelle Segler, la chimie est une discipline subtile qui ne peut être totalement appréhendée par un programme. Donc, au lieu de programmer fastidieusement un ordinateur, ils ont utilisé un réseau de neurones apprenant de lui-même la manière dont les réactions chimiques se déroulent, grâce à des milliers d’exemples. Avec le temps, l’IA a appris à prédire la réaction la plus adéquate liée à une étape de synthèse particulière. Et finalement, elle a créé elle-même les recettes les plus efficaces.

Les chercheurs ont testé leur IA sur 40 cibles moléculaires et ont comparé les résultats avec ceux d’un programme de synthèse moléculaire standard. Tandis que ce dernier est parvenu à élaborer une solution pour synthétiser les molécules 22.5% du temps dans une fenêtre de 2 heures, l’IA y est parvenue 95% du temps. Les scientifiques espèrent pouvoir appliquer le réseau de neurones à la recherche pharmaceutique, afin d’améliorer la rapidité et l’efficacité de la synthèse de molécules thérapeutiques.