Depuis la publication sur YouTube d’une vidéo présentant une nouvelle intelligence artificielle capable de simuler et de prédire l’apparence d’un visage à partir d’une seule (ou plusieurs) image(s) source(s), l’exemple d’une Mona Lisa dont le visage et la tête sont entièrement animés par le système a rapidement fait le tour du web.

C’est sur l’exemple du joli sourire célèbre et quelque peu mystérieux de la peinture Mona Lisa que ce travail de recherche, effectué sous la supervision d’Egor Zakharov, ingénieur à l’Institut des sciences et de la technologie de Skolkovo et au Samsung AI Center (tous deux situés à Moscou, en Russie), s’est principalement fait connaître ces derniers jours.

Aujourd’hui, une nouvelle gamme d’expressions viennent se greffer à ce visage que vous connaissez toutes et tous, grâce à l’intelligence artificielle.

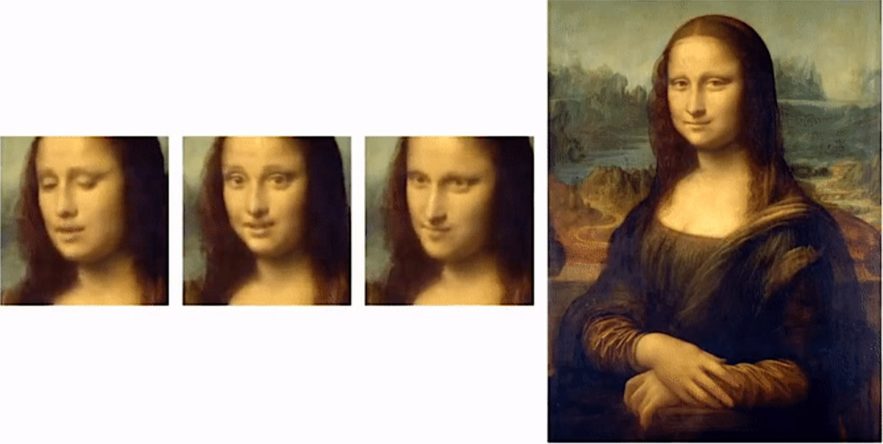

Dans la publication YouTube originale (publiée le 21 mai), trois clips vidéo montrent des exemples (perturbants) de Mona Lisa bougeant les lèvres et tournant la tête dans plusieurs directions. Elle a été créée par un réseau de neurones convolutionnels : un type d’IA qui traite des informations de la même manière que le cerveau humain, ici dans le but d’analyser et traiter des images.

Zakharov et ses collègues ont mis au point l’algorithme pour comprendre les formes générales des traits des visages humains et leurs comportements les uns par rapport aux autres, puis pour appliquer ces informations à des images fixes. Cela leur a permis d’obtenir une série de séquences vidéos réalistes montrant de nouvelles expressions faciales générées à partir d’une seule image.

Dans le cas des vidéos montrant Mona Lisa, l’IA a « appris » le mouvement du visage à partir de jeux de données de trois sujets humains, produisant trois animations très différentes. Alors que chacun des trois extraits d’apprentissage était encore reconnaissable en tant que Mona Lisa, Zakharov a donné des « personnalités » distinctes aux portraits vivants, comme vous pouvez le voir ci-dessous.

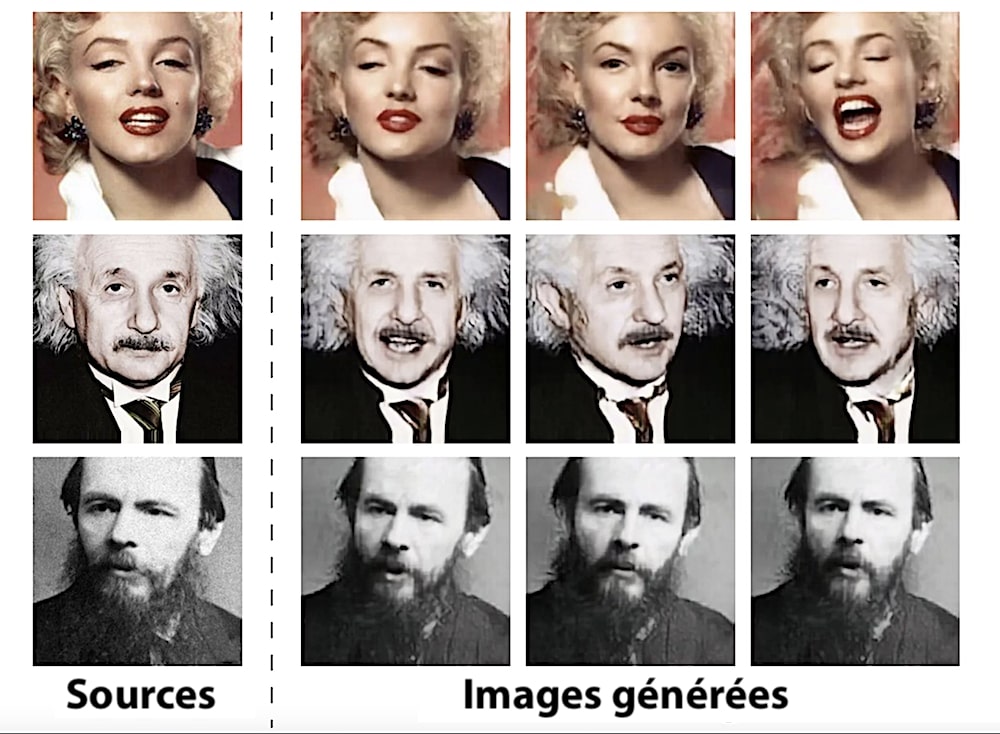

L’équipe de recherche a également créé des animations à partir de photos d’icônes culturelles du XXe siècle, telles qu’Albert Einstein, Marilyn Monroe et Salvador Dali. Les résultats de l’étude ont été publiés la semaine dernière sur le serveur de préimpression arXiv, dans l’attente d’une évaluation par les pairs.

De plus, selon l’étude, ce système de « vision humaine » est très efficace pour identifier des erreurs, même mineures, dans des visages ou têtes humaines modélisées en 3D. Voir quelque chose ayant l’air humain, sans pour autant vraiment l’être, déclenche une sensation de malaise profond connue sous le nom « d’effet de vallée dérangeante« .

Comme vous pouvez bien vous en douter, produire des vidéos originales comme celles-ci, connues sous le nom de deepfakes, n’est pas une chose facile. Les têtes humaines étant géométriquement complexes et hautement dynamiques. Les modèles 3D générés comportent « des dizaines de millions de paramètres », ont écrit les auteurs de l’étude.

L’intelligence artificielle a déjà démontré qu’il était possible de produire des deepfakes convaincants, mais elle nécessitait de multiples angles du sujet souhaité. Dans le cadre de cette nouvelle étude, les ingénieurs ont introduit l’intelligence artificielle dans un très grand ensemble de données de vidéos de référence montrant des visages humains en action. Ainsi, elle a pu apprendre d’elle-même, en créant sa propre interprétation de ce qu’est un visage humain et son comportement en mouvement.

Vous allez aussi aimer : Quelques coups d’oeil suffisent à cette IA pour en déduire une vue complète à 360 degrés

Pour lui attribuer une bonne base d’apprentissage, les scientifiques ont établi des repères faciaux qui pourraient s’appliquer à n’importe quel visage, afin d’enseigner au réseau de neurones le comportement des visages d’une façon globale.

Ensuite, ils ont formé l’IA à utiliser les expressions de référence pour cartographier le mouvement des entités de l’image source. Cela a permis au système de créer une simulation cohérente même si elle ne disposait que d’une seule image de base.

Et ce n’est pas tout : les chercheurs expliquent également que dans le cadre d’une session d’étude distincte impliquant l’utilisation de 32 images sources au lieu d’une seule, les simulations obtenues frôlaient la perfection.

Une technologie qui fait presque peur dites-vous ? On vous comprend. En effet, imaginez-vous que quiconque en possession d’une telle IA ainsi que de quelques photos de vous (et cela est très facile avec les réseaux sociaux), pourrait générer des séquences animées ultra-réalistes avec votre propre visage. Étant donné que les algorithmes d’imitation de la voix ne sont pas nouveaux, un mélange des deux technologies promettrait de produire des exemples (d’usurpation d’identité ?) sans égal, et avec une facilité déconcertante.