La montée en puissance des modèles de langage dans l’IA est un phénomène qui fascine autant qu’il interroge. Ces systèmes, de plus en plus avancés, s’appuient sur une masse colossale de données pour affiner leur performance. Prenons l’exemple du modèle GPT-4 d’OpenAI, une prouesse technologique nourrie par près de 570 gigaoctets de données textuelles, soit environ 300 milliards de mots. D’un autre côté, l’innovation dans le domaine de la génération d’images, à l’instar de technologies comme DALL-E 3, Lensa et Midjourney, repose sur des ensembles de données gigantesques tels que LIAON-5B, qui comprend 5.8 milliards de paires texte-image. Il est cependant essentiel de souligner que la quantité ne fait pas tout : la qualité des données est cruciale.

Des données de faible qualité, comme celles issues des réseaux sociaux ou des images de mauvaise résolution, peuvent dégrader la performance des modèles. Microsoft en a fait l’amère expérience avec son chatbot, formé sur des contenus de Twitter, qui a dérivé vers des propos inappropriés (dont racistes). D’où l’importance de privilégier des sources de haute qualité comme les livres, les articles en ligne, les publications scientifiques et Wikipédia. Seul problème dans ce cas : les données d’une telle qualité ne sont pas illimitées.

Pénurie de données : le nouveau défi des IA

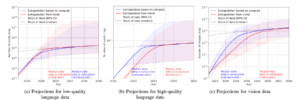

Nous sommes confrontés à un défi majeur : la disponibilité des données. Alors que le besoin en ensembles de données de qualité pour l’IA croît, le volume des données disponibles ne suit pas la même trajectoire. Une étude récente (octobre 2022) publiée sur arXiv prévoit notamment une possible pénurie de données textuelles de qualité d’ici 2026, un déficit qui s’étendrait aux données d’image vers 2030-2060. Cette situation pourrait freiner le développement de l’IA, un secteur pourtant estimé contribuer jusqu’à 15,7 mille milliards de dollars à l’économie mondiale d’ici 2030.

Face à cette problématique, plusieurs solutions se dessinent. D’une part, l’amélioration de l’efficacité des modèles d’IA, qui permettrait de produire des résultats performants avec moins de données et de puissance de calcul. Cette évolution aurait également un impact positif sur l’environnement, réduisant l’empreinte écologique de l’IA. D’autre part, l’utilisation de données synthétiques se présente comme une alternative prometteuse, offrant des données sur mesure pour les besoins spécifiques des modèles d’IA.

Vers un partage des revenus générés par l’IA ?

En parallèle, les créateurs de contenus, qui jusqu’à présent voient leurs œuvres utilisées sans leur consentement, pourraient bénéficier d’un modèle économique plus équitable. Des négociations, comme celles entamées par News Corp, pourraient ouvrir la voie à une rémunération des créateurs pour l’utilisation de leurs œuvres dans l’entraînement des IA. Ainsi, ces derniers seraient moins motivés à interdire l’accès à leurs images aux robots de téléchargement de contenu alimentant les modèles d’IA. Les plateformes numériques et les entreprises technologiques pourraient ainsi envisager de nouveaux modèles économiques qui rémunèrent équitablement les créateurs. Cela pourrait impliquer des accords de partage de revenus ou des systèmes de micropaiements, favorisant une distribution plus équitable des bénéfices générés par l’IA.

Ces perspectives révèlent un avenir de l’IA riche en défis, mais aussi en opportunités. La route vers une IA plus performante et responsable est complexe, mais les solutions émergentes promettent un futur innovant et équilibré. L’IA n’est pas seulement une question de technologie, mais aussi de gouvernance, d’éthique et de politique.