Qui n’a jamais pesté en farfouillant dans son sac à la recherche de ses clés ou de tout autre petit objet ? Cette tâche est pourtant simple pour nous, car nous disposons de trois sens pour nous aider, à savoir la vue, le toucher et surtout l’ouïe (le tintement des clés étant généralement un bon indice de leur emplacement). Qu’en serait-il si un robot devait accomplir la même tâche ? Une équipe de l’Université de Stanford a relevé le défi.

Les êtres humains sont capables d’accomplir toute une série de tâches de manipulation difficiles, qui sont généralement guidées par la combinaison des informations fournies par nos sens, principalement le toucher et la vue. Lorsque cette dernière est tout ou partiellement occultée — typiquement lorsque nous recherchons un objet sans avoir un point de vue direct sur la zone de recherche — le toucher devient prédominant. Mais l’ouïe peut également s’avérer très utile : entendre un « clic » peut par exemple nous indiquer qu’une pièce quelconque est bien positionnée, comme un tintement peut signaler la présence d’un objet métallique dans un contenant.

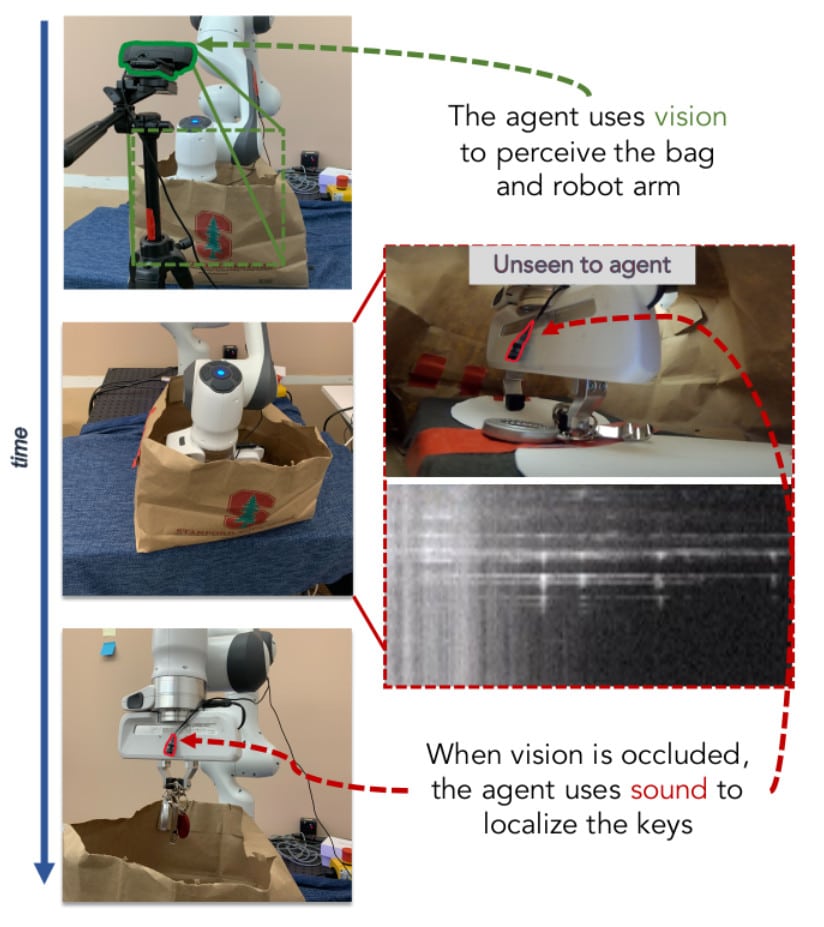

Les robots sont aujourd’hui capables d’accomplir eux aussi de très nombreuses tâches complexes, comme saisir des objets mous et déformables pour faire la lessive. Mais ces tâches reposent essentiellement sur la perception visuelle des objets. Peu de travaux se sont intéressés à la manipulation robotique « en aveugle ». La recherche d’un trousseau de clés au fond d’un sac fait aussi appel à la vue (pour localiser ledit sac), mais les clés elles-mêmes dépassent le champ de perception visuelle. Un robot chargé de cette tâche utiliserait donc exclusivement la détection tactile, qui devrait être particulièrement robuste (et coûteuse !) pour retrouver les clés parmi d’autres objets.

Un apprentissage par imitation couplé à un apprentissage en ligne

Une équipe de l’Université de Stanford a donc eu l’idée de remplacer le feedback tactile par un feedback audio. « Les microphones situés à proximité ou sur la pince d’un robot constituent un moyen bon marché et facile d’acquérir un retour audio des événements de contact », écrivent-ils. Ils ont donc équipé un bras robotique — le modèle PANDA, conçu par la société allemande Franka Emika — d’un microphone sur lequel s’appuie le robot dès que sa caméra est occultée.

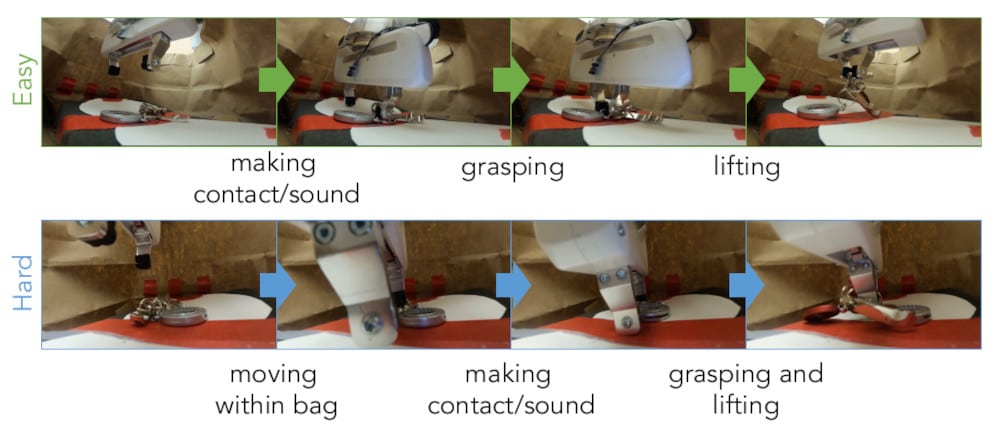

L’engin a appris à récupérer des objets dans un sac en fonction du son qu’ils produisent lors de la manipulation. Il s’agissait notamment de récupérer des objets particulièrement bruyants, tels qu’un sachet de chips ou un trousseau de clés. « Le système que nous proposons apprend ces tâches en combinant l’apprentissage par imitation hors ligne à partir d’un nombre modeste de démonstrations télé-opérées et le réglage fin en ligne à l’aide d’interventions humaines », précise l’équipe.

En effet, le robot a appris sa tâche à partir d’un humain équipé d’un casque et de contrôleurs Oculus VR (un casque de réalité virtuelle) effectuant la même tâche. Après cette première phase de formation (de type apprentissage par lots), le robot a effectué une autre session d’entraînement, guidé par des opérateurs humains, qui corrigeaient ses actions dès que nécessaire. Cet apprentissage automatique en ligne a permis d’améliorer le taux de réussite de l’apprentissage par imitation d’environ 20%, soulignent les chercheurs.

70% de réussite en combinant les informations visuelles et sonores

Finalement, le bras robotique s’est avéré capable d’accomplir un ensemble de tâches difficiles, comme extraire des clés, des stylos, un tube d’aspirine ou un sachet de chips d’un sac, avec un taux de réussite de 70% — soit plus du double du taux de réussite observé pour une approche qui n’exploite pas l’audio (mais uniquement la vision), selon l’équipe. À noter que le dispositif était en revanche incapable de récupérer un morceau de tissu, celui-ci n’émettant aucun bruit à la manipulation.

Les données audio peuvent également servir à identifier la nature d’un objet. En effet, au cours d’une expérience complémentaire, l’équipe a montré que le robot était non seulement capable de repérer et d’extraire un objet bruyant, mais qu’il était également capable de distinguer deux de ces objets. Le robot devait reconnaître le contenu d’un sac « mystère » en fonction du son produit en laissant tomber le sac par terre : si ce dernier émettait un son métallique (sac rempli de vis), le robot devait le ramasser ; à l’inverse (sac rempli de cacahuètes), il devait le laisser en place. Sur les 20 essais réalisés, le robot a réussi 14 fois.

Les chercheurs soulignent que leur système affiche certaines limites, à commencer par une forte dépendance à la supervision humaine. En outre, un microphone unique ne fournit que des informations audio incomplètes. « Tout comme les humains ont deux oreilles, doter le robot de deux microphones pourrait lui permettre d’utiliser le son de manière plus avancée, par exemple pour localiser plus précisément un objet », expliquent-ils.

Quoi qu’il en soit, ces expériences prouvent que les informations audio peuvent s’avérer très utiles lorsque des robots doivent intervenir dans des environnements où leur visibilité est partiellement ou complètement occultée. D’autant plus que les microphones sont relativement peu coûteux par rapport aux capteurs tactiles.