Dans un article en préimpression publié le 10 février 2022, une équipe de chercheurs de l’UC Berkeley, de Waymo et de Google, présente un outil capable de proposer des versions virtuelles de notre environnement. Pour leur démonstration, les chercheurs ont choisi de reproduire un quartier entier de San Francisco.

Les recherches en question ont été publiées sur Arxiv, ce qui signifie qu’elles n’ont pas encore été validées par la communauté scientifique. De son côté, Waymo, entreprise spécialisée en véhicules autonomes, a déjà relayé les résultats de ce travail sur son site internet.

L’outil présenté dans l’application s’appelle Block-NeRF. Le NeRF, pour « Neural Radiance Field » (ou « champ de rayonnement neuronal » en français) est une méthode permettant de générer de nouvelles vues de scènes complexes. Le NeRF prend un ensemble d’images d’entrée d’une scène globale et la complète en liant différentes sous-scènes. « Nous présentons Block-NeRF. C’est une variante des Neural radiance fields, qui peut être utilisée pour créer des vues de synthèse d’environnements à grande échelle », peut-on ainsi découvrir sur la vidéo explicative de Waymo.

Très concrètement, dans le cas présent, l’équipe a utilisé la voiture autonome de Waymo, qui est allée photographier un quartier de San Francisco sous toutes ses coutures avec ses 12 caméras. En tout, 2.8 millions d’images ont été capturées sur une période de 3 mois — juin, juillet, et août 2021. Il a fallu pour cela 13 heures de conduite pour 1330 trajets.

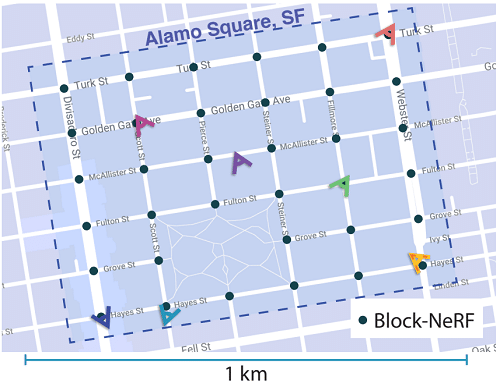

En combinant toutes ces images, les chercheurs sont parvenus à reproduire Alamo Square, le fameux quartier — qui fait environ un demi-kilomètre carré. Grâce au champ de rayonnement neuronal, une méthode particulière qui permet de synthétiser différentes vues, ils ont réussi à créer un modèle dans lequel il est possible de se « promener » virtuellement. En créant ainsi des modèles 3D, il devient même possible de regarder la ville depuis des points de vue qui n’ont finalement jamais été pris en photo pour la création initiale du modèle.

De nombreuses recherches sur le champ de rayonnement neuronal dans la reconstruction d’environnement précèdent celle-ci. Ce qui est particulier dans leur expérimentation, c’est surtout l’échelle. En effet, l’équipe souhaite pouvoir reproduire de vastes environnements. Cela représente un défi, puisque le chargement de telles zones peut être très lourd pour un ordinateur.

Décomposer la ville en blocs

C’est là qu’intervient leur notion de « Block-NeRF ». Ce que l’équipe appelle « block-nerves », ce sont de petites représentations 3D de scènes, obtenues à partir des images fixes. Ces « blocs » sont ensuite combinés entre eux pour créer une vue plus générale. Autrement dit, le quartier de San Francisco n’a pas été créé d’un seul tenant, mais repose au contraire sur plusieurs petits blocs. 35, pour être exact, qui couvrent toute sa surface. Ensemble, ils génèrent le rendu final.

« Nous démontrons que lors de la mise à l’échelle de NeRF pour rendre des scènes à l’échelle de la ville couvrant plusieurs blocs, il est essentiel de décomposer la scène en NeRF formés individuellement. Cette décomposition dissocie le temps de rendu de la taille de la scène, permet au rendu de s’adapter à des environnements arbitrairement grands, et permet des mises à jour par bloc de l’environnement », peut-on lire dans leur article. Autrement dit, si les « blocs » de quartier fonctionnent individuellement, il est possible de charger seulement ceux qui sont nécessaires pour afficher un point de vue donné. Le chargement est donc bien plus facile.

Le système est aussi plus souple, puisqu’on peut ajuster les données bloc par bloc sans retravailler tout le système. Chacun de ces blocs a été formé en utilisant entre 64 575 et 108 216 images différentes. Comme les photographies ont été prises dans différentes conditions, il est même possible de simuler dans cet environnement virtuel des conditions météorologiques variables, différents moments de la journée, etc.

Parmi les usages possibles figure la création de simulations pour tester les véhicules autonomes dans des environnements entièrement sécurisés. D’où, certainement, l’intérêt particulier de Waymo sur ces recherches. Le système doit cependant encore être amélioré. Les chercheurs relèvent notamment des zones floues ou des ombres par endroits, présentes parce qu’ils ont dû effacer numériquement les objets mouvants tels que les piétons ou les voitures.

La vidéo de démonstration :