Alors que les investissements dans l’IA enregistrent une croissance exponentielle, l’Union européenne (UE) veut instaurer « l’AI Act » (ou « loi sur l’IA »), un décret de réglementation majeur qui ambitionne de devenir une norme mondiale. Il vise en quelque sorte à garantir la transparence et le respect des droits fondamentaux pour l’ensemble des acteurs de la technologie. Cependant, alors que la proposition a pour objectif à terme de stimuler la croissance du secteur, elle intimide par sa complexité et ses nombreuses restrictions. Afin d’en comprendre les enjeux et les implications, nous avons décrypté le projet en consultant un expert.

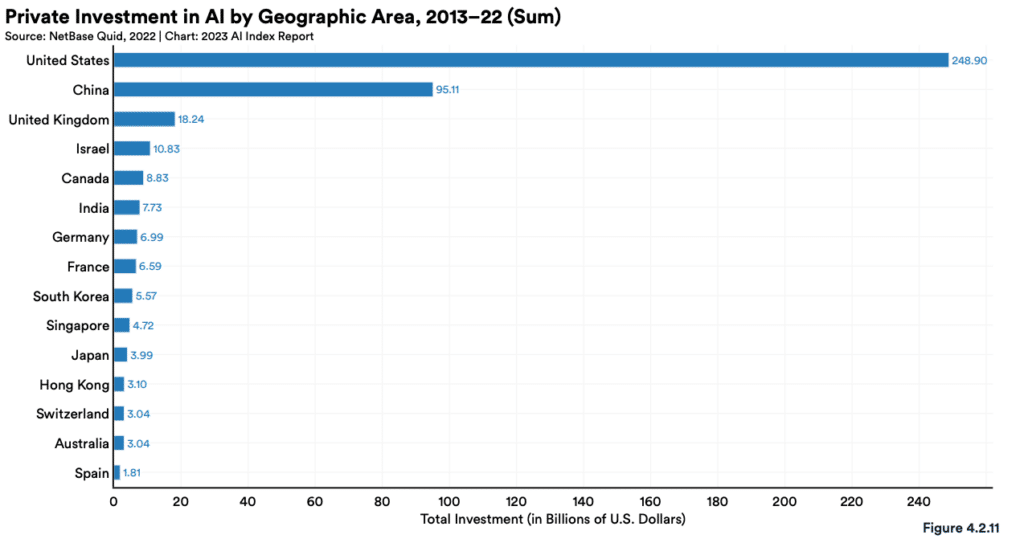

Au cours des dix dernières années, les investissements dans le secteur de l’IA ont considérablement augmenté. Dans l’UE, les investissements publics et privés dans le secteur approchent les 20 milliards d’euros par an. Cependant, le manque de synergie entre les États membres ralentit la gestion efficace de ces fonds, selon certains rapports. Ce manque de coordination entrave la croissance du secteur dans l’ensemble de la région. Alors qu’aux États-Unis les investissements privés totaux entre 2013-2022 atteignent presque 250 milliards de dollars, les chiffres ne s’élèvent par exemple qu’à 7 milliards en France et en Allemagne et à 3 milliards en Suisse.

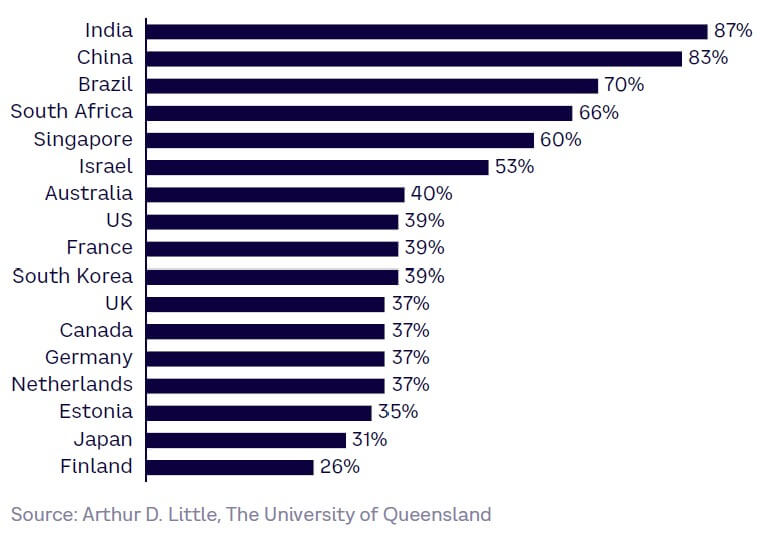

D’un autre côté, les pays de l’UE enregistrent une vitesse d’adoption de l’IA étonnamment faible en comparaison à d’autres pays. Cette vitesse dépend notamment de différents facteurs dépendant des secteurs d’activité et des cas d’utilisation, tels que le niveau de confiance en la technologie, l’intérêt, la capacité à l’utiliser, la facilité de mise en œuvre au sein de l’entreprise, etc.

Alors que dans les pays émergents le niveau de confiance en la technologie est le plus élevé au monde, il est surprenant que cet indicateur soit particulièrement bas dans les pays à revenu élevé. Par exemple, en Inde et en Chine, le niveau de confiance est de 87 % et 83 % (respectivement), tandis qu’il est seulement de 39 % et 37 % en France et en Allemagne respectivement, selon le cabinet de conseil en stratégie Arthur D. Little.

Cela concorde avec les données de l’Artificial Intelligence Index Report 2023, indiquant que le nombre d’entreprises d’IA créées en France entre 2013 et 2022 est de 338, tandis qu’elles s’élèvent à 245 en Allemagne. Les chiffres descendent à 108 en Suisse et à 78 aux Pays-Bas. En revanche, les États-Unis et la Chine enregistrent des chiffres impressionnants de 6043 et 1337 entreprises créées, respectivement !

Ce manque d’engouement de la part des pays de l’UE est probablement dû en partie aux nombreux risques liés à l’IA. Les dirigeants de l’Union prévoient de stimuler le secteur avec l’AI Act, qui vise à instaurer un écosystème technologique sûr et garantissant le respect des droits fondamentaux (conformément aux principes de l’UE). Il s’agit en quelque sorte d’instaurer un écosystème numérique transparent et d’établir des règles harmonisées pour la mise sur le marché, la mise en service et l’utilisation des systèmes d’IA. « L’objectif du projet est que sur le marché européen, les utilisateurs puissent avoir accès à des produits de confiance », a expliqué lors d’une interview avec Trust my Science Alain Bensoussan, juriste spécialisé en droit des technologies avancées et fondateur du cabinet Lexing.

Cependant, avant même que le décret ne soit officialisé, il intimide par sa complexité. Qui sera impliqué et qui sera protégé ? Une abondance de restrictions ne risque-t-elle pas de freiner les investissements au lieu de les promouvoir ? D’autant plus qu’en cas de manquement, des amendes administratives très élevées sont prévues. Toutefois, « en partageant la confiance entre tous les opérateurs et utilisateurs finaux, cette réglementation devrait plutôt être un accélérateur de déploiement », a déclaré Bensoussan en répondant à nos questions. « C’est la même logique que les médicaments et les dispositifs médicaux », a-t-il expliqué.

Alors que la France aurait tenté de freiner l’adoption du texte, le projet de loi a finalement été voté à l’unanimité et a été envoyé devant le Parlement européen. Il entrera en vigueur deux ans après sa finalisation — probablement au premier semestre de cette année, selon l’expert. Vous pouvez consulter un aperçu du texte complet ici.

Implication de tous les acteurs du secteur

Afin de comprendre l’AI Act, il faut d’abord distinguer les systèmes d’IA avancés des simples dispositifs automatisés et équipés de chatbots. Les premiers sont dotés d’un certain niveau d’autonomie leur permettant de produire des contenus et des stratégies complexes, tandis que les seconds sont par exemple introduits dans les systèmes GPS des véhicules autonomes, ou encore pour le traitement de commandes ou le service client de commerces en ligne.

Dans la plupart des pays dans le monde, il existe une juridiction pour la majorité des systèmes automatisés, mais agissant de manière relativement spécifique. Les robots autonomes sont par exemple régis par une convention internationale. En revanche, l’AI Act vise une application à l’ensemble des domaines impliquant l’IA, allant des simples systèmes automatisés aux plus avancés.

Les parties principalement impliquées sont le fournisseur (qui effectue la première mise sur le marché sous son nom ou sa marque), l’importateur ou le déployeur (l’entreprise qui distribue la marque auprès de ses clients ou qui la met en service), et l’utilisateur. Pour reprendre l’analogie des médicaments, les fournisseurs sont comparables aux laboratoires pharmaceutiques mettant un nouveau médicament sur le marché en y apposant leur marque. Les déployeurs sont les pharmacies et les utilisateurs sont les patients ainsi que les hôpitaux.

À noter toutefois que l’appartenance à une catégorie n’est pas immuable. Une entreprise de type déployeur pourrait par exemple être amenée à devenir fournisseur, en apposant son nom sur l’IA qu’il fournit ou en y apportant des modifications substantielles. Chaque partie prenante devra ainsi veiller scrupuleusement à respecter les termes du décret qui lui correspondent. En outre, « les organismes publics comme privés sont visés, mais uniquement pour les IA à usage professionnel », précise Bensoussan. En d’autres termes, le particulier est exclu de la réglementation s’il utilise un système d’IA à titre personnel ou dans son intérêt propre.

En cas de manquement aux termes du décret, les professionnels se verront obligés de payer une amende de 35 millions d’euros ou équivalant à 7 % du chiffre d’affaires annuel. En cas de non-respect des exigences de transparence, la sanction s’élèvera à 15 millions d’euros, ou 3 % du chiffre d’affaires annuel. Dans les cas où les informations fournies sont incorrectes ou inexistantes, la sanction prévue est de 7,5 millions d’euros ou 1 % du chiffre d’affaires.

Une approche basée sur les risques

Contrairement à la plupart des législations internationales sur l’IA, « il s’agit d’un principe de pilotage par les risques », nous explique l’expert. Cela signifie que les acteurs impliqués se verront dans l’obligation de gérer la technologie en fonction des risques qu’elle pourrait engendrer. Ces risques incluent tout ce qui touche à la santé, la sécurité, les droits fondamentaux, la démocratie, l’état de droit et l’environnement.

D’autre part, ces risques sont catégorisés selon quatre niveaux : les systèmes d’IA interdits, les systèmes d’IA à haut risque, les systèmes d’IA transparents et les systèmes d’IA exclus. La première catégorie inclut les IA pouvant générer des suites d’idées complexes dépassant la conscience de l’utilisateur, c’est-à-dire qui utilisent des techniques délibérément manipulatrices pouvant altérer sa capacité à prendre des décisions réfléchies. Les systèmes ciblant et exploitant spécifiquement les handicaps physiques et intellectuels des utilisateurs seront également interdits.

En outre, le décret met l’accent sur l’interdiction dans les lieux publics de systèmes de notation sociale (basés par exemple sur le genre ou l’origine ethnique) et d’identification biométrique en temps réel. De telles IA ont cependant déjà été déployées en Chine : des logiciels de reconnaissance notamment, exploitant les centaines de millions de caméras surveillant la population à travers tout le pays. Cela est contraire aux principes d’État de droit.

Quant aux IA à haut risque, il s’agit de celles présentant des risques significatifs de préjudice pour la santé, la sécurité ou les droits fondamentaux des personnes physiques. Elles incluent par exemple les algorithmes utilisés dans les systèmes de santé ou dans les systèmes de recrutement. « Les IA à haut risque seront contraintes d’avoir un marquage CE pour être vendues en Europe », explique Bensoussan. Le marquage « CE » figure sur la majorité des produits non alimentaires et souligne l’engagement du fabricant du produit sur sa conformité aux exigences fixées par la réglementation locale ou régionale.

Les IA exclues sont celles qui ne sont ni soumises à des obligations de transparence ni à des obligations de management des risques. Elles concernent par exemple les systèmes d’IA militaires qui ne relèvent pas de la juridiction de l’UE. Les IA transparentes sont quant à elles celles n’enfreignant aucune des réglementations du décret. « Parmi les avantages attendus, il y a la protection des victimes, en l’occurrence les citoyens de l’UE en cas de défaillance des IA ou de comportements qui deviennent difficiles à maîtriser », précise l’expert.

Un vérificateur de conformité est disponible en ligne. Il permet notamment d’estimer à quelle catégorie de risque correspond un système d’IA donné. Accessible ici.

Un accélérateur d’investissements ?

Cependant, la complexité et les restrictions du décret pourraient s’avérer être des failles à son adoption, ainsi qu’à son objectif d’accélérer les investissements dans l’IA dans les pays de l’UE. « Il y a deux logiques comme toujours : il faut qu’il soit suffisamment protecteur pour les citoyens. Dans ces cas-là, plus ils sont en confiance, plus ils utiliseront de produits », explique Bensoussan. « Puis, il y a le coût de cette régulation, qui peut empêcher les petites entreprises d’accéder au marché », ajoute-t-il.

Néanmoins, la réglementation du secteur est considérée comme une préoccupation immédiate par l’ensemble des acteurs et des décideurs. D’autre part, des dérogations spéciales sont prévues pour les petites entreprises ainsi que pour l’innovation, de sorte qu’elle ne soit pas entravée. Dans ce sens, l’AI Act a le potentiel de redéfinir le marché, d’influencer le rythme d’innovation et d’adoption, non seulement sur le territoire de l’UE, mais également au niveau mondial.

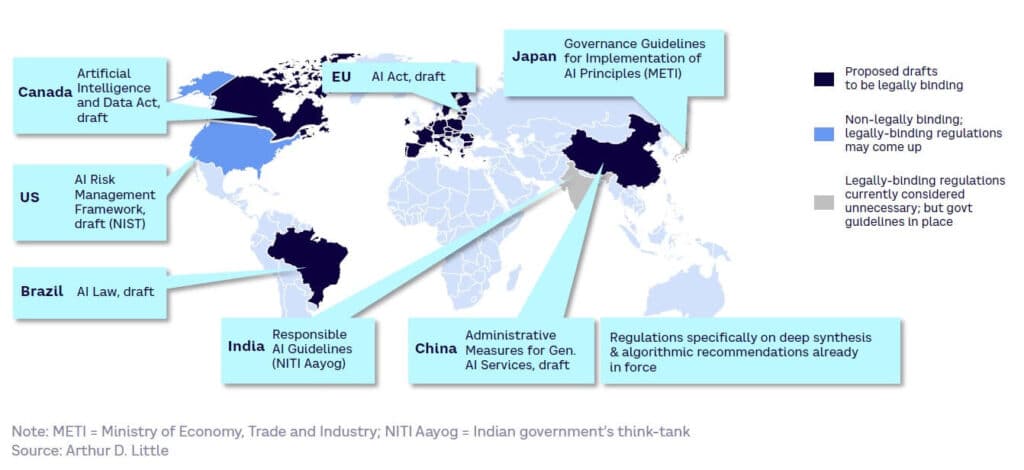

« Je pense que c’est un excellent règlement qui deviendrait un standard mondial en créant des principes mondiaux de régulation », estime le juriste. Ce dernier a évoqué un effet similaire à celui du RGPD (Règlement général sur la protection des données) de l’UE, qui constitue une référence internationale en matière de réglementation sur la confidentialité des données. Sans compter que d’autres réglementations sont en cours d’élaboration dans le monde. Cependant, l’AI Act semble se concrétiser plus rapidement.

Traduction des légendes (de haut en bas) :

- Le projet proposé est juridiquement contraignant

- Non contraignant juridiquement, mais le juridiquement contraignant peut être envisagé

- Les réglementations juridiquement contraignantes sont actuellement considérées comme inutiles, mais une ligne directrice du gouvernement est en place

Cependant, il est important de noter que le décret ne traite pas directement des principales craintes liées à l’IA, telles que la propagation de la désinformation (étant donné qu’une personne propageant de fausses informations avec l’IA est exclue de la réglementation, tant que ce n’est pas dans un but professionnel) et la perte des emplois. Cela concorde-t-il avec le respect des droits fondamentaux garanti par l’État de droit ? Selon Bensoussan, le premier est régi par d’autres textes du Code pénal, tandis que pour le second, les IA en ressources humaines, par exemple, sont considérées par le décret comme à haut risque.

Toutefois, cela est loin d’être rassurant, car la plupart des prestations intellectuelles dans le monde continuent d’être affectées par la technologie, comme nous l’avons rapporté dans un précédent article d’investigation intitulé IA générative — les emplois à risque et les opportunités professionnelles à l’horizon 2030. « Moi je préconise une taxe sur les IA. La valeur qu’on va pouvoir dégager grâce à IA, il faut qu’elle aille aussi aux personnes qui ont perdu leur emploi », conclut Bensoussan.