L’intelligence artificielle ChatGPT a énormément fait parler d’elle au cours de ces derniers mois. Et si l’on pouvait désormais la recréer chez soi, pour un coût dérisoire ? Un groupe de chercheurs de l’Université de Stanford l’a fait en un temps record.

Bonne ou mauvaise nouvelle, cela reste à démontrer. Une chose est sûre : il semble que le « génie de la lampe » se soit échappé, comme le titre le New Atlas dans un article récent. Une équipe de scientifiques de l’Université de Stanford a réussi à créer un modèle conversationnel qu’ils estiment équivalent à ChatGPT… en utilisant les compétences de ce dernier. Pour rappel, ChatGPT est une intelligence artificielle (IA) conversationnelle : concrètement, il s’agit d’un programme capable de générer des réponses écrites à des requêtes formulées par un utilisateur humain. Ce programme, comme d’autres IA, a été entraîné à partir de données « exemples » qu’il a analysées, et devient de plus en plus fin à mesure qu’il analyse de nouvelles requêtes.

C’est donc ce processus d’entraînement qui constitue en grande partie le « secret » des performances d’une IA. ChatGPT s’est ainsi révélé capable dernièrement de rédiger des réponses très précises à des questions complexes, mais aussi d’écrire du code informatique, de répondre à des sujets d’examens, de rédiger des articles scientifiques, littéraires… Actuellement, ces IA sont surtout développées par de grandes entreprises, telles qu’OpenAI pour ChatGPT, ou encore Google pour son collègue nommé « Bard ». Les données de recherche rendues publiques par les scientifiques de l’Université de Stanford pourraient bien désormais permettre à toute personne qui possède quelques compétences sur le sujet de développer son propre « ChatGPT » pour un tarif dérisoire.

De l’aveu même de l’université, cette nouvelle possibilité présente des risques. « Toute diffusion comporte un certain risque. (…) cela permet à un plus grand nombre de personnes (y compris de mauvais acteurs) de créer des modèles susceptibles de causer des dommages (intentionnellement ou non) », affirment ainsi les scientifiques dans un communiqué sur le sujet. On peut facilement imaginer qu’un « ChatGPT » à qui l’on poserait peu de limites pourrait servir à usurper des identités, tenir des propos haineux, faciliter des opérations de fishing…

Si les chercheurs ont décidé de donner tout de même accès à leurs recherches, c’est parce qu’ils estiment nécessaire de faciliter la recherche sur les IA à la communauté scientifique. « Nous pensons que la mise à disposition des ressources susmentionnées permettra à la communauté universitaire d’effectuer des études scientifiques contrôlées sur ces modèles linguistiques, ce qui permettra d’améliorer la science et, en fin de compte, de mettre au point de nouvelles techniques pour remédier aux insuffisances actuelles de ces modèles ». Selon eux, les bénéfices de cette diffusion l’emportent donc sur les risques qu’elle implique, d’autant plus que la communauté universitaire « a désormais les moyens d’effectuer des recherches plus approfondies sur la sécurité de ces modèles ».

Faut-il démocratiser l’intelligence artificielle ?

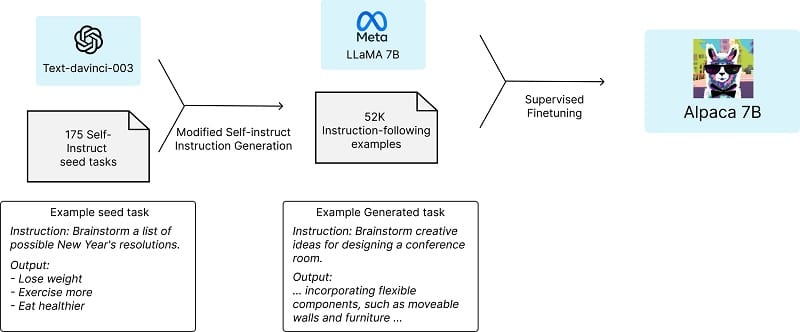

Le point qui attire tout particulièrement l’attention n’est pas tant le fait que ces chercheurs aient pu créer un équivalent de ChatGPT, mais plutôt la facilité de leur « recette ». Pour créer leur IA, ils sont partis d’une base existante : Llama 7B, un modèle conversationnel créé par Meta. Il s’agit d’une IA similaire, dans l’idée, à ChatGPT, mais avec des performances bien moindres. C’est cette première version qu’ils sont parvenus à améliorer en utilisant les capacités de ChatGPT. En effet, ils ont demandé à cette dernière de générer de nouvelles données d’entraînement à partir de 175 paires instructions/réponses écrites par des humains. Les scientifiques ont ainsi obtenu 52 000 nouveaux exemples qu’ils ont pu utiliser pour affiner les réglages de Llama 7B. Un processus qui a pris seulement trois heures en utilisant 8 ordinateurs capables d’effectuer ces calculs.

Une fois Alpaca « né », ils l’ont mis à l’épreuve en faisant passer différents types de tests à Alpaca et à ChatGPT simultanément. Les deux ont obtenu des résultats similaires, même si les chercheurs reconnaissent que leurs tests peuvent avoir leurs limites. En tout, créer cette nouvelle IA similaire à ChatGPT leur aura donc coûté 600 $. Toutefois, 500 $ ont été dédiés à la création des données d’entraînement : or, ils ont également rendu disponibles ces 52 000 paires. Les 100 $ restants sont liés à l’intégration des données par Alpaca.

I don't know what to make about this development. Alpaca is surprisingly very good. The claim here is the training can be done in 5 hours on a single RTX 4090. Have GPT-like models been democratized overnight?! https://t.co/ysfn5u6xwI

— Carlos E. Perez (@IntuitMachine) March 16, 2023

Reste-t-il donc des « barrières » pour qui voudrait les imiter et créer une IA similaire à ChatGPT ? Bien entendu, les 8 ordinateurs utilisés peuvent encore constituer un frein financier. Peut-être pas pour longtemps, cependant… Un groupe qui s’est penché sur ces données affirme déjà avoir créé du code pouvant s’exécuter sur un Raspberry Pi (du matériel très accessible) et avoir complété le processus de formation en cinq heures, sur une seule carte graphique NVidia RTX 4090 haut de gamme. Tout cela a été rendu accessible sur Github. « Les modèles de type GPT se sont-ils démocratisés du jour au lendemain ?! », s’étonne un internaute sur Twitter devant ces affirmations.

Techniquement, des particuliers qui s’essaieraient à cet exercice dans un but commercial seraient dans l’illégalité. « Nous insistons sur le fait qu’Alpaca est destiné uniquement à la recherche universitaire et que toute utilisation commerciale est interdite », soulignent les chercheurs. « Premièrement, Alpaca est basé sur LLaMA, qui a une licence non commerciale (…). Deuxièmement, les données d’instruction sont basées sur le texte-davinci-003 d’OpenAI, dont les conditions d’utilisation interdisent de développer des modèles qui concurrencent OpenAI. Enfin, nous n’avons pas conçu de mesures de sécurité adéquates, de sorte qu’Alpaca n’est pas prêt à être déployé pour un usage général ».

Reste à savoir si des limites légales seront suffisantes pour décourager ceux qui voudraient s’essayer au développement d’IA de cette façon. Notons que le modèle de Llama tout entier a déjà fuité sur le site 4Chan, quelques jours à peine après l’annonce faite par Meta qu’il serait réservé au monde de la recherche. Il existe une version de démonstration d’Alpaca ouverte au public, mais elle n’était pas accessible à l’heure où nous écrivions cet article.