Une équipe de chercheurs de l’Université de Stanford et de Google a mené une expérience visant à étudier comment des « agents génératifs » parviennent à s’adapter à un environnement virtuel interactif, de type « bac à sable », inspiré du célèbre jeu Sims. Il s’avère que ces agents ont finalement adopté un comportement relativement proche de celui des humains.

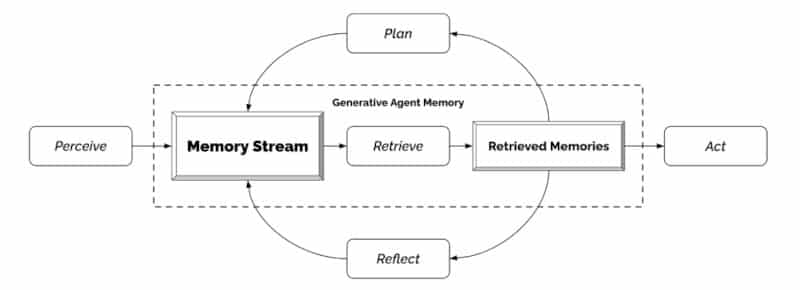

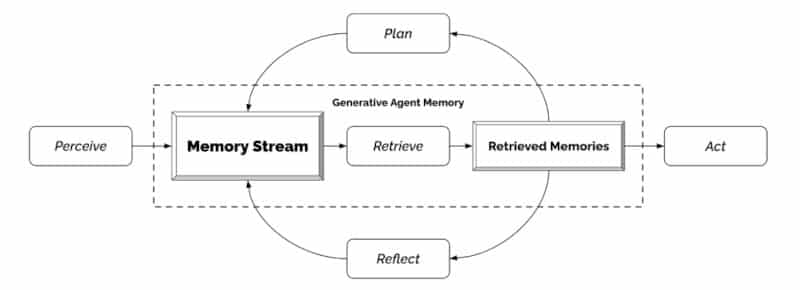

Dans le cadre de cette expérience, les chercheurs ont formé 25 agents génératifs avec différentes identités, en utilisant le modèle de langage étendu GPT-3.5 d’OpenAI. Ils les ont ensuite introduits dans une ville virtuelle, baptisée Smallville, comprenant des maisons, des commerces, un parc, une école, un bar, etc. ; les utilisateurs finaux pouvaient interagir avec eux en utilisant le langage naturel. « [Notre architecture] étend un grand modèle de langage pour stocker un enregistrement complet des expériences de l’agent utilisant le langage naturel, synthétiser ces souvenirs au fil du temps dans des réflexions de plus haut niveau, et les récupérer dynamiquement pour planifier le comportement », écrivent les chercheurs.

Finalement, ces 25 avatars pilotés par IA se sont comportés quasiment comme des humains. Les chercheurs rapportent en effet « des comportements sociaux individuels et émergents crédibles ». À titre d’exemple, à partir d’une seule notion spécifiée par l’utilisateur — à savoir qu’un agent souhaite organiser une fête pour la Saint-Valentin — les agents ont diffusé de manière autonome des invitations à la fête au cours des deux jours suivants, se sont invités mutuellement à la fête et se sont coordonnés pour s’y présenter ensemble, au bon moment, relate l’équipe.

Des agents capables de s’adapter aux changements de leur environnement

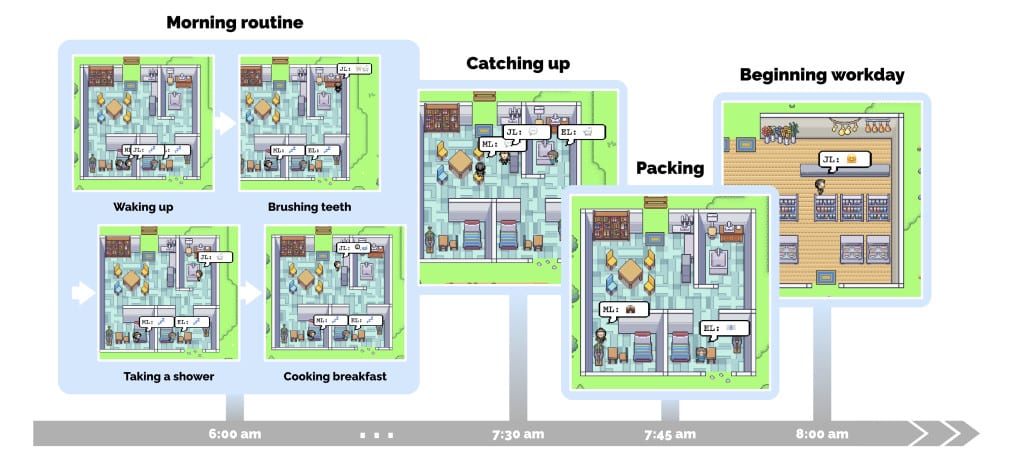

Pour chacun des agents, les chercheurs ont rédigé un paragraphe en langage naturel décrivant son identité, y compris sa profession, ses traits de personnalité et ses relations avec d’autres agents, en tant que base mémoire. Les agents génératifs se sont tout à fait adaptés à leur environnement, simulant une vie quotidienne typique et respectant un emploi du temps : réveil, préparation du petit-déjeuner, travail. Chacun s’est livré aux activités propres à sa profession. Ils se sont remarqués les uns les autres, ont entamé des conversations (en communiquant en langage naturel) et se sont même forgé des opinions.

Dans un exemple d’interactions, les chercheurs relatent un échange entre plusieurs membres d’une même « famille », au cours duquel le père a résumé à sa femme l’échange qu’il venait d’avoir avec son fils. Deux autres avatars ont discuté des prochaines élections de la ville. « Pour être honnête, je n’aime pas Sam Moore. Je pense qu’il est déconnecté de la communauté et qu’il n’a pas nos intérêts à cœur », a déclaré l’un des agents à qui un autre demandait ce qu’il pensait du candidat à la mairie.

Les utilisateurs finaux avaient la possibilité de remodeler l’environnement d’un agent en réécrivant en langage naturel l’état des objets qui l’entouraient. Par exemple, lorsque l’avatar nommé Isabella préparait son petit-déjeuner le matin, l’utilisateur a changé l’état de la cuisinière de « allumée » à « en feu » en entrant la commande adéquate ; Isabella s’en est aperçu dans l’instant, puis a éteint la cuisinière et refait son petit-déjeuner. De même, en définissant l’état de la douche d’Isabella en « fuite d’eau » lorsqu’elle entre dans la salle de bain, cette dernière récupère des outils et essaie de réparer la fuite.

Les agents ont rapidement présenté des comportements sociaux émergents : en interagissant les uns avec les autres, ils ont échangé et diffusé des informations, rencontré de nouvelles personnes et noué de nouvelles relations ; ils ont également réussi à réutiliser les informations obtenues et à se coordonner autour de certaines activités.

De « petits pas » vers l’intelligence artificielle générale ?

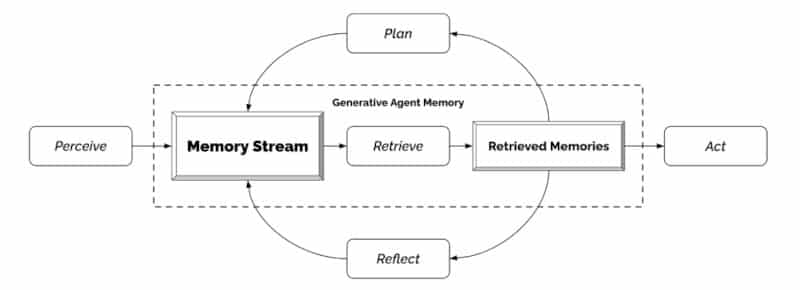

L’équipe explique qu’à mesure qu’un agent perçoit son environnement, toutes les perceptions sont sauvegardées dans un registre complet d’expériences appelé « flux de mémoire ». Sur la base de ces perceptions, l’architecture récupère les souvenirs pertinents, puis les utilise pour déterminer une action. Ces souvenirs sont également utilisés pour former des plans à plus long terme et pour créer des réflexions de plus haut niveau, qui sont enregistrées dans le flux de mémoire en vue d’une utilisation ultérieure.

« Les composants de notre architecture d’agent — observation, planification et réflexion — contribuent tous de manière essentielle à la crédibilité de son comportement », soulignent les auteurs. « Nous pensons que les agents génératifs peuvent jouer un rôle dans de nombreuses applications interactives, allant des outils de conception aux systèmes informatiques sociaux et aux environnements immersifs », concluent-ils.

Le modèle n’était toutefois pas infaillible ; les chercheurs rapportent que les agents agrémentaient parfois leurs connaissances par « des hallucinations » et qu’ils oubliaient certains événements. L’équipe souligne par ailleurs que l’expérience a été menée sur une courte période (2 jours) et que d’autres recherches devraient examiner le comportement des agents sur une plus longue durée pour bien cerner leurs capacités et leurs limites. Il sera également essentiel de tester leur robustesse face à des attaques de type prompt hacking ou memory hacking.

En attendant, ces résultats montrent comment le modèle d’IA générative derrière ChatGPT peut être utilisé au-delà de son application en tant qu’assistant virtuel, a déclaré à Insider Michael Wooldridge, professeur d’informatique à l’Université d’Oxford qui étudie l’IA et qui n’a pas participé à l’étude. Il a ajouté que cette expérience constituait « de petits pas » vers la réalisation de « l’intelligence artificielle générale » — un stade hypothétique où les outils d’IA seront capables d’afficher des comportements humains complexes, tels que la conscience. Mais avant d’atteindre cet objectif, « le chemin à parcourir est encore long, très long », a-t-il ajouté.