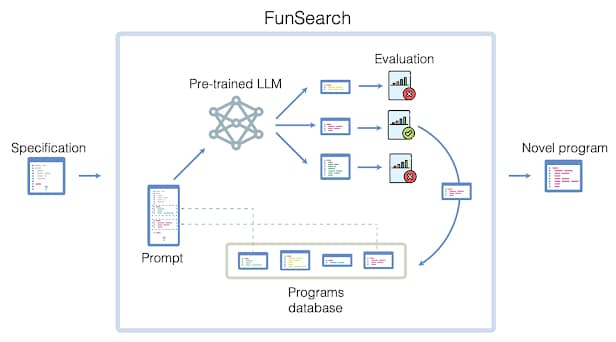

FunSearch, une nouvelle IA développée par Google DeepMind serait la première à se montrer suffisamment fiable pour réaliser des découvertes mathématiques. Cette fiabilité serait due au fait que les résultats inutiles ou erronés sont filtrés par un système « anti-hallucinations » intégré, augmentant ainsi radicalement la qualité des réponses. Le système combine un grand modèle de langage (LLM) préformé — dont l’objectif est de fournir des solutions mathématiques sous forme de code informatique — à un « évaluateur » automatisé, qui analyse la fiabilité des solutions — ce qui permettrait de fortement réduire les hallucinations.

Les derniers outils d’IA développés par Google DeepMind, tels que GNoME, ont montré d’impressionnantes capacités en raison de leur spécificité. En étant formé sur des ensembles de données précises couvrant un domaine spécifique (tel que la chimie), ce type de modèle est moins susceptible de générer des erreurs que les LLM généralisés, tels que ChatGPT ou Gemini. Ces derniers sont notamment formés sur de grands ensembles variés de données (et non limités à un domaine), ce qui les rend fréquemment sujets aux hallucinations. Gemini a par exemple généré une réponse erronée lorsqu’un internaute lui a demandé qui étaient les gagnants des Oscars de cette année. Leur utilisation pour la résolution de problèmes complexes ou pour des découvertes scientifiques constitue ainsi un défi majeur.

D’un autre côté, des experts suggèrent que les LLM ne devraient pas être critiqués pour leur propension à générer des hallucinations, car leur mode de fonctionnement ne différerait pas de celui par lequel les scientifiques résolvent les problèmes la plupart du temps. À l’instar des systèmes d’IA, ces derniers mènent généralement leurs recherches par le biais de processus de réflexion aboutissant à de nombreuses idées, qui peuvent être à la fois utiles ou non. Les futures avancées en matière de LLM ne se baseront ainsi pas sur la taille des modèles, mais plutôt sur leur capacité à générer des réponses fiables — ou à filtrer les réponses peu fiables.

Des chercheurs ont récemment suggéré que la solution aux hallucinations serait d’appuyer les LLM sur un système annexe vérifiant la fiabilité des sorties générées avant de les transmettre à l’utilisateur. Cependant, cela représenterait un projet colossal, étant donné la diversité de sujets que les chatbots généralisés doivent maîtriser. Avec leur nouvel outil, FunSearch, les ingénieurs de Google DeepMind ont fait un premier pas significatif dans ce sens.

FunSearch comprend un LLM préformé associé à un système d’évaluation automatisé. Il atteindrait ainsi une fiabilité lui permettant de résoudre des problèmes mathématiques complexes. Selon l’entreprise, cette tâche est plus facile à gérer car les solutions générées sont intrinsèquement et rapidement vérifiables. En outre, les deux composants du modèle permettraient de faire évoluer les solutions proposées, de sorte à parfois aboutir à des découvertes scientifiques. Le fonctionnement de l’outil est décrit en détail dans la revue Nature.

Des boucles de rétroaction permettant d’éviter les hallucinations

Basé sur le modèle PaLM2, FunSearch est encore sujet aux hallucinations sans son système « évaluateur ». Les chercheurs estiment que jusqu’à 90% des résultats dans le cadre de la résolution d’un problème complexe sont inutiles ou incorrects. Afin de sélectionner les réponses correctes, le système complet (avec évaluateur) commence par recevoir en entrée le problème à résoudre et une solution basique pour le code source. À partir de cette base, il génère un ensemble de nouvelles solutions dont l’exactitude est vérifiée par l’évaluateur. Ce dernier fournit alors les meilleures options, qui sont à nouveau introduites dans la boucle avec une invite demandant de les améliorer. Selon Google DeepMind, ce processus de boucle de rétroaction permet de produire des millions de solutions potentielles, qui finissent par converger vers un résultat dont la fiabilité peut surpasser la solution la plus connue.

Plus précisément, l’utilisateur commence par rédiger une description du problème à résoudre, sous forme de code informatique. Cette description incluait dans ces essais une procédure visant à évaluer des programmes, ainsi qu’un programme d’amorçage utilisé pour initialiser un autre groupe de programmes. C’est-à-dire que le modèle écrit des programmes informatiques pour fournir les solutions, plutôt que d’essayer de résoudre le problème directement.

Le système sélectionne ensuite un sous-ensemble programmes considérés fiables, qui sont transmis au LLM. Ce dernier s’appuie sur cette sélection pour générer de nouveaux programmes, qui sont automatiquement évalués. Les meilleurs, sélectionnés par l’évaluateur, sont alors réintroduits dans une boucle d’auto-amélioration. À noter que bien que FunSearch soit basé sur PaLM 2, il est compatible avec d’autres LLMs formés au code.

En outre, l’aspect évolutif du système pourrait ouvrir la voie à de potentielles découvertes mathématiques. « Au lieu de repartir de zéro, nous commençons le processus évolutif avec une connaissance commune du problème et laissons FunSearch se concentrer sur la recherche des idées les plus critiques pour réaliser de nouvelles découvertes », a expliqué le groupe d’ingénieurs sur le blog de l’entreprise.

Résolution de problèmes mathématiques complexes

Les chercheurs de Google DeepMind ont éprouvé leur nouveau système en le mettant au défi de trouver de solutions pour le « problème du capuchon » (ou cap-set problem). Il s’agit de trouver des ensembles de points dans une grille de grande dimension, où trois points ne doivent jamais former de ligne droite. Les calculs de FunSearch ont débouché sur 512 points en huit dimensions, soit le plus grand ensemble jamais trouvé pour ce problème. « Il s’agit des premières découvertes faites pour des problèmes ouverts établis à l’aide de LLMs », ont écrit les chercheurs dans leur document d’étude.

Le second défi était de résoudre le problème de « conditionnement des bacs » (ou binpacking), consistant à ranger des objets de différentes tailles dans un nombre minimum de boîtes. FunSearch a généré des résultats surpassant ceux des algorithmes couramment utilisés pour la résolution de ce type de problème. Cela pourrait lui permettre d’être directement applicable aux secteurs du transport et de la logistique.

À noter que d’autres approches d’IA telles que les réseaux neuronaux et l’apprentissage par renforcement pourraient également surmonter ce type de défis. Cependant, leur déploiement nécessiterait d’importantes ressources. FunSearch, quant à lui, fonctionne par le biais de codes informatiques qui pourraient être facilement inspectés et déployés, selon les ingénieurs de Google.