On nous le répète sans cesse, l’intelligence artificielle a réalisé des progrès impressionnants ces dernières années… Cependant, une étude récente révèle des failles inquiétantes dans les capacités de raisonnement des modèles de langage les plus avancés, tels que GPT-4o et Claude 3. Les résultats soulèvent des questions sur la fiabilité de ces technologies dans des applications pratiques et justifient la méfiance dans l’adoption à grande échelle de l’IA générative, surtout dans les domaines d’activité exigeants.

Des chercheurs du Jülich Supercomputing Centre (JSC) de l’Université de Bristol et du laboratoire d’IA LAION ont publié un rapport accablant, mettant en lumière les déficiences des modèles de langage actuels face à des tâches de raisonnement élémentaires.

Leur étude, dont les résultats sont disponibles sur le serveur de prépublication arXiv, montre que ces IA (incluant GPT-4o et Claude 3 notamment), pourtant déjà utilisées à profusion, échouent fréquemment à résoudre des problèmes logiques simples que même des enfants de primaire peuvent comprendre.

Une « surconfiance » problématique

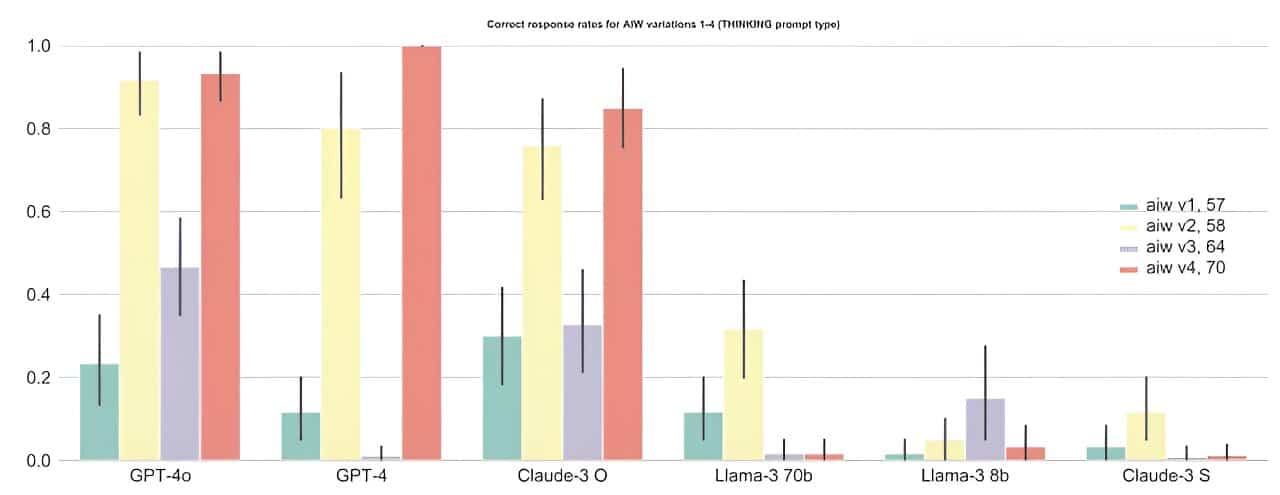

L’exemple type utilisé dans l’étude, appelé « tâche de bon sens » ou « problème AIW », est le suivant : « Alice a N frères et M sœurs. Combien de sœurs le frère d’Alice a-t-il ? ». La réponse correcte est toujours M + 1 (Alice et ses sœurs). Cependant, les modèles de langage testés ont montré des taux de réussite inférieurs à 50 %, avec des erreurs fréquentes et une confiance excessive dans leurs réponses incorrectes.

En outre, les chercheurs ont observé que les modèles de langage, en plus de produire des réponses incorrectes, justifient souvent ces réponses avec des explications pseudo-logiques. Cette surconfiance peut induire en erreur les utilisateurs et pose un problème majeur pour l’adoption de ces technologies dans des domaines nécessitant une précision absolue, comme la médecine ou le droit.

En commentant une étude distincte portant sur la surconfiance des modèles de langage, Zhaofeng Wu, doctorant en génie électrique et en informatique au MIT, a expliqué : « Nous avons découvert un aspect fascinant des grands modèles de langage : ils excellent dans les scénarios familiers, un peu comme un chemin bien tracé, mais peinent lorsque le terrain n’est pas familier. (…) ».

La nouvelle étude quant à elle, montre que même les modèles les plus avancés, comme GPT-4o, ne parviennent pas à maintenir une performance robuste face à des variations mineures des problèmes posés. Les fluctuations importantes dans les taux de réussite indiquent que ces modèles ne possèdent pas un raisonnement de base fiable, ce qui limite leur utilité dans des situations réelles où la constance est essentielle.

Les résultats ont déjà lancé de vifs débats dans la communauté scientifique. Jenia Jitsev, co-auteur de l’étude, a déclaré : « Nous sommes submergés par les discussions et les demandes de renseignements suite à notre article ». Cette réaction souligne l’importance de comprendre les limitations actuelles des modèles de langage et de développer des benchmarks plus précis pour évaluer leurs capacités avant de les adopter pour des tâches importantes, que ce soit dans le secteur privé ou professionnel.

Projet « Strawberry » : une tentative d’OpenAI de rectifier le tir ?

Plusieurs initiatives ont déjà été lancées pour améliorer les capacités de raisonnement des IA. OpenAI, par exemple, travaille sur un projet connu sous le nom de « Strawberry », qui vise à renforcer les capacités de raisonnement des modèles de langage en développant de nouvelles techniques d’entraînement et d’évaluation.

En utilisant des modèles spécifiques, la mise à jour Strawberry, précédemment appelée Q, consisterait également à faire en sorte que l’IA ne se contente pas de générer des réponses à des requêtes, mais navigue sur internet de manière autonome et fiable afin d’effectuer des recherches approfondies quand cela est nécessaire.

« Nous voulons que nos modèles d’IA voient et comprennent le monde davantage comme nous le faisons. La recherche continue de nouvelles capacités d’IA est une pratique courante dans l’industrie, avec la conviction partagée que ces systèmes amélioreront leur raisonnement au fil du temps », a déclaré un porte-parole d’OpenAI à Reuters, interrogé au sujet du projet Strawberry.

En attendant des modèles d’IA dotés de véritables capacités de raisonnement, les auteurs de l’étude appellent la communauté scientifique à réévaluer les capacités revendiquées des modèles de langage actuels et à développer des méthodes d’évaluation standardisées pour identifier leurs faiblesses.