Des systèmes d’intelligence artificielle (IA) capables de réaliser plus de 600 tâches, de coder des programmes informatiques de haut niveau, de décrypter des textes anciens, de créer des oeuvres artistiques de qualité… Du côté des systèmes d’IA à utilisation générale, DeepMind (de Google) fait une fois de plus parler d’elle avec un nouveau système capable d’apprendre à jouer au football en équipe en seulement 3 semaines. Il s’agit d’un véritable exploit dans le domaine de l’IA, car combiner l’apprentissage du contrôle des mouvements des articulations au fait d’anticiper un comportement censé servir un objectif collectif à long terme est un défi de longue date. Pour cela, l’IA a dû apprendre l’équivalent de 20 à 30 ans de matchs en simulation pour imiter parfaitement les mouvements de vrais joueurs et maîtriser des jeux d’équipe complexes, grâce à un modèle d’apprentissage appelé « Probabilités motrices neurales primitives (NPMP) ».

Il y a environ cinq ans, DeepMind a tenté d’apprendre à une de ses IA à traverser un parcours d’obstacles. Les chercheurs ont alors découvert que le système d’apprentissage par renforcement par essais et erreurs était le plus efficace pour obtenir le maximum de mouvements coordonnés. Cependant, ils ont remarqué qu’une très grande quantité de données était nécessaire pour que l’humanoïde virtuel puisse se mouvoir correctement. Sans connaissances de base sur la force à appliquer au niveau de chaque articulation, l’humanoïde virtuel ne pouvait effectuer que des secousses aléatoires avant de brusquement tomber au sol. Par suite, quand l’IA a finalement appris à se déplacer à travers le parcours d’obstacles, ses mouvements étaient encore trop saccadés pour pouvoir être appliqués à des domaines réels comme la robotique.

Une nouvelle étude, décrite dans la revue Science Robotics, expose comment le système NPMP est capable résoudre ces deux inconvénients, en impliquant un apprentissage automatique guidé par des modèles de mouvements naturels dérivés d’humains et d’animaux. « Nous discutons également de la manière dont cette même approche permet la manipulation humanoïde du corps entier à partir de la vision », expliquent les chercheurs dans un communiqué.

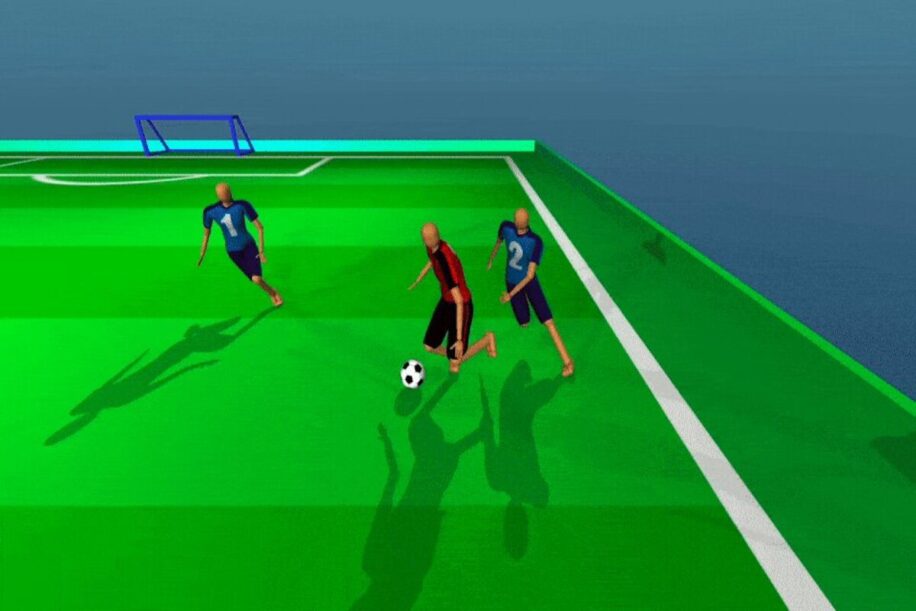

Les premières simulations ont été effectuées avec un modèle d’humanoïde portant et déplaçant un objet. Les tests d’application pour le contrôle robotique dans le monde réel ont été simulés avec un robot driblant une balle. Ces apprentissages ont ensuite permis à l’IA d’apprendre à jouer (virtuellement) au football, un jeu nécessitant des compétences individuelles et un jeu d’équipe coordonné. Tels des enfants grandissant en accéléré, « ils apprennent d’abord à marcher, puis ils apprennent à dribler, puis à faire jouer en un contre un ou deux contre deux », explique Guy Lever, co-auteur principal de la nouvelle étude et chercheur chez DeepMind.

Une vidéo montrant comment l’IA de DeepMind a appris à jouer au football. © New Scientist

Apprentissage étape par étape

La première phase de la conception du programme a été de pouvoir apprendre aux humanoïdes à courir avec les mouvements les plus naturels possibles, en imitant ceux de footballeurs filmés au préalable. La seconde étape a été d’apprendre à dribbler et passer le ballon, ou marquer un but. Au total, ces deux premières étapes représentent un an et demi de formation sportive, et l’IA l’a appris en seulement 24 heures.

La troisième étape consistait à apprendre aux humanoïdes à marquer des buts dans le cadre de matchs à deux contre deux. Cette phase nécessite une coordination de groupe, une anticipation de l’endroit d’où proviennent les passes, un partage des tâches, des prises de décision rapides, etc. Ces compétences ont été acquises par l’IA en seulement deux à trois semaines, et seraient équivalentes à 20 à 30 ans de matchs.

L’ensemble de ces apprentissages a permis de faire passer les humanoïdes de simples « poursuiveurs de ballons » à des équipes complexes et coordonnées. Selon les chercheurs, les comportements coordonnés apparaissent progressivement quand les équipes (virtuelles) sont amenées à entrer en compétition.

Perspectives d’utilisation

Sur le long terme, ce système NPMP pourrait être utilisé pour contrôler les mouvements de vrais robots. Des comportements et des mouvements bien coordonnés sont en effet nécessaires pour qu’ils puissent par exemple se déplacer sur des terrains accidentés ou manipuler des objets fragiles. Le manque de coordination augmenterait le risque de dommages autant pour les robots eux-mêmes que pour leur environnement.

Toutefois, le temps d’apprentissage nécessaire pourrait encore retarder ces possibilités d’application. Cependant, les ingénieurs de DeepMind ont déjà commencé à enseigner à de véritables robots à pousser une balle vers une cible en utilisant le même système NPMP. Le premier pas vers la première équipe de (vrai) football entièrement composée de robots humanoïdes ?