Une récente étude publiée par des chercheurs de Google DeepMind sur le serveur de prépublication arXiv présente un nouveau modèle d’IA conçu spécifiquement pour des applications médicales. Au cours des essais, la technologie a montré son efficacité en effectuant des diagnostics sur la base de dialogues avec les patients et en fournissant une assistance précieuse aux médecins pour certaines analyses. Il aurait même surpassé les modèles de la série GPT-4 d’OpenAI dans ces tâches.

Gemini est actuellement le modèle d’IA le plus avancé de Google DeepMind. Se déclinant en plusieurs versions, il est capable de traiter et d’interpréter des données issues de divers formats tels que le texte, les images, les vidéos et l’audio. Conscients du potentiel révolutionnaire de l’IA dans le secteur médical, les chercheurs de Google ont créé Med-Gemini, une version de Gemini spécifiquement adaptée et améliorée pour des applications médicales. Cette nouvelle IA a montré des résultats prometteurs lors des premiers essais, bien qu’elle nécessite encore des recherches approfondies pour garantir son déploiement sécurisé et efficace.

Un système entraîné à l’aide de MedQA

Med-Gemini a été formé à partir de MedQA, une base de données multilingue de questions à choix multiples, tirées de l’USMLE (United States Medical Licensing Examination), qui enregistre les compétences cliniques des médecins en formation. Cette base contient des dizaines de milliers de questions réparties en trois langues : plus de 12 700 en anglais, environ 34 200 en chinois simplifié et 14 100 en chinois traditionnel.

Pour renforcer les capacités du modèle, Google a développé deux extensions de cette base de données. La première, MedQA-R (R pour « reasoning »), est une extension de MedQA qui inclut des explications de raisonnement générées appelées « chaîne de pensées », offrant des explications détaillées pour chaque réponse. La seconde, MedQA-RS (RS pour « Reasoning and Search »), guide le modèle à mener des recherches sur le web et à utiliser les résultats pour améliorer ainsi la précision de ses réponses. Lors des essais sur MedQA, Med-Gemini a atteint une précision impressionnante de 91,1 %. Il aurait ainsi surpassé les modèles de la série GPT-4 d’OpenAI sur les mêmes tâches. Un exemple d’IA de diagnostic basée sur un modèle médical dérivé de GPT-4 est Jarvis Medical (que l’on peut essayer gratuitement).

Une bonne compréhension de grands ensembles de données

Les chercheurs ont également concentré leurs efforts sur l’amélioration de la capacité de Med-Gemini à traiter et analyser de vastes quantités d’informations médicales complexes. Pour tester cette aptitude, ils ont utilisé une grande base de données publique contenant des dossiers de santé anonymes.

Dans le cadre de cette expérience, environ 200 ensembles de données issues de cette source, chacun comprenant entre 200 000 et 700 000 mots, ont été préparés. Med-Gemini avait pour mission d’identifier et de récupérer des informations précises, comme des conditions médicales et des symptômes spécifiques, au sein de ces ensembles. Une fois ces informations extraites, l’IA devait évaluer leur pertinence, les catégoriser et déterminer si elles reflétaient des antécédents du patient liés à la condition ou aux symptômes concernés. Selon les chercheurs, l’expérience a fourni de bons résultats.

Des essais pratiques réussis haut la main

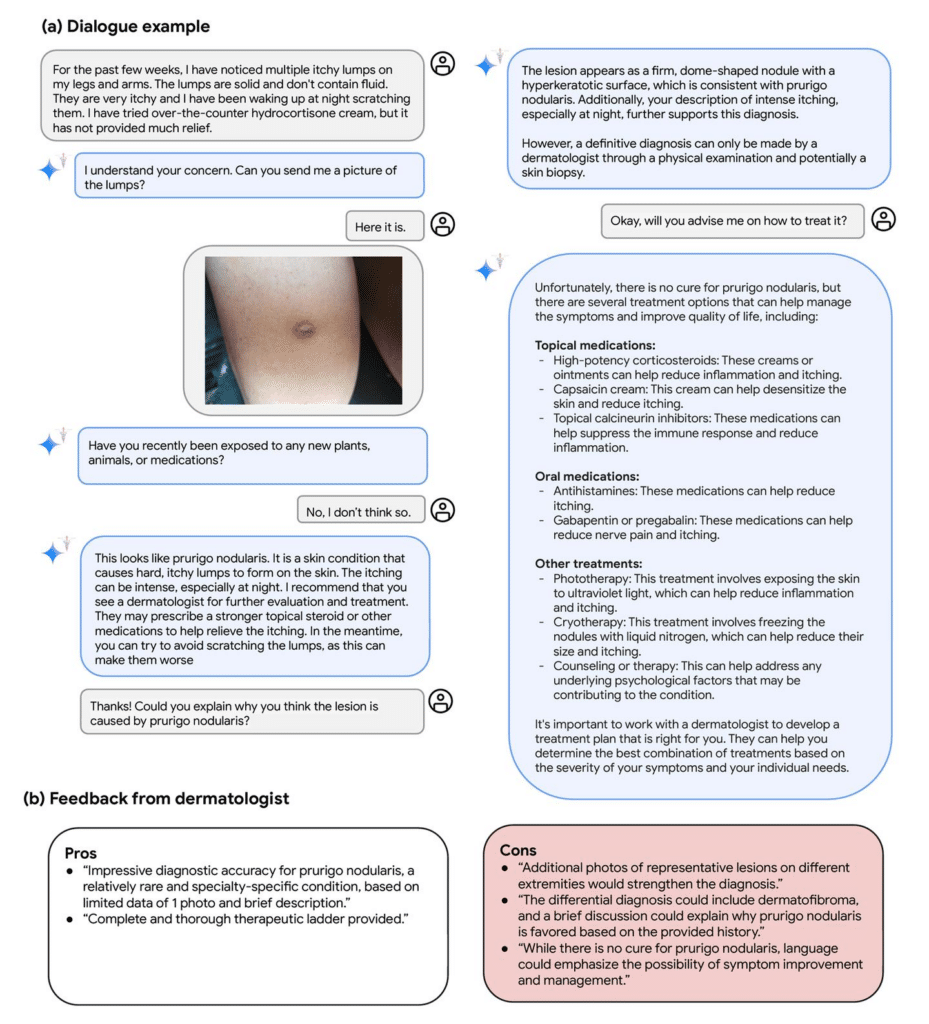

Med-Gemini a aussi été testé dans des situations pratiques qui ont illustré son utilité et ses capacités multimodales dans un contexte médical réel. Dans un premier scénario, un patient l’a utilisé pour obtenir un avis sur une protubérance cutanée qui lui provoquait des démangeaisons. Le modèle a demandé au patient de fournir une image de la lésion pour une meilleure évaluation. Après avoir reçu l’image, Med-Gemini a posé des questions supplémentaires pour affiner son diagnostic. Il a réussi à diagnostiquer correctement la lésion rare et a donné des recommandations sur les étapes à suivre.

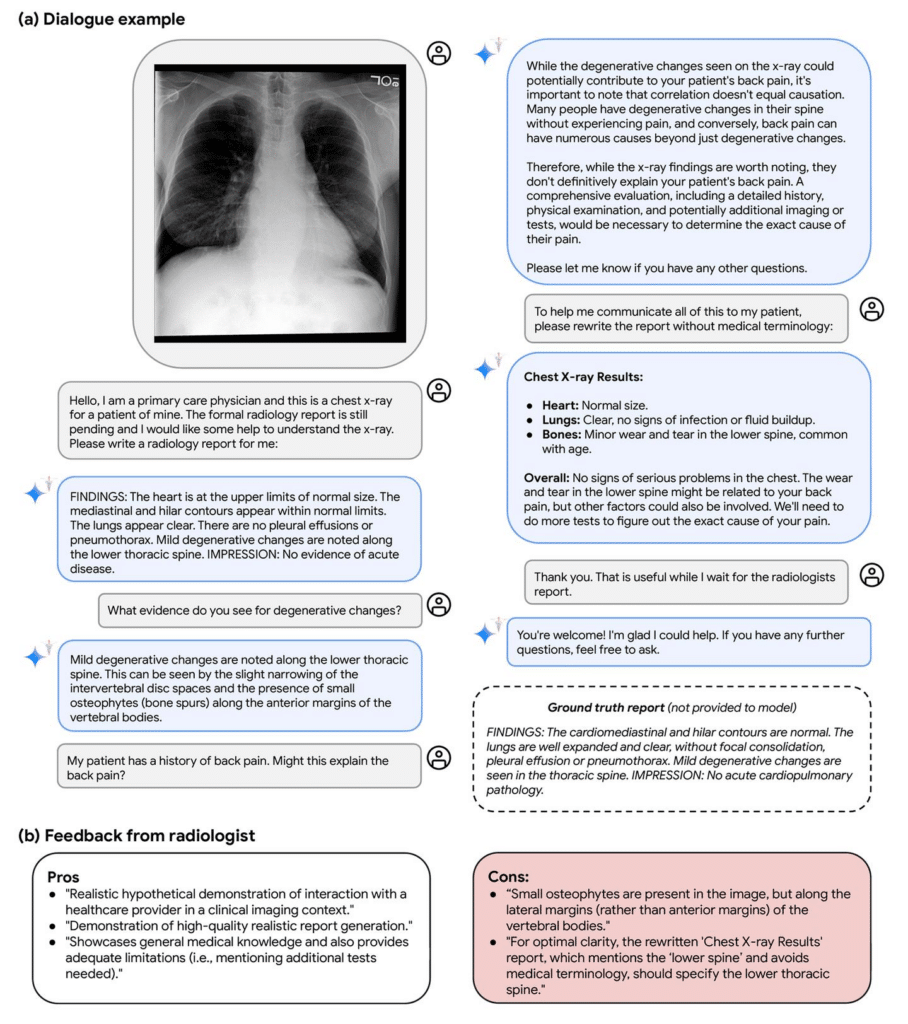

Dans un autre test, Med-Gemini a été utilisé par un médecin pour interpréter une radiographie pulmonaire avant que le rapport officiel du radiologue ne soit disponible. Le modèle a non seulement fourni une interprétation de l’image, mais a également formulé une version simplifiée du rapport en anglais simple, adaptée à la compréhension du patient.

Malgré les résultats obtenus, les chercheurs reconnaissent que des études supplémentaires sont nécessaires pour améliorer les capacités de conversation clinique de Med-Gemini. Cela vise à assurer la fiabilité et l’efficacité du modèle dans tous les scénarios d’utilisation médicale.