« Des réponses plus sûres et plus utiles », c’est ce que promet la dernière version de l’intelligence artificielle sur laquelle repose ChatGPT, GPT-4. OpenAI affirme que son IA est désormais aussi performante que les humains dans de nombreux contextes professionnels et académiques. Contrairement aux versions précédentes, GPT-4 comprend non seulement le texte, mais aussi les images, qu’il peut analyser et interpréter pour générer une description, une légende ou toute autre sortie textuelle.

L’exemple présenté sur le site d’OpenAI est assez éloquent : une image représentant des ingrédients (lait, œufs, farine…) est soumise à ChatGPT tout en lui demandant des idées de recette. L’IA a parfaitement reconnu les ingrédients présents sur l’image et suggère une liste de recettes appropriées. Et ce n’est qu’un exemple de ses nouvelles capacités ! Selon ses concepteurs, GPT-4 est « plus créatif et collaboratif que jamais ». Il s’avère ainsi particulièrement performant pour des tâches d’écriture créative et technique (chansons, scénarios, etc.).

Alors que ChatGPT montrait quelques difficultés à résoudre des problèmes mathématiques complexes, il est désormais doté de capacités de raisonnement avancées et de connaissances générales plus étendues, qui lui permettent de résoudre les problèmes difficiles. Enfin, cette version se veut plus sûre et plus juste : « D’après nos évaluations internes, GPT-4 est 82% moins susceptible de répondre aux demandes de contenu non autorisé et 40% plus susceptible de produire des réponses factuelles que GPT-3.5 », affirme OpenAI.

Des scores élevés à la plupart des tests et examens académiques

Non seulement GPT-4 peut reconnaître les différents éléments d’une image, mais il est capable de comprendre l’éventuel aspect insolite ou humoristique de l’ensemble ! Autre nouveauté : en plus des images, l’algorithme peut accepter en entrée des textes beaucoup plus longs, de plus de 25 000 mots ; cette capacité en fait un outil pratique pour la recherche et l’analyse de documents par exemple.

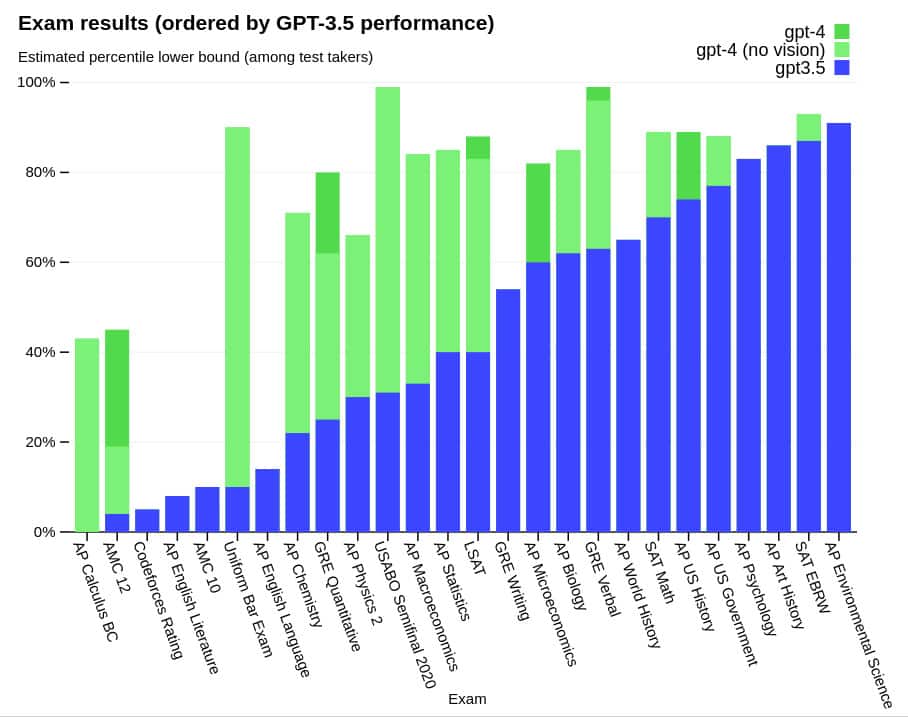

Les capacités de GPT-3.5 étaient déjà impressionnantes : le modèle de langage s’était montré en effet très performant lorsqu’il a été soumis à divers examens universitaires. Mais le rapport technique d’OpenAI montre que GPT-4 surpasse de loin son prédécesseur : l’algorithme a obtenu des scores exceptionnels à l’examen du barreau, au test d’admission à la faculté de droit (LSAT), aux tests de lecture et de mathématiques du SAT (Scholastic Assessment Test), ainsi qu’au test GRE (requis pour étudier dans la plupart des universités ou grandes écoles des pays anglophones).

GPT-4 a notamment obtenu un score de 163 sur 180 au LSAT, ce qui est supérieur de plus de dix points au score moyen (qui est de 152 selon The Princeton Review) ; son prédécesseur, GPT-3.5, n’avait obtenu que 149/180. GPT-4 s’illustre de la même façon dans tous les examens testés. Il a par exemple réussi l’examen simulé du barreau avec un score de 298/400, ce qui le place parmi les 10% supérieurs des candidats ; GPT-3.5 (213/400) se situait quant à lui dans les 10% inférieurs, souligne OpenAI.

Cette nouvelle version a également été évaluée via des benchmarks traditionnels, spécialement conçus pour les modèles d’apprentissage automatique. Sans surprise, GPT-4 surpasse les meilleurs grands modèles de langage existants, que ce soit en termes de raisonnement, de tâches de codage ou de compréhension écrite et arithmétique.

Une version qui présente encore des faiblesses

L’équipe a redoublé d’efforts pour améliorer le comportement de GPT-4. Il refuse par exemple d’expliquer à l’utilisateur comment créer une bombe. Si on lui demande où trouver des cigarettes bon marché, il répond bien à la question — ce que ne faisait pas la version précédente — mais commence par rappeler que le tabagisme est nocif pour la santé. « Dans l’ensemble, nos interventions au niveau du modèle augmentent la difficulté de susciter un mauvais comportement », résument les concepteurs.

Mais l’algorithme présente encore plusieurs limitations connues, telles que les préjugés sociaux, les hallucinations et les invites contradictoires, reconnaissent ses concepteurs. « Malgré ses capacités, GPT-4 a des limites similaires à celles des modèles GPT précédents. Plus important encore, il n’est toujours pas totalement fiable (il ‘hallucine’ les faits et fait des erreurs de raisonnement) », détaille OpenAI.

En particulier, il manque de connaissances sur les événements les plus récents — car les données sur lesquelles il a été formé s’arrêtent au mois de septembre 2021 — et peut se montrer trop crédule en acceptant de fausses déclarations évidentes d’un utilisateur. Par conséquent, « une grande attention doit être portée lors de l’utilisation des sorties du modèle de langage, en particulier dans des contextes à enjeux élevés », avertit OpenAI.

Dans l’immédiat, seuls les utilisateurs de ChatGPT Plus — la version payante de l’algorithme — et les internautes utilisant la toute dernière version du moteur de recherche Bing pourront tester GPT-4, mais sans le traitement d’images. Pour le moment, ces nouvelles capacités de « vision » sont uniquement exploitées par la start-up danoise Be My Eyes, qui a développé une application pour les personnes aveugles et malvoyantes capable d’interpréter et de décrire une partie de leur environnement (le contenu d’un réfrigérateur, l’apparence d’un vêtement, etc.).

D’autres entreprises ont d’ores et déjà intégré GPT-4 à leur service, telles que Duolingo, qui l’utilise en tant qu’agent conversationnel pour son application d’apprentissage de langues, et le service de paiement Stripe, qui l’utilise pour rationaliser l’expérience utilisateur et lutter contre la fraude.