De nombreuses images et séquences vidéo ont été prises lors des missions Apollo, soit directement par les astronautes eux-mêmes lors de leurs déplacements à la surface lunaire, soit via les caméras fixées au module lunaire. Cependant, ces images et vidéos sont souvent de mauvaise qualité ou saccadées. Mais aujourd’hui, les avancées effectuées dans le domaine de l’intelligence artificielle ont permis à un expert en restauration de publier ces séquences nettement améliorées, et les résultats sont saisissants.

De nouveaux développements dans l’intelligence artificielle ont permis d’importantes avancées sur la qualité des images historiques. Un spécialiste de la restauration de photos et de films, qui porte le nom de DutchSteamMachine, a utilisé l’IA pour améliorer le film original de la mission Apollo 16, créant des clips vidéo et des images d’une clarté et d’une vivacité saisissantes.

Ces images améliorées d’une traversée de rover lunaire lors de la mission Apollo 16 avec Charlie Duke et John Young, ont été tournées à l’origine avec 12 images par seconde (FPS) et ont été augmentées à 60 FPS :

Une séquence améliorée du site d’alunissage de la mission Apollo 15 dans la vallée d’Hadley Rille a également été publiée :

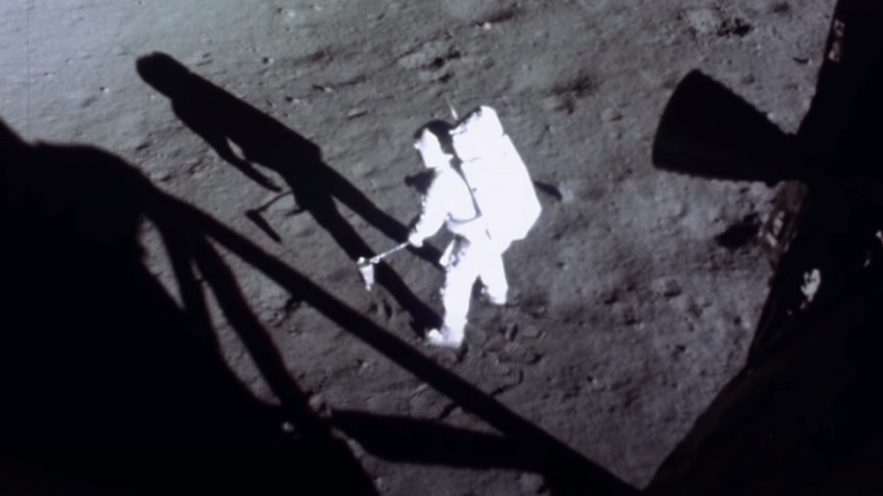

Enfin, la célèbre séquence du premier pas sur la Lune par Neil Armstrong lors de la mission Apollo 11, tournée par la caméra 16 mm du module lunaire, a elle aussi bénéficié d’une nette amélioration :

L’IA utilisée par DutchSteamMachine est appelée INterpolation de trame vidéo sensible à la profondeur (Depth-Aware video frame INterpolation), ou DAIN. Cette IA est open source, gratuite et constamment développée et améliorée. L’interpolation de mouvement ou l’interpolation d’images à compensation de mouvement est une forme de traitement vidéo dans laquelle des images d’animation intermédiaires sont générées entre les images existantes, dans le but de rendre la vidéo plus fluide, de compenser le flou, etc.

« Les gens ont utilisé les mêmes programmes d’IA pour redonner vie à de vieux enregistrements de films des années 1900, en haute définition et en couleur. Cette technique semblait être une bonne chose à appliquer à des séquences beaucoup plus récentes ». DutchSteamMachine a déclaré qu’une vidéo de seulement 5 minutes peut nécessiter de six à 20 heures de traitement. Mais les résultats parlent d’eux-mêmes.

Les détails du procédé de traitement amélioré des images

L’expert explique comment il effectue ce travail : « J’ai d’abord cherché des vidéos sources de la plus haute qualité, que j’ai heureusement trouvées en tant que fichiers vidéo 720p à haut débit. Le problème de qualité a donc été résolu. Il est important de commencer avec la source la plus élevée possible et de monter à partir de là. Cependant, la plupart des séquences tournées étaient encore très saccadées ».

« C’est parce que pour éviter de filmer et enregistrer pendant de longues périodes, la plupart des images du rover ont été tournées à 12, 6 ou même 1 image(s) par seconde. Alors que les gens ont déjà essayé d’appliquer une stabilisation et/ou des types de fusion d’images pour atténuer cet effet, je n’en ai jamais vraiment été satisfait ».

Sur le même sujet : Voici pourquoi il aurait été techniquement impossible de filmer les missions Apollo en studio

DutchSteamMachine cherche ensuite à quelle fréquence d’images les images ont été tournées, ce qui se trouve généralement dans les documents de la NASA ou, comme dans le cas des images Apollo 16 ci-dessus, les astronautes l’annoncent lorsqu’ils allument la caméra. « Malheureusement, parfois, le framerate semble être absent ou fluctuant, ne fonctionnant pas toujours comme prévu. La meilleure façon de trouver la fréquence d’images est donc d’écouter les points de repère dont parlent les astronautes et de faire correspondre les images à cela ».

« Je divise le fichier source en images PNG individuelles, les saisis dans l’IA avec le taux de trame d’entrée (1, 6, 12 ou 24) et le taux de trame de sortie souhaité par taux d’interpolation (2x, 4x, 8x). L’IA commence à utiliser le GPU et regarde deux images réelles et consécutives. À l’aide d’algorithmes, elle analyse les mouvements des objets dans les deux cadres et en rend des entièrement nouveaux. Avec un taux d’interpolation de par exemple 5x, elle est capable de rendre 5 images « fausses » à partir de seulement 2 images réelles ».

« Si le métrage a été enregistré à 12 images par seconde et que le taux d’interpolation est défini sur 5x, le taux de rafraîchissement final sera de 60, ce qui signifie qu’avec seulement 12 images réelles, elle a créé 48 images « fausses ». Les deux sont ensuite exportés vers une vidéo finale et lus à 60 images par seconde, incluant les images réelles et fausses ».

« Enfin, j’applique une correction des couleurs, car les fichiers source ont souvent une teinte bleue ou orange. Je synchronise les images avec l’audio et, si possible, la télévision et les photos prises en même temps. Parfois, deux caméras 16 mm fonctionnaient en même temps, je peux donc les lire l’une à côté de l’autre ».

Cette vidéo montre le procédé de traitement vidéo utilisé par DutchSteamMachine :